【C++】OpenCVでSIFTを活用した高精度特徴点検出とマッチング手法

OpenCVのC++環境でSIFTを利用すると、スケールや回転に対して不変な特徴点と記述子を自動検出できます。

cv::SIFT::create()とdetectAndComputeでシンプルに実装でき、物体認識や画像マッチングで高精度な結果が得られます。

SIFTオブジェクトの生成と設定

cv::SIFT::create()は、OpenCVのC++インターフェースにおいてSIFT(Scale-Invariant Feature Transform)アルゴリズムのインスタンスを生成するための静的メソッドです。

このメソッドを呼び出すことで、特徴点検出と記述子計算を行うための準備が整います。

ここでは、cv::SIFT::create()の引数について詳しく解説し、どのように調整すればより良い結果を得られるかを説明します。

cv::SIFT::create()の基本的な使い方

cv::Ptr<cv::SIFT> sift = cv::SIFT::create(nFeatures, nOctaveLayers, contrastThreshold, edgeThreshold, sigma);この関数は、上記の5つのパラメータを受け取り、それぞれの役割に応じて特徴点検出の挙動を調整します。

次に、それぞれのパラメータについて詳しく解説します。

nFeaturesの調整

nFeaturesは、検出される特徴点の最大数を指定します。

デフォルト値は0で、これは制限なくすべての特徴点を検出することを意味します。

ただし、処理時間やメモリの制約を考慮し、必要に応じてこの値を設定します。

- 値を大きく設定:より多くの特徴点を検出し、詳細な情報を得ることが可能です。ただし、計算コストが増加します

- 値を小さく設定:処理速度が向上しますが、重要な特徴点を見逃す可能性があります

例:nFeatures = 500と設定すると、最大500個の特徴点を検出します。

contrastThresholdとedgeThreshold

これらは、特徴点の検出において重要な閾値設定です。

contrastThreshold(コントラスト閾値)

- 役割:局所的なコントラストがこの閾値より低い特徴点は除外されます

- デフォルト値:0.04

- 調整のポイント:

- 低く設定:より多くの特徴点を検出しますが、ノイズや不要な点も増える可能性があります

- 高く設定:コントラストの高い、より顕著な特徴点のみを抽出します

例:contrastThreshold = 0.03に設定すると、より敏感に特徴点を検出します。

edgeThreshold(エッジ閾値)

- 役割:エッジに沿った特徴点の除外に使われます。エッジに沿った点は、安定性に欠けるため除外されることが多いです

- デフォルト値:10

- 調整のポイント:

- 低く設定:エッジに沿った特徴点も多く検出されるため、ノイズや誤検出のリスクが増えます

- 高く設定:エッジに沿った点を除外し、より安定した特徴点を得られます

例:edgeThreshold = 15と設定すると、エッジに沿った点の除外が厳しくなります。

sigmaとoctaveLayers

これらは、スケール空間の構築に関わるパラメータです。

sigma(標準偏差)

- 役割:最初のスケールレベルのガウシアンブラーの標準偏差を設定します

- デフォルト値:1.6

- 調整のポイント:

- 低く設定:より細かいスケールの特徴点を検出可能です

- 高く設定:大きなスケールの特徴点に焦点を当てることになります

例:sigma = 1.2に設定すると、より細かい特徴点が検出されやすくなります。

octaveLayers(オクターブ内のレイヤー数)

- 役割:各オクターブ内でのガウシアンブラーの適用回数を示します

- デフォルト値:3

- 調整のポイント:

- 多く設定:より詳細なスケール空間の表現が可能となり、精度が向上します

- 少なく設定:計算コストが低減しますが、スケールの表現が粗くなる可能性があります

例:octaveLayers = 4と設定すると、より細かいスケールの検出が可能です。

cv::SIFT::create()のパラメータは、検出したい特徴点の性質や処理速度に大きく影響します。

適切な値を選択することで、画像の内容や用途に最適な特徴点検出が可能となります。

特徴点検出と記述子計算

detectAndComputeは、OpenCVのcv::SIFTクラスにおいて、画像から特徴点を検出し、それに対応する記述子を同時に計算するための便利なメソッドです。

この関数を理解し、適切に使いこなすことで、画像マッチングや物体認識の精度を向上させることができます。

detectAndComputeの使い方

#include <opencv2/opencv.hpp>

int main() {

// 画像の読み込み(グレースケール)

cv::Mat image = cv::imread("sample.jpg", cv::IMREAD_GRAYSCALE);

if (image.empty()) {

std::cerr << "画像の読み込みに失敗しました。" << std::endl;

return -1;

}

// SIFTインスタンスの作成

cv::Ptr<cv::SIFT> sift = cv::SIFT::create();

// 特徴点と記述子を格納する変数

std::vector<cv::KeyPoint> keypoints;

cv::Mat descriptors;

// detectAndComputeの呼び出し

// 画像から特徴点を検出し、記述子を計算

sift->detectAndCompute(image, cv::noArray(), keypoints, descriptors);

// 検出された特徴点の数を出力

std::cout << "検出された特徴点の数: " << keypoints.size() << std::endl;

// 特徴点の描画

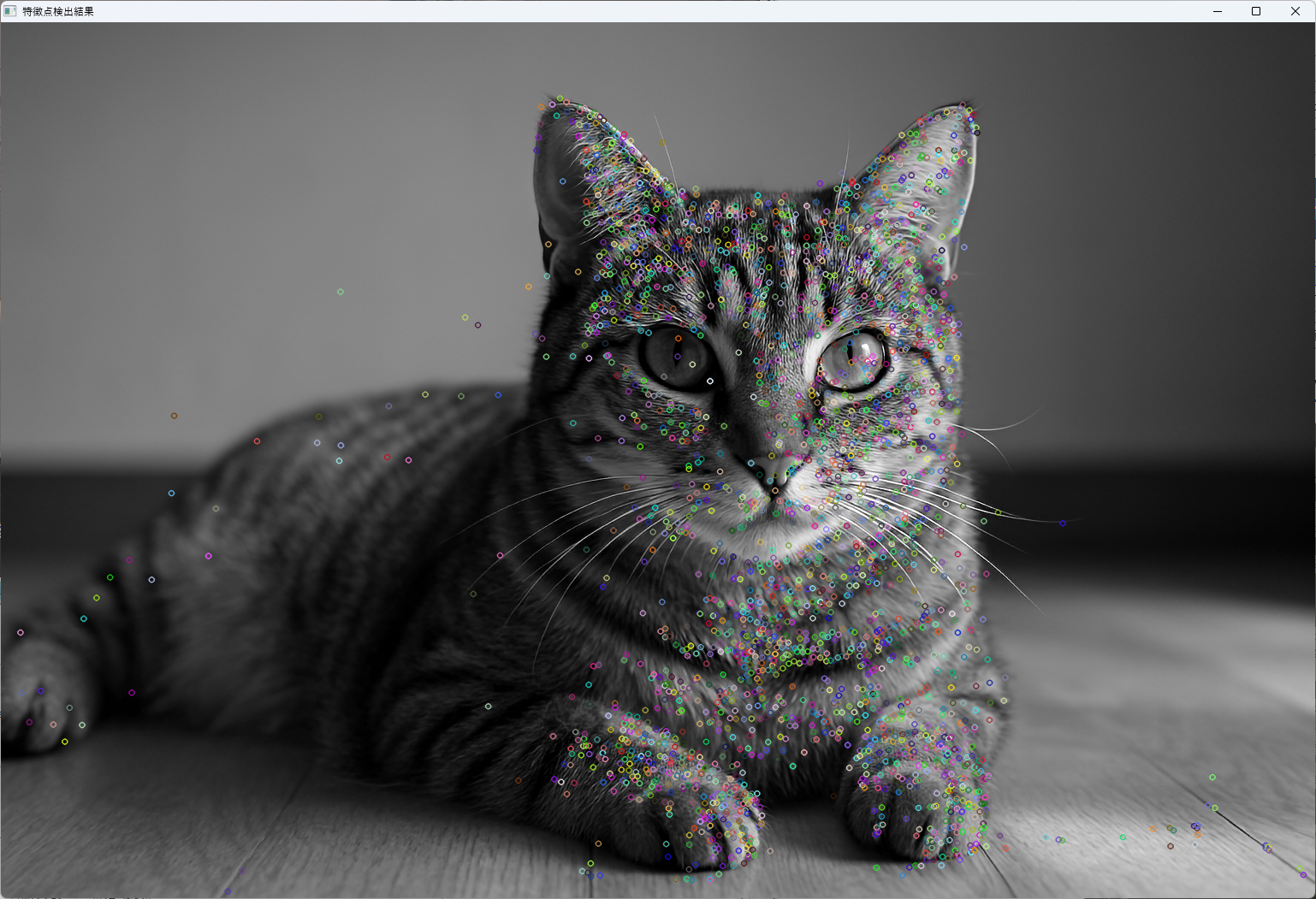

cv::Mat outputImage;

cv::drawKeypoints(image, keypoints, outputImage);

cv::imshow("特徴点検出結果", outputImage);

cv::waitKey(0);

return 0;

}

このコードでは、detectAndComputeを使って画像から特徴点と記述子を同時に抽出しています。

detectAndComputeの引数は以下の通りです。

- 画像:入力画像(グレースケール推奨)

- mask:検出対象の領域を限定するマスク(今回は

cv::noArray()で全体を対象) - keypoints:検出された特徴点の情報を格納するベクター

- descriptors:特徴点に対応する記述子を格納する行列

この関数は、検出と記述子計算を一度に行うため、処理の効率化に役立ちます。

キーポイント検出の流れ

detectAndComputeの内部処理は、以下のステップで進行します。

- スケール空間の構築

画像に対して複数のスケール(大きさ)でガウシアンブラーを適用し、スケール空間を作成します。

- 差分画像の生成(DoG)

スケール空間の隣接するレイヤー間の差分を計算し、Difference of Gaussians(DoG)画像を作成します。

- 局所極値の検出

DoG画像の各ピクセルについて、周囲の26ピクセル(3x3x3の立方体)と比較し、局所的な極値(最大または最小)を検出します。

- スケールと位置の局所化

検出された極値点の位置とスケールを記録し、次の段階へ進みます。

- 特徴点の選別と除外

コントラストが低すぎる点やエッジに沿った点を除外し、安定した特徴点だけを残します。

ディスクリプタ計算の流れ

特徴点が局所化された後、次のステップで記述子の計算に入ります。

- 局所領域の抽出

検出された特徴点の周囲に、一定のサイズの局所領域を設定します。

- 方向の割り当て

領域内の勾配情報を解析し、主要な方向を決定します。

これにより、回転に対して不変な記述子が作成可能です。

- 勾配ヒストグラムの作成

領域内のピクセルの勾配の大きさと方向を集計し、ヒストグラムを作成します。

- 記述子の生成

ヒストグラムを正規化し、128次元のベクトルとして記述子を作成します。

この一連の処理により、特徴点ごとに一意な記述子が生成され、画像間のマッチングに利用されます。

スケール空間の扱い

SIFTは、画像のスケールに対して不変性を持たせるために、スケール空間を積極的に利用します。

これにより、拡大・縮小や回転に対しても安定した特徴点の検出と記述が可能です。

Difference of Gaussiansによる近似

DoGは、ガウシアンブラーを適用した画像の差分を取ることで、ラプラシアン・オブ・ガウシアン(LoG)の近似を行います。

計算コストが低いため、実用的な特徴点検出手法として広く使われています。

\[\text{DoG}(x, y, \sigma) = G(x, y, k\sigma) – G(x, y, \sigma)\]

ここで、\(G\)はガウシアン平滑化を表し、\(\sigma\)は標準偏差です。

キーポイントの局所化と精錬

検出された極値点は、最初の候補に過ぎません。

次に、コントラスト閾値やエッジ閾値を用いて、安定性の低い点を除外します。

これにより、画像のノイズやエッジに沿った点の影響を排除し、信頼性の高い特徴点だけを残します。

局所化と精錬の過程は、検出結果の精度を大きく左右します。

適切な閾値設定により、検出結果の質を向上させることが可能です。

このように、detectAndComputeは、スケール空間の構築から特徴点の検出、記述子の計算までを一連の流れで行うため、効率的かつ高精度な特徴点抽出を実現します。

可視化と基本操作

cv::drawKeypointsは、検出された特徴点を画像上に視覚的に表現するための関数です。

これにより、特徴点の分布や検出の結果を直感的に理解でき、画像処理やマッチングの評価に役立ちます。

ここでは、drawKeypointsの使い方と、そのオプション設定、さらに複数画像を比較する方法について詳しく解説します。

drawKeypointsでの描画オプション

#include <opencv2/opencv.hpp>

int main() {

// 画像の読み込み

cv::Mat image = cv::imread("sample.jpg");

if (image.empty()) {

std::cerr << "画像の読み込みに失敗しました。" << std::endl;

return -1;

}

// 例として、検出された特徴点を用意

std::vector<cv::KeyPoint> keypoints;

// ここでは仮にいくつかのKeyPointを作成

keypoints.emplace_back(cv::KeyPoint(100, 100, 10, -1, 0, 0, -1));

keypoints.emplace_back(cv::KeyPoint(200, 150, 15, -1, 0, 0, -1));

// 描画オプションの設定

auto flags = cv::DrawMatchesFlags::DEFAULT; // デフォルト設定

// flagsには他にも以下のオプションがある

// cv::DrawMatchesFlags::DRAW_OVER_OUTIMG

// cv::DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS

// cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS

// 特徴点の描画

cv::Mat outputImage;

cv::drawKeypoints(image, keypoints, outputImage, cv::Scalar(0, 255, 0),

flags);

// 表示

cv::imshow("特徴点の可視化", outputImage);

cv::waitKey(0);

return 0;

}drawKeypointsの第4引数は描画色を指定します。

上記例では緑色cv::Scalar(0, 255, 0)を使用しています。

キーポイントサイズや向きの表示

cv::KeyPointには、位置pt、サイズsize、向きangleなどの情報が含まれています。

drawKeypointsは、これらの情報をもとに、特徴点のサイズや向きを画像上に描画します。

- サイズ:

sizeの値に比例した円が描かれ、特徴点の大きさを視覚的に表現します - 向き:

angleの値に基づき、矢印や線が特徴点の方向を示します

// rich keypointsを描画する例

cv::drawKeypoints(image, keypoints, outputImage, cv::Scalar(255, 0, 0), cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);この設定では、特徴点のサイズと向きがわかりやすく表示され、検出結果の詳細な理解に役立ちます。

複数画像での比較表示

複数の画像に対して特徴点を検出し、その結果を並べて比較したい場合は、cv::hconcatやcv::vconcatを使って画像を横または縦に結合します。

#include <opencv2/opencv.hpp>

int main() {

// 画像の読み込み

cv::Mat img1 = cv::imread("image1.jpg");

cv::Mat img2 = cv::imread("image2.jpg");

if (img1.empty() || img2.empty()) {

std::cerr << "画像の読み込みに失敗しました。" << std::endl;

return -1;

}

// 特徴点の検出と描画(例として同じ処理を繰り返す)

cv::Ptr<cv::SIFT> sift = cv::SIFT::create();

std::vector<cv::KeyPoint> keypoints1, keypoints2;

cv::Mat descriptors1, descriptors2;

sift->detectAndCompute(img1, cv::noArray(), keypoints1, descriptors1);

sift->detectAndCompute(img2, cv::noArray(), keypoints2, descriptors2);

cv::Mat img1_kp, img2_kp;

cv::drawKeypoints(img1, keypoints1, img1_kp, cv::Scalar(0, 255, 0), cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

cv::drawKeypoints(img2, keypoints2, img2_kp, cv::Scalar(0, 255, 0), cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

// 横に結合

cv::Mat combined;

cv::hconcat(img1_kp, img2_kp, combined);

// 表示

cv::imshow("比較画像", combined);

cv::waitKey(0);

return 0;

}この方法により、複数の画像の特徴点検出結果を一度に比較でき、検出の精度や特徴点の分布を視覚的に評価できます。

cv::drawKeypointsは、シンプルながらも強力な可視化ツールです。

適切なオプション設定とともに使うことで、検出結果の理解やデバッグに大きく役立ちます。

特徴量マッチング

特徴量マッチングは、異なる画像間で同一の物体やシーンを認識するために不可欠な工程です。

OpenCVでは、BFMatcher(Brute-Force Matcher)を用いて、検出された特徴点の記述子同士の距離を計算し、最も類似した特徴点のペアを見つけ出します。

ここでは、BFMatcherの使い方と、その距離計算におけるNormTypeの選択基準、さらにマッチング結果の精度を向上させるための比率テストと、外れ値を除去するためのRANSACの活用について詳しく解説します。

BFMatcherによる距離計算

#include <opencv2/opencv.hpp>

#include <vector>

int main() {

// 例として、2つの画像の記述子を用意

cv::Mat descriptors1, descriptors2;

// ここでは仮に空の行列を用意

// 実際にはdetectAndComputeで得られた記述子を使用

// BFMatcherの作成

cv::BFMatcher matcher(cv::NORM_L2, false); // L2ノルムを使用し、クロスマッチは無効

// マッチングの実行

std::vector<cv::DMatch> matches;

matcher.match(descriptors1, descriptors2, matches);

// マッチング結果の出力

for (const auto& match : matches) {

std::cout << "QueryIdx: " << match.queryIdx

<< " TrainIdx: " << match.trainIdx

<< " Distance: " << match.distance << std::endl;

}

return 0;

}BFMatcherは、全ての記述子のペアについて距離を計算し、最も距離が小さいペアをマッチングします。

matchメソッドは、各記述子に対して最も類似したもう一方の画像の記述子を見つけ出します。

NormTypeの選択基準

BFMatcherのコンストラクタの第1引数は距離の計算方法を指定します。

代表的な選択肢は以下の通りです。

| NormType | 説明 | 使用例 |

|---|---|---|

cv::NORM_L2 | ユークリッド距離(2乗和の平方根) | SIFTやSURFの記述子に適用 |

cv::NORM_HAMMING | ハミング距離 | ORBやBRISKのバイナリ記述子に適用 |

SIFTやSURFのような浮動小数点の記述子にはcv::NORM_L2を選びます。

一方、バイナリ記述子(ORBやBRISK)にはcv::NORM_HAMMINGを選択します。

Loweの比率テストによるフィルタリング

マッチング結果には、誤ったマッチや外れ値も含まれるため、これらを除外するためにLoweの比率テストを行います。

#include <opencv2/opencv.hpp>

#include <vector>

int main() {

// 例として、2つの画像の記述子を用意

cv::Mat descriptors1, descriptors2;

// ここでは仮に空の行列を用意

// 実際にはdetectAndComputeで得られた記述子を使用

// BFMatcherの作成

cv::BFMatcher matcher(cv::NORM_L2,

false); // L2ノルムを使用し、クロスマッチは無効

// マッチングの実行

std::vector<cv::DMatch> matches;

matcher.match(descriptors1, descriptors2, matches);

// マッチング結果の出力

for (const auto& match : matches) {

std::cout << "QueryIdx: " << match.queryIdx

<< " TrainIdx: " << match.trainIdx

<< " Distance: " << match.distance << std::endl;

}

std::cout << "Number of matches: " << matches.size() << std::endl;

return 0;

}この方法では、各特徴点に対して最も近い2つの候補を見つけ、その距離比を比較します。

比率が閾値以下の場合、そのマッチは信頼性が高いと判断されます。

RANSACを使った外れ値除去

マッチング結果には、誤った対応(外れ値)が含まれることが多いため、これらを除去し、正確な対応関係を見つけるためにRANSAC(Random Sample Consensus)を用います。

findHomographyの活用

#include <opencv2/opencv.hpp>

#include <vector>

int main() {

// 例として、良好なマッチングペアのポイントを抽出

std::vector<cv::Point2f> points1, points2;

// ここでは仮のポイントを用意

// 実際にはマッチングペアから抽出

// RANSACを用いてホモグラフィ行列を推定

cv::Mat mask;

cv::Mat H = cv::findHomography(points1, points2, cv::RANSAC, 3, mask);

// 外れ値のマスクを確認

for (size_t i = 0; i < mask.rows; i++) {

if (mask.at<uchar>(i)) {

// この対応は信頼できる

} else {

// この対応は外れ値

}

}

// 外れ値を除いたマッチングを再構築可能

return 0;

}findHomographyは、対応点の集合からホモグラフィ行列を推定し、その過程でRANSACを用いて外れ値を除外します。

maskには、信頼できる対応点が1、外れ値が0として格納されます。

これらの手法を組み合わせることで、特徴点マッチングの精度を大きく向上させることが可能です。

マッチング結果の描画

cv::drawMatchesは、2つの画像間で検出された特徴点のマッチング結果を視覚的に表現するための関数です。

これにより、どの特徴点が対応付けられたかを一目で確認でき、マッチングの正確さや外れ値の有無を評価するのに役立ちます。

ここでは、drawMatchesのオプション設定と、その結果を用いたマッチ数やマッチ精度の表示方法について詳しく解説します。

drawMatchesのオプション解説

#include <opencv2/opencv.hpp>

int main() {

// 画像の読み込み

cv::Mat img1 = cv::imread("image1.jpg");

cv::Mat img2 = cv::imread("image2.jpg");

if (img1.empty() || img2.empty()) {

std::cerr << "画像の読み込みに失敗しました。" << std::endl;

return -1;

}

// 特徴点とマッチング結果の例

std::vector<cv::KeyPoint> keypoints1, keypoints2;

std::vector<cv::DMatch> matches;

// ここでは仮のデータを用意

// 実際にはdetectAndComputeとマッチング結果を使用

// drawMatchesの呼び出し

cv::Mat resultImage;

cv::drawMatches(

img1, keypoints1,

img2, keypoints2,

matches,

resultImage,

cv::Scalar(0, 255, 0), // マッチング線の色(緑)

cv::Scalar(255, 0, 0), // マッチング点の色(青)

std::vector<char>(), // マッチングのマスク(省略可)

cv::DrawMatchesFlags::DEFAULT // 描画フラグ

);

// 表示

cv::imshow("マッチング結果", resultImage);

cv::waitKey(0);

return 0;

}drawMatchesの主なオプションは以下の通りです。

- 第6引数(matches):マッチング結果のリスト

- 第7引数(outImg):描画結果の出力先画像

- 第8引数(matchColor):マッチング線の色

- 第9引数(singlePointColor):特徴点の色(マッチングしない点も含む場合)

- 第10引数(matchesMask):マッチングの有効・無効を示すマスク(省略可能)

- 第11引数(flags):描画の詳細設定

cv::DrawMatchesFlagsにはいくつかのオプションがあり、例えばNOT_DRAW_SINGLE_POINTSを指定すると、マッチングしなかった特徴点を描画しません。

DRAW_RICH_KEYPOINTSを指定すると、特徴点のサイズや向きも描画に反映され、より詳細な可視化が可能です。

マッチ数やマッチ精度の表示方法

マッチング結果の評価には、マッチ数やマッチの質を示す指標を用います。

マッチ数の表示

std::cout << "マッチング数: " << matches.size() << std::endl;これは、検出された有効なマッチの総数を示し、マッチングの成功度を簡単に把握できます。

マッチ精度の評価

マッチングの精度を定量的に評価するために、次のような指標を用います。

- 平均距離:すべてのマッチの距離の平均値。値が小さいほど良好なマッチングといえます

- 最良・最悪距離:最も良いマッチと最も悪いマッチの距離を比較

double totalDistance = 0.0;

for (const auto& match : matches) {

totalDistance += match.distance;

}

double averageDistance = totalDistance / matches.size();

std::cout << "平均距離: " << averageDistance << std::endl;マッチング結果の可視化と評価

マッチング結果の画像に、マッチ数や平均距離をテキストとして描画することも可能です。

cv::Mat displayImage;

resultImage.copyTo(displayImage);

cv::putText(displayImage, "Matches: " + std::to_string(matches.size()), cv::Point(10, 30),

cv::FONT_HERSHEY_SIMPLEX, 1.0, cv::Scalar(255, 255, 255), 2);

cv::putText(displayImage, "Avg Dist: " + std::to_string(averageDistance), cv::Point(10, 60),

cv::FONT_HERSHEY_SIMPLEX, 1.0, cv::Scalar(255, 255, 255), 2);

cv::imshow("マッチング結果と評価", displayImage);

cv::waitKey(0);このように、マッチング結果の描画とともに、数値情報を画像上に表示することで、結果の理解や比較が容易になります。

cv::drawMatchesは、マッチング結果の視覚化において非常に便利な関数です。

適切なオプション設定とともに使うことで、マッチングの成功度や外れ値の有無を直感的に把握でき、次の処理や調整に役立てることができます。

応用シナリオ

パノラマ画像合成への組み込み

パノラマ画像合成は、複数の画像をつなぎ合わせて広い視野の一枚の画像を作成する技術です。

特徴点検出とマッチングを基盤として、画像間の幾何学的関係を推定し、シームレスに結合します。

Homography計算と画像ブレンディング

まず、対応する特徴点のペアからホモグラフィ行列を推定します。

これにより、ある画像の座標系を別の画像の座標系に変換できるため、画像を正確に重ね合わせることが可能です。

#include <opencv2/opencv.hpp>

#include <vector>

int main() {

// 画像の読み込み

cv::Mat img1 = cv::imread("image1.jpg");

cv::Mat img2 = cv::imread("image2.jpg");

if (img1.empty() || img2.empty()) {

std::cerr << "画像の読み込みに失敗しました。" << std::endl;

return -1;

}

// 特徴点と記述子の検出とマッチング(省略)

std::vector<cv::KeyPoint> keypoints1, keypoints2;

cv::Mat descriptors1, descriptors2;

// detectAndComputeとマッチング処理を行う

// マッチング結果から対応点を抽出

std::vector<cv::DMatch> matches;

// matchesに対応点ペアを格納

std::vector<cv::Point2f> points1, points2;

for (const auto& match : matches) {

points1.push_back(keypoints1[match.queryIdx].pt);

points2.push_back(keypoints2[match.trainIdx].pt);

}

// ホモグラフィ行列の推定

cv::Mat mask;

cv::Mat H = cv::findHomography(points1, points2, cv::RANSAC, 3, mask);

// 画像の変換とブレンディング

cv::Mat result;

cv::warpPerspective(img1, result, H, cv::Size(img1.cols + img2.cols, std::max(img1.rows, img2.rows)));

cv::Mat roi(result, cv::Rect(0, 0, img2.cols, img2.rows));

img2.copyTo(roi);

// 結果の表示

cv::imshow("パノラマ合成", result);

cv::waitKey(0);

return 0;

}この例では、cv::warpPerspectiveを用いて画像を変換し、cv::addWeightedやcv::seamlessCloneを使ってシームレスなブレンディングを行います。

画像の重なり部分の違和感を抑えるために、ブレンディングの手法やシームラインの調整も重要です。

動画フレーム間の特徴点追跡

動画の連続フレーム間で特徴点を追跡することで、動きの解析や安定したマッチングを実現します。

特徴点追跡は、フレーム間の変化を追いながら、物体の動きやカメラの動きを推定するのに役立ちます。

フレームレートと検出頻度の調整

追跡の精度と計算負荷のバランスを取るために、フレームレートや特徴点の検出頻度を調整します。

#include <opencv2/opencv.hpp>

#include <vector>

int main() {

cv::VideoCapture cap("video.mp4");

if (!cap.isOpened()) {

std::cerr << "動画のオープンに失敗しました。" << std::endl;

return -1;

}

cv::Mat prevFrame, currFrame;

std::vector<cv::KeyPoint> prevKeypoints, currKeypoints;

cv::Mat prevDescriptors, currDescriptors;

// 最初のフレームの取得

cap >> prevFrame;

cv::cvtColor(prevFrame, prevFrame, cv::COLOR_BGR2GRAY);

cv::Ptr<cv::SIFT> sift = cv::SIFT::create();

// 最初の特徴点検出

sift->detectAndCompute(prevFrame, cv::noArray(), prevKeypoints, prevDescriptors);

while (true) {

cap >> currFrame;

if (currFrame.empty()) break;

cv::cvtColor(currFrame, currFrame, cv::COLOR_BGR2GRAY);

// 特徴点の検出と記述子の計算

sift->detectAndCompute(currFrame, cv::noArray(), currKeypoints, currDescriptors);

// 特徴点の追跡(マッチング)

cv::BFMatcher matcher(cv::NORM_L2);

std::vector<cv::DMatch> matches;

matcher.match(prevDescriptors, currDescriptors, matches);

// マッチング結果から動きの推定やトラッキング

// 例:良好なマッチのみを抽出し、動きの平均を計算

// 次のフレームの準備

prevFrame = currFrame.clone();

prevKeypoints = currKeypoints;

prevDescriptors = currDescriptors;

}

return 0;

}フレームレートと検出頻度の調整ポイント

- 高フレームレート:動きの追跡精度は向上しますが、計算負荷も増大します

- 低フレームレート:処理速度は向上しますが、動きの追跡が追いつかない場合があります

- 特徴点の再検出頻度:追跡の安定性を保つために、一定のフレームごとに特徴点を再検出し、追跡の精度を維持します

例えば、一定のフレーム数ごとにdetectAndComputeを再呼び出し、追跡の精度と速度のバランスを取る工夫が必要です。

これらの応用シナリオは、実際の画像処理やコンピュータビジョンのシステムにおいて非常に重要です。

パノラマ合成では画像の整合性とシームレスな結合を実現し、動画追跡では動きの解析や安定した映像処理を可能にします。

パフォーマンス最適化

画像処理や特徴点検出・マッチングの処理は計算負荷が高いため、効率的な実装が求められます。

ここでは、並列処理とGPUアクセラレーションを活用した最適化手法について詳しく解説します。

並列処理による高速化

複数の画像や特徴点の処理を同時に行うことで、処理時間を大幅に短縮できます。

OpenCVは、OpenMPやスレッドプールを用いた並列処理をサポートしています。

OpenMPの導入

OpenMPは、簡単に並列化を実現できるAPIです。

#pragma omp parallel forディレクティブを用いることで、ループ処理を複数のスレッドに分散させることが可能です。

#include <opencv2/opencv.hpp>

#include <omp.h>

#include <vector>

int main() {

std::vector<cv::Mat> images; // 複数画像のリスト

// 画像の読み込み(省略)

std::vector<std::vector<cv::KeyPoint>> allKeypoints(images.size());

std::vector<cv::Mat> allDescriptors(images.size());

#pragma omp parallel for

for (int i = 0; i < images.size(); ++i) {

cv::Ptr<cv::SIFT> sift = cv::SIFT::create();

sift->detectAndCompute(images[i], cv::noArray(), allKeypoints[i], allDescriptors[i]);

}

// 以降の処理

return 0;

}この例では、複数画像に対して特徴点検出と記述子計算を並列に行っています。

#pragma omp parallel forを付けるだけで、ループ内の処理が複数のスレッドに分散され、処理速度が向上します。

ThreadPool利用例

スレッドプールを用いると、タスクの管理とスレッドの再利用が効率的に行えます。

C++標準ライブラリにはスレッドプールは含まれていませんが、Boostや他のライブラリを利用することで実現可能です。

#include <opencv2/opencv.hpp>

#include <thread>

#include <vector>

#include <queue>

#include <mutex>

#include <condition_variable>

class ThreadPool {

public:

ThreadPool(size_t num_threads);

~ThreadPool();

void enqueue(std::function<void()> task);

private:

std::vector<std::thread> workers;

std::queue<std::function<void()>> tasks;

std::mutex queue_mutex;

std::condition_variable condition;

bool stop;

};

ThreadPool::ThreadPool(size_t num_threads) : stop(false) {

for (size_t i = 0; i < num_threads; ++i) {

workers.emplace_back([this] {

while (true) {

std::function<void()> task;

{

std::unique_lock<std::mutex> lock(this->queue_mutex);

this->condition.wait(lock, [this] { return this->stop || !this->tasks.empty(); });

if (this->stop && this->tasks.empty()) return;

task = std::move(this->tasks.front());

this->tasks.pop();

}

task();

}

});

}

}

void ThreadPool::enqueue(std::function<void()> task) {

{

std::unique_lock<std::mutex> lock(queue_mutex);

tasks.push(task);

}

condition.notify_one();

}

ThreadPool::~ThreadPool() {

{

std::unique_lock<std::mutex> lock(queue_mutex);

stop = true;

}

condition.notify_all();

for (std::thread &worker : workers) {

worker.join();

}

}

// 使用例

int main() {

ThreadPool pool(4); // 4スレッドのプールを作成

// 画像リスト

std::vector<cv::Mat> images; // 画像の読み込みは省略

for (auto &img : images) {

pool.enqueue([&img]() {

cv::Ptr<cv::SIFT> sift = cv::SIFT::create();

std::vector<cv::KeyPoint> keypoints;

cv::Mat descriptors;

sift->detectAndCompute(img, cv::noArray(), keypoints, descriptors);

// 追加処理

});

}

// すべてのタスク完了まで待つ

// デストラクタ呼び出しで自動的に待機

return 0;

}このように、スレッドプールを用いると、タスクの管理とスレッドの再利用が効率的に行え、処理速度の向上に寄与します。

GPUアクセラレーション

GPUを活用することで、特徴点検出やマッチング処理の高速化が可能です。

OpenCVはCUDA対応のモジュールを提供しており、GPUの計算能力を最大限に引き出すことができます。

CUDA対応の実装ポイント

- CUDAビルドの設定:OpenCVのCUDAモジュールを有効にしてビルドする必要があります

- GPUメモリ管理:画像や特徴点データをGPUメモリに転送し、処理後に結果をホストメモリに戻します

- CUDA対応の特徴点検出器:

cv::cuda::SIFTやcv::cuda::ORBなどを使用

#include <opencv2/opencv.hpp>

#include <opencv2/cudaimgproc.hpp>

#include <opencv2/cudafeatures2d.hpp>

int main() {

// 画像の読み込み

cv::Mat img_host = cv::imread("image.jpg", cv::IMREAD_GRAYSCALE);

if (img_host.empty()) return -1;

// GPUメモリに転送

cv::cuda::GpuMat img_gpu;

img_gpu.upload(img_host);

// CUDA SIFTの作成

cv::Ptr<cv::cuda::SIFT> sift = cv::cuda::SIFT::create();

// 特徴点と記述子の検出

std::vector<cv::KeyPoint> keypoints;

cv::cuda::GpuMat descriptors_gpu;

sift->detectAndComputeAsync(img_gpu, cv::cuda::GpuMat(), keypoints, descriptors_gpu);

// 結果をホストにダウンロード

cv::Mat descriptors;

descriptors_gpu.download(descriptors);

// 特徴点の描画(CPU側で行う)

cv::Mat output;

cv::drawKeypoints(img_host, keypoints, output);

cv::imshow("GPU SIFT", output);

cv::waitKey(0);

return 0;

}実装のポイント

- メモリの効率的な管理:GPUとホスト間のデータ転送はコストが高いため、必要な処理をGPU上で完結させます

- 非同期処理の活用:

detectAndComputeAsyncなどの非同期APIを利用し、処理の並列化と高速化を図ります - 適切なハードウェア選定:CUDA対応GPUの性能に応じて、処理速度と精度のバランスを調整

これらの最適化手法を適用することで、大規模な画像データや動画処理においても、リアルタイム性や効率性を確保できます。

パラメータチューニング例

パラメータの設定は、特徴点検出とマッチングの精度や効率に大きく影響します。

ここでは、コントラスト閾値やoctavesとlayersの組み合わせを変化させた場合の検出結果の比較例を示し、最適なパラメータ選定の参考にします。

コントラスト閾値を変えた検出結果比較

コントラスト閾値contrastThresholdは、局所的なコントラストが閾値以下の特徴点を除外するためのパラメータです。

値を調整することで、検出される特徴点の数と質が変化します。

#include <opencv2/opencv.hpp>

#include <vector>

#include <iostream>

int main() {

cv::Mat image = cv::imread("sample.jpg", cv::IMREAD_GRAYSCALE);

if (image.empty()) {

std::cerr << "画像の読み込みに失敗しました。" << std::endl;

return -1;

}

std::vector<double> contrastThresholds = {0.01, 0.04, 0.1};

for (double threshold : contrastThresholds) {

cv::Ptr<cv::SIFT> sift = cv::SIFT::create(0, 3, threshold);

std::vector<cv::KeyPoint> keypoints;

cv::Mat descriptors;

sift->detectAndCompute(image, cv::noArray(), keypoints, descriptors);

// 検出された特徴点の数を出力

std::cout << "contrastThreshold = " << threshold

<< " で検出された特徴点数: " << keypoints.size() << std::endl;

// 描画

cv::Mat output;

cv::drawKeypoints(image, keypoints, output, cv::Scalar(0, 255, 0),

cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

std::string windowName = "ContrastThreshold_" + std::to_string(threshold);

cv::imshow(windowName, output);

cv::waitKey(0);

}

return 0;

}この例では、コントラスト閾値を0.01、0.04、0.1に設定し、それぞれの検出結果を比較しています。

閾値を低く設定すると、多くの特徴点が検出される一方、ノイズや誤検出も増える傾向があります。

逆に高く設定すると、より安定した特徴点だけが残り、マッチングの信頼性が向上します。

octavesとlayersの組み合わせテスト

octaveLayersは、各オクターブ内でのガウシアンブラーの適用回数を示し、nOctavesはスケール空間の階層数です。

これらのパラメータを調整することで、検出される特徴点のスケール範囲や数に影響します。

#include <opencv2/opencv.hpp>

#include <vector>

#include <iostream>

int main() {

cv::Mat image = cv::imread("sample.jpg", cv::IMREAD_GRAYSCALE);

if (image.empty()) {

std::cerr << "画像の読み込みに失敗しました。" << std::endl;

return -1;

}

std::vector<std::pair<int, int>> paramCombinations = {

{3, 3},

{4, 3},

{3, 4},

{4, 4}

};

for (const auto& params : paramCombinations) {

int nOctaves = 2; // 固定

int octaveLayers = params.first;

int nOctaveLayers = params.second;

cv::Ptr<cv::SIFT> sift = cv::SIFT::create(0, octaveLayers, 0.04);

std::vector<cv::KeyPoint> keypoints;

cv::Mat descriptors;

sift->detectAndCompute(image, cv::noArray(), keypoints, descriptors);

std::cout << "octaveLayers = " << octaveLayers

<< ", layers = " << nOctaveLayers

<< " で検出された特徴点数: " << keypoints.size() << std::endl;

// 描画

cv::Mat output;

cv::drawKeypoints(image, keypoints, output, cv::Scalar(255, 0, 0),

cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);

std::string windowName = "Octaves_" + std::to_string(octaveLayers) +

"_Layers_" + std::to_string(nOctaveLayers);

cv::imshow(windowName, output);

cv::waitKey(0);

}

return 0;

}この例では、octaveLayersとnOctavesの組み合わせを変えて検出結果を比較しています。

一般的に、octaveLayersを増やすと、より細かいスケールの特徴点が検出されやすくなりますが、計算コストも増加します。

最適な組み合わせは、対象画像の内容や用途に応じて調整します。

これらのパラメータチューニング例を通じて、検出結果の特性を理解し、目的に合った最適な設定を見つけることが重要です。

トラブルシューティング

画像処理や特徴点検出・マッチングの工程で問題が発生した場合、その原因を特定し適切な対策を講じることが重要です。

ここでは、特徴点が検出されないケース、マッチング精度が低下する原因、そして画質や解像度の影響について詳しく解説します。

特徴点が検出されないケース

特徴点がまったく検出されない場合、以下のような原因が考えられます。

- 画像の内容が単純すぎる:均一な色や平坦な背景、エッジやコントラストの少ない画像では、特徴点が検出されにくくなります。例えば、白一色や黒一色の画像では、コントラストが低いため検出が困難です

- 画像の解像度が低すぎる:解像度が低いと、細かい特徴やエッジ情報が失われ、検出できる特徴点がほとんどなくなります

- 閾値設定が高すぎる:

contrastThresholdやedgeThresholdを高く設定しすぎると、ほとんどの特徴点が除外されてしまいます - 画像の前処理不足:ノイズやブレ、歪みが多い画像は、特徴点検出の妨げとなることがあります

対策例:

- 画像のコントラストや明るさを調整し、特徴点検出に適した状態にします

- 解像度を適切に設定し、必要に応じてリサイズを行います

- パラメータ設定を見直し、

contrastThresholdやedgeThresholdを低めに調整します - 画像のノイズ除去やシャープ化処理を行います

マッチング精度が低下する原因

マッチングの精度が低い場合、以下の要因が関係しています。

- 特徴点の質が低い:検出された特徴点が安定していない、または誤検出が多いと、正確なマッチングが難しくなります

- 記述子の差異が大きい:画像の変形や照明条件の変化により、記述子の差が大きくなり、正しい対応付けができなくなります

- パラメータの不適切な設定:

nFeaturesやoctaves、contrastThresholdなどの設定が適切でないと、特徴点の数や質が低下し、マッチングの信頼性も落ちます - 外れ値やノイズの影響:誤ったマッチや外れ値が多いと、全体のマッチング精度が低下します

対策例:

- 特徴点の検出と記述子のパラメータを調整し、安定した特徴点を増やす

- Loweの比率テストやRANSACを適用し、外れ値を除去します

- 画像の照明や角度の変化を抑えるか、照明補正や幾何補正を行います

画質や解像度の影響

画像の画質や解像度は、特徴点検出とマッチングの成否に直結します。

- 低画質・低解像度:

- 細かいエッジやテクスチャ情報が失われ、特徴点の検出が困難になります

- ノイズや圧縮アーティファクトが誤検出や誤マッチの原因となります

- 高画質・高解像度:

- より多くの特徴点が検出可能だが、計算コストが増大し、処理時間が長くなります

- 画像のノイズや歪みも増えるため、適切な前処理やパラメータ調整が必要でしょう

対策例:

- 画像の解像度を適切に調整し、必要に応じてリサイズを行います

- 画像のノイズ除去やシャープ化を行い、特徴点の安定性を向上させます

- 画像の圧縮率を適切に設定し、アーティファクトの影響を抑えます

これらのトラブルシューティングポイントを理解し、適切な対策を講じることで、特徴点検出やマッチングの信頼性と精度を向上させることが可能です。

まとめ

この記事では、OpenCVを用いたSIFT特徴点検出とマッチングの基本操作やパラメータ調整、最適化手法、トラブルシューティングについて詳しく解説しました。

適切なパラメータ設定や最適化技術を駆使することで、精度向上や処理速度の改善が可能です。

画像の質や条件に応じた調整方法も理解でき、実践的な画像処理に役立ちます。