[C++] OpenCV ORBを使った高速回転不変特徴点検出とマッチング実装

ORB(Oriented FAST and Rotated BRIEF)はFASTで特徴点を検出し、BRIEFを回転不変化した特許フリーの手法です。

OpenCVのC++ではcv::ORB::create()とdetectAndComputeでキーポイントと記述子を取得し、BFMatcherを使って高速度にマッチングできます。

ORBの基本

ORB(Oriented FAST and Rotated BRIEF)は、画像の特徴点を効率的に検出し、その特徴を記述するための手法です。

SIFTやSURFと比べて高速かつフリーで利用できる点が魅力であり、特にリアルタイム処理や商用アプリケーションに適しています。

ORBは、FASTとBRIEFという二つの主要なアルゴリズムを組み合わせており、それぞれの特徴を活かしながら、回転やスケールに対してロバストな特徴点検出と記述を実現しています。

FASTによる特徴点検出

FAST(Features from Accelerated Segment Test)は、非常に高速なコーナー検出アルゴリズムです。

画像の各ピクセルについて、その周囲のピクセルと比較し、コーナーやエッジの候補点を素早く見つけ出すことができます。

FASTは、そのシンプルな判定基準と計算の効率性から、多くのリアルタイムアプリケーションで採用されています。

FASTアルゴリズムの特徴

FASTは、円形のサンプル点群(通常は16点)を中心ピクセルの周囲に配置し、中心ピクセルの輝度値と比較します。

具体的には、中心ピクセルの輝度値をI_cとし、周囲のサンプル点の輝度値をI_pとします。

あるサンプル点pが、次の条件を満たす場合、その点はコーナー候補とみなされます。

I_pがI_c + tより大きい、またはI_c - tより小さい(tは閾値)- 連続して

n個のサンプル点がこの条件を満たす

この判定により、エッジや平坦な部分を除外し、コーナーの候補点を高速に抽出します。

Harris応答を用いた選択

FASTは非常に高速ですが、すべての検出点が重要なコーナーであるわけではありません。

そこで、Harrisコーナー応答を用いて、FASTで検出された候補点の中からより重要な点を選択します。

Harrisコーナー応答は、画像の局所的な変化を評価し、コーナーの強さを数値化します。

具体的には、画像の局所領域において、輝度の変化を表す2×2の構造テンソル(Hessian行列)を計算し、その行列の固有値を用いてコーナーの強さを評価します。

Harris応答値は次の式で表されます。

\[R = \det(M) – k \cdot (\operatorname{trace}(M))^2\]

ここで、Mは局所領域の勾配情報を含む構造テンソル、kは調整パラメータ(一般的に0.04〜0.06)です。

Rが大きいほど、その点はコーナーとして重要とみなされます。

この応答値を用いて、FASTで検出された候補点の中から、最もコーナーらしい点を選び出すことが可能です。

これにより、特徴点の質を向上させ、マッチングの精度や計算効率を高めることができます。

パラメータ解説

nfeaturesで制御する特徴点数

nfeaturesは、ORB検出器が検出する最大の特徴点の数を設定するパラメータです。

これを調整することで、検出される特徴点の数を制御できます。

例えば、nfeaturesを大きく設定すれば、多くの特徴点を検出し、詳細な特徴情報を得ることが可能です。

一方、値を小さく設定すると、処理速度が向上し、計算負荷を抑えることができます。

ただし、nfeaturesを過度に増やすと、特徴点の重複やノイズの多い点も含まれる可能性があるため、アプリケーションの目的に応じて適切な値を選択する必要があります。

一般的には、数百から千程度の値に設定されることが多いです。

scaleFactorとnlevelsの関係

scaleFactorは、画像ピラミッドの各レベル間のスケール比率を示します。

具体的には、scaleFactorが1より大きい値に設定されると、次のレベルの画像は前のレベルよりも縮小され、スケールの異なる特徴点を検出できるようになります。

nlevelsは、画像ピラミッドのレベル数を表します。

ピラミッドは、異なるスケールの画像を複数層にわたって作成し、スケール不変な特徴点検出を可能にします。

scaleFactorとnlevelsの関係は次のように表されます。

ピラミッドの各レベルのスケールは次の式で計算されます。

\[\text{scale}_i = \text{scaleFactor}^i \quad (i=0,1,\dots,nlevels-1)\]

例えば、scaleFactor=1.2とnlevels=8の場合、最も大きなスケールは約2.56倍(\(1.2^8\))となり、多様なスケールの特徴点を検出できます。

スケールピラミッドの仕組み

スケールピラミッドは、画像の異なる解像度バージョンを階層的に作成し、各レベルで特徴点を検出します。

最上位のレベルは元の画像と同じ解像度で、次のレベルは縮小された画像となります。

これにより、スケールに依存しない特徴点の検出が可能となり、遠くの物体や近くの物体の両方に対応できるようになります。

具体的には、次の手順でピラミッドを構築します。

- 元画像を用意

scaleFactorに基づき、縮小倍率を計算- その倍率で画像を縮小し、新しいレベルを作成

- これを

nlevels回繰り返す

この階層構造により、異なるスケールの特徴点を効率的に検出でき、マッチングの精度向上に寄与します。

edgeThresholdとpatchSize

edgeThresholdは、特徴点検出時に画像の端付近を除外するための閾値です。

これを設定することで、画像の端に近すぎる特徴点を除外し、誤検出やマッチングの不安定さを防ぎます。

値が大きいほど、端から遠い特徴点のみを検出します。

patchSizeは、特徴点の周囲の画像領域のサイズを示します。

ORBでは、BRIEF記述子を計算するために、特徴点周辺の一定範囲のピクセルを用います。

patchSizeが大きいと、より多くの情報を含む記述子が作成され、特徴点の識別性が向上します。

ただし、大きすぎると計算コストが増加し、ノイズの影響も受けやすくなるため、適切な値を選ぶ必要があります。

fastThresholdの役割

fastThresholdは、FASTアルゴリズムにおいてコーナー候補点を検出する際の閾値です。

この値が低いと、より多くの点がコーナー候補として選ばれ、詳細な特徴点が得られます。

一方、値を高く設定すると、コーナーの強さが一定以上の点のみが選ばれるため、検出される特徴点の数は減少します。

このパラメータは、検出速度と特徴点の質のバランスを調整するために重要です。

低すぎるとノイズや不要な点も多くなるため、適度な値に設定することが望ましいです。

一般的には、値は10〜50の範囲で調整されることが多いです。

画像前処理

画像前処理は、特徴点検出やマッチングの精度向上に不可欠な工程です。

ノイズや色彩情報を除去し、画像の情報を最適化することで、後続の処理の信頼性と効率性を高めます。

ここでは、まず画像のグレースケール変換について解説し、その後にノイズ除去の代表的な手法である平均化フィルタとガウシアンブラーについて詳しく紹介します。

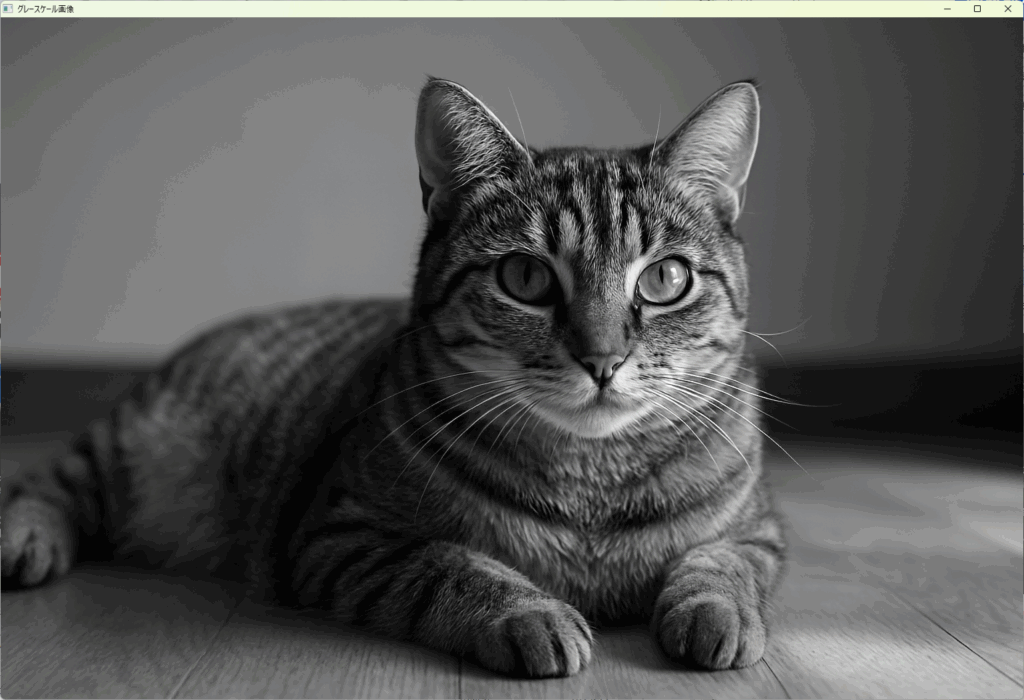

グレースケール変換

カラー画像はRGBやBGRといった複数の色チャネルを持ち、情報量が多いため、特徴点検出の前処理としては一般的にグレースケールに変換します。

グレースケール画像に変換することで、計算負荷を軽減し、特徴点検出の安定性を向上させることができます。

OpenCVでは、cv::cvtColor関数を用いて簡単に変換可能です。

以下に例を示します。

#include <opencv2/opencv.hpp>

int main() {

// カラー画像の読み込み

cv::Mat color_img = cv::imread("color_image.jpg");

if (color_img.empty()) {

std::cerr << "画像が見つかりません。" << std::endl;

return -1;

}

// グレースケールに変換

cv::Mat gray_img;

cv::cvtColor(color_img, gray_img, cv::COLOR_BGR2GRAY);

// 変換結果の表示

cv::imshow("グレースケール画像", gray_img);

cv::waitKey(0);

return 0;

}

この処理により、カラー画像の情報を輝度情報に集約し、特徴点検出の対象とします。

ノイズ除去

画像にはさまざまなノイズが含まれることがあり、これが特徴点検出やマッチングの妨げとなる場合があります。

ノイズを除去し、画像の情報を滑らかにすることで、検出の安定性と精度を向上させることが可能です。

代表的なノイズ除去手法には、平均化フィルタとガウシアンブラーがあります。

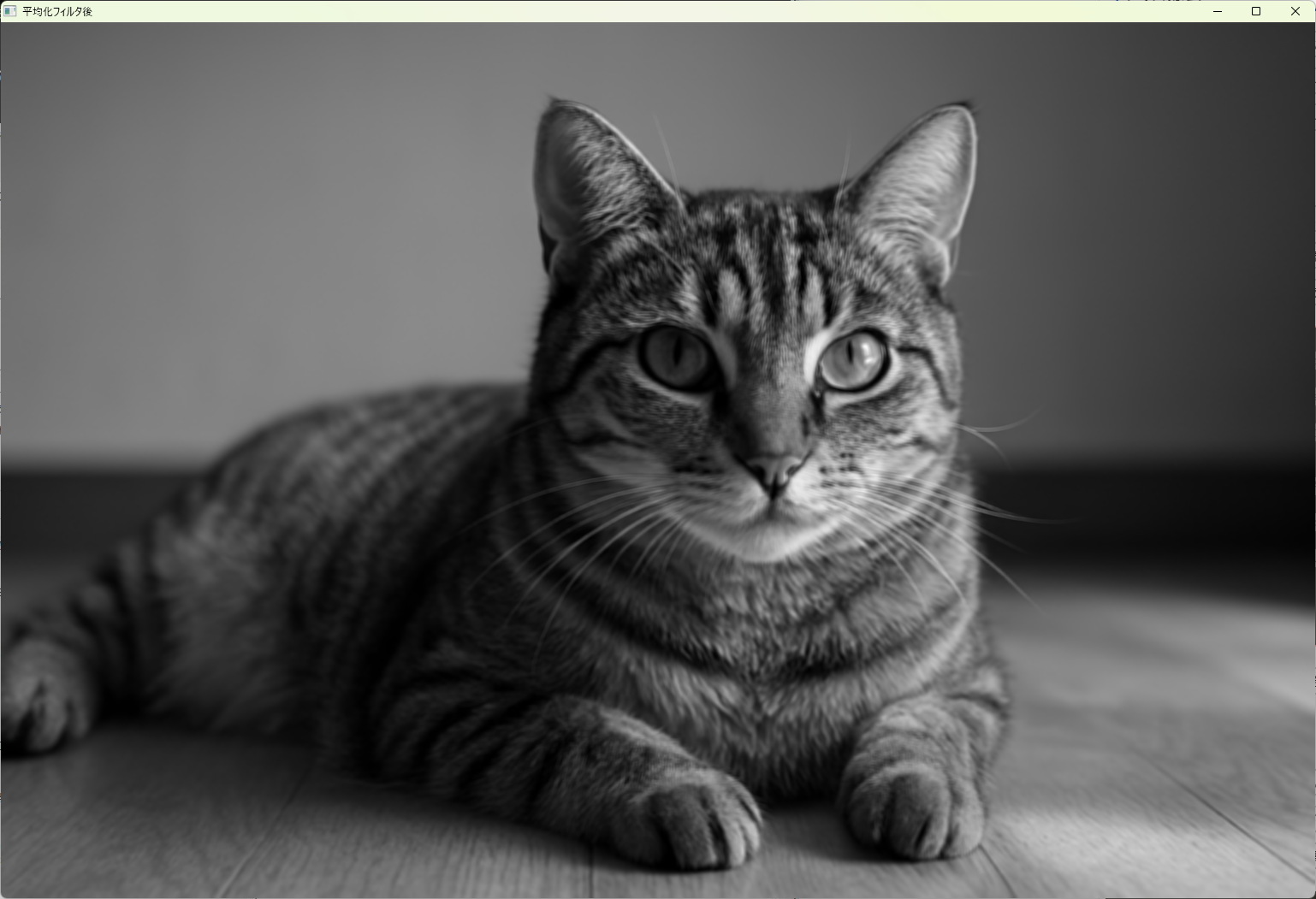

平均化フィルタ

平均化フィルタは、画像の各ピクセル値を、その周囲のピクセル値の平均値に置き換える単純な平滑化処理です。

これにより、ランダムなノイズを低減し、画像の滑らかさを向上させます。

OpenCVでは、cv::blur関数を用いて実現します。

#include <opencv2/opencv.hpp>

int main() {

cv::Mat src = cv::imread("noisy_image.jpg", cv::IMREAD_GRAYSCALE);

if (src.empty()) {

std::cerr << "画像が見つかりません。" << std::endl;

return -1;

}

// 平均化フィルタのカーネルサイズを指定

cv::Mat dst;

cv::blur(src, dst, cv::Size(5, 5));

// 結果の表示

cv::imshow("平均化フィルタ後", dst);

cv::waitKey(0);

return 0;

}

この例では、5×5のカーネルを用いて画像を平滑化しています。

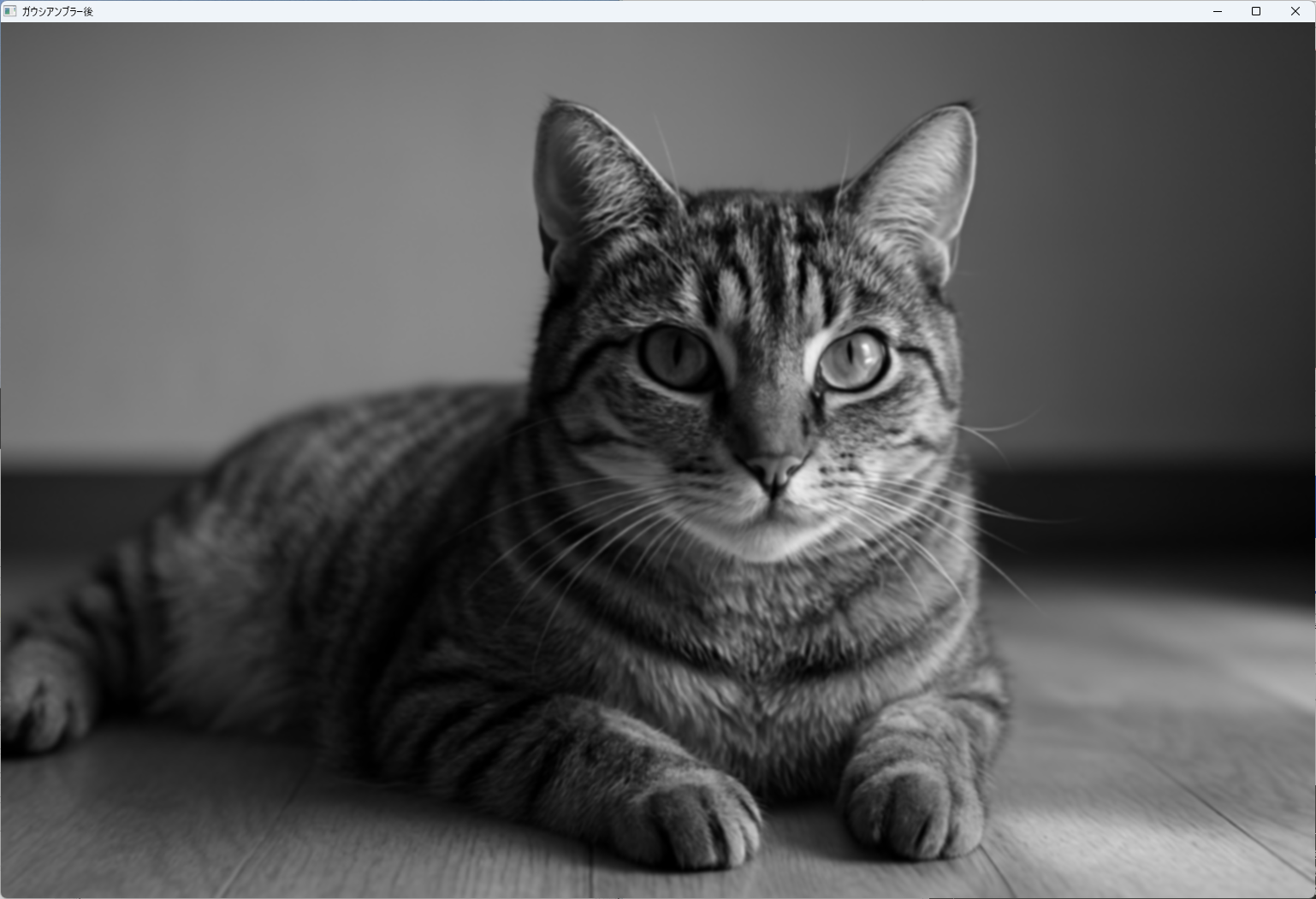

ガウシアンブラー

ガウシアンブラーは、ガウス関数に基づく重み付けを行いながらピクセル値を平滑化します。

平均化フィルタよりも自然なぼかし効果が得られ、エッジのぼやけを抑えつつノイズ除去が可能です。

OpenCVでは、cv::GaussianBlur関数を使用します。

#include <opencv2/opencv.hpp>

int main() {

cv::Mat src = cv::imread("noisy_image.jpg", cv::IMREAD_GRAYSCALE);

if (src.empty()) {

std::cerr << "画像が見つかりません。" << std::endl;

return -1;

}

// ガウシアンブラーのカーネルサイズと標準偏差を指定

cv::Mat dst;

cv::GaussianBlur(src, dst, cv::Size(7, 7), 1.5);

// 結果の表示

cv::imshow("ガウシアンブラー後", dst);

cv::waitKey(0);

return 0;

}

この例では、7×7のカーネルと標準偏差1.5を設定しています。

ガウシアンブラーは、ノイズ除去とエッジの保持のバランスが良いため、多くの画像処理シナリオで広く使われています。

実装のポイント

detectAndComputeの使い方

detectAndComputeは、OpenCVのORBや他の特徴点検出器で特徴点の検出と、その特徴点に対応する記述子の計算を一度に行う便利な関数です。

これにより、コードの簡潔さと効率性が向上します。

引数の意味

void detectAndCompute(

InputArray image, // 入力画像(グレースケール画像が推奨)

InputArray mask, // マスク画像(特徴点検出を制限したい部分に使用)

std::vector<KeyPoint>& keypoints, // 検出された特徴点の格納先

OutputArray descriptors, // 計算された記述子の格納先(cv::Mat)

bool useProvidedKeypoints = false // 既存のキーポイントを使うかどうか

)imageには、特徴点検出対象の画像を指定します。通常はグレースケール画像を用いますmaskは、検出範囲を限定したい場合に使用します。不要な部分は空のcv::Mat()を渡しますkeypointsは、検出された特徴点の情報を格納します。関数呼び出し後に更新されますdescriptorsは、各特徴点に対応する記述子を格納します。これを後のマッチングに利用しますuseProvidedKeypointsは、既に検出済みのキーポイントを使いたい場合にtrueに設定します

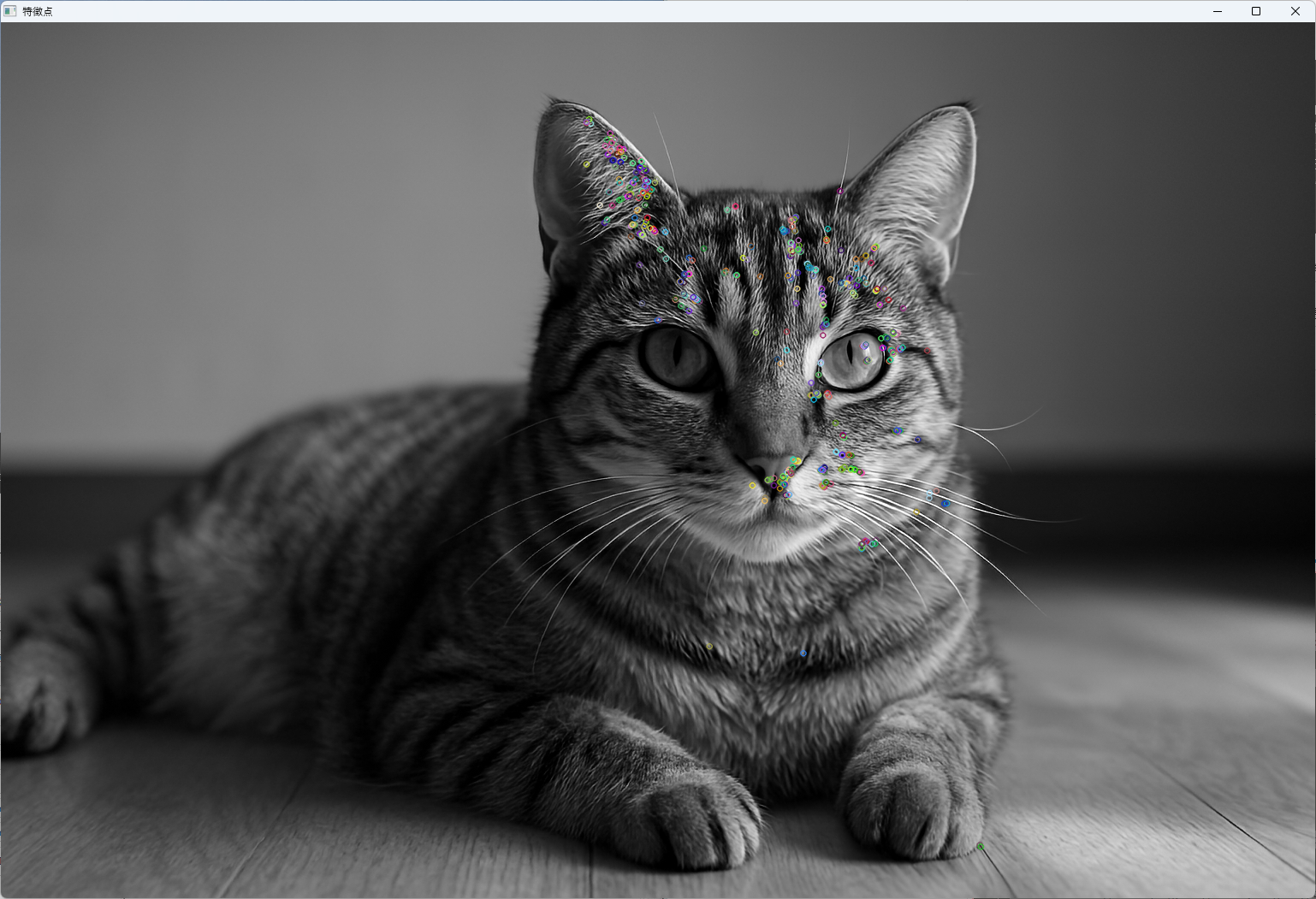

実際のコード例

#include <opencv2/opencv.hpp>

int main() {

cv::Mat img = cv::imread("sample.jpg", cv::IMREAD_GRAYSCALE);

if (img.empty()) {

std::cerr << "画像が見つかりません。" << std::endl;

return -1;

}

// ORB検出器の作成

cv::Ptr<cv::ORB> orb = cv::ORB::create();

// 特徴点と記述子の格納用変数

std::vector<cv::KeyPoint> keypoints;

cv::Mat descriptors;

// detectAndComputeの呼び出し

orb->detectAndCompute(img, cv::Mat(), keypoints, descriptors);

// 検出結果の表示

cv::Mat img_keypoints;

cv::drawKeypoints(img, keypoints, img_keypoints, cv::Scalar::all(-1), cv::DrawMatchesFlags::DEFAULT);

cv::imshow("特徴点", img_keypoints);

cv::waitKey(0);

return 0;

}

この例では、画像から特徴点を検出し、その位置にマーカーを付けて表示しています。

KeyPoint構造体の詳細

cv::KeyPointは、特徴点の位置や属性を表す構造体です。

特徴点の検出結果を格納し、マッチングや特徴点の選別に利用されます。

主要メンバ一覧

| メンバ名 | 型 | 説明 |

|---|---|---|

pt | cv::Point2f | 特徴点の画像内位置(x, y座標) |

size | float | 特徴点の大きさ(スケール) |

angle | float | 特徴点の方向(回転角度、度単位) |

response | float | 特徴点の強さ(重要度) |

octave | int | ピラミッドのレベル(スケール層) |

class_id | int | 特徴点のクラスID(用途に応じて利用) |

例:cv::KeyPointの生成と利用

cv::KeyPoint kp(cv::Point2f(150.0f, 200.0f), 1.5f, -1, 0.8f, 0, -1);この例では、位置(150, 200)、大きさ1.5、角度未設定、強さ0.8、ピラミッドレベル0、クラスID未設定の特徴点を作成しています。

記述子(Mat)の扱い方

記述子は、特徴点の局所画像パッチから抽出された特徴の数値表現です。

ORBでは、BRIEFに基づくバイナリ記述子を用いており、cv::Mat型で格納されます。

記述子の特徴

- 各行が1つの特徴点に対応

- 列はビット列(バイナリパターン)を表す

- 例えば、128ビットの記述子は16バイト(

CV_8U型の行列)として格納される

記述子の利用例

マッチングには、cv::BFMatcherやcv::FlannBasedMatcherを用います。

これらは、記述子の距離や類似度を計算し、最も近い特徴点のペアを見つけ出します。

// 例:マッチングの実行

cv::BFMatcher matcher(cv::NORM_HAMMING);

std::vector<cv::DMatch> matches;

matcher.match(descriptors1, descriptors2, matches);記述子の保存と再利用

記述子は、ファイルに保存したり、後の処理に渡したりできます。

cv::FileStorageを使えば、簡単に保存・読み込みが可能です。

// 保存例

cv::FileStorage fs("descriptors.yml", cv::FileStorage::WRITE);

fs << "descriptors" << descriptors;

fs.release();

// 読み込み例

cv::FileStorage fs2("descriptors.yml", cv::FileStorage::READ);

cv::Mat loaded_descriptors;

fs2["descriptors"] >> loaded_descriptors;

fs2.release();%YAML:1.0

---

descriptors: !!opencv-matrix

rows: 500

cols: 32

dt: u

data: [ 185, 197, 40, 235, 149, 223, 79, 237, 87, 42, 181, 26, 91, 89,

58, 81, 249, 168,特徴マッチング

特徴点のマッチングは、画像間の対応点を見つける重要な工程です。

マッチングの精度と速度は、後続の画像認識や3D再構築、ロボットナビゲーションなど、多くの応用に直結します。

ここでは、代表的なマッチング手法であるBrute-ForceマッチャーとFLANNマッチャーについて詳しく解説します。

Brute-Forceマッチャー

cv::BFMatcherは、特徴記述子間の距離を計算し、最も近いペアを見つけるシンプルなマッチング方法です。

特に、ORBのようなバイナリ記述子にはcv::NORM_HAMMINGを用いるのが一般的です。

cv::BFMatcherの初期化

cv::BFMatcherのインスタンスは、距離の計算方法とクロスマッチングの有無を指定して作成します。

#include <opencv2/opencv.hpp>

int main() {

// ハミング距離を用いたBrute-Forceマッチャーの作成

cv::BFMatcher matcher(cv::NORM_HAMMING, true);

return 0;

}cv::NORM_HAMMINGは、バイナリ記述子の距離計算に適していますcrossCheck=trueは、相互に最良のマッチングだけを採用し、誤検出を減らす効果があります

マッチング結果の絞り込み

マッチング後は、ノイズや誤対応を除去するために、距離の閾値や比率テストを行います。

一般的な方法は、最良のマッチと次点のマッチの距離比を比較し、一定の閾値以下の場合のみ採用するものです。

例として、比率テストを用いた絞り込みを示します。

#include <opencv2/opencv.hpp>

#include <vector>

int main() {

// 例:2つの記述子セット

cv::Mat descriptors1, descriptors2;

// 事前に検出・計算済みと仮定

// マッチャーの作成

cv::BFMatcher matcher(cv::NORM_HAMMING);

std::vector<cv::DMatch> matches;

matcher.match(descriptors1, descriptors2, matches);

// 距離の閾値設定(例:30)

double max_dist = 30.0;

// 良いマッチのみを抽出

std::vector<cv::DMatch> good_matches;

for (const auto& m : matches) {

if (m.distance < max_dist) {

good_matches.push_back(m);

}

}

// 結果の描画

// 省略

return 0;

}また、比率テストを行う場合は、knnマッチングを用いて、最良と次点の距離を比較します。

// knnMatchを用いた例

std::vector<std::vector<cv::DMatch>> knn_matches;

matcher.knnMatch(descriptors1, descriptors2, knn_matches, 2);

const float ratio_thresh = 0.75f;

std::vector<cv::DMatch> good_matches;

for (size_t i = 0; i < knn_matches.size(); i++) {

if (knn_matches[i][0].distance < ratio_thresh * knn_matches[i][1].distance) {

good_matches.push_back(knn_matches[i][0]);

}

}FLANNマッチャー

cv::FlannBasedMatcherは、大規模な特徴点セットに対して高速にマッチングを行うためのアルゴリズムです。

特に、SIFTやSURFのような浮動小数点記述子に適しています。

利用条件と注意点

- 浮動小数点の記述子に対して有効

- バイナリ記述子(ORBなど)には

cv::flann::IndexParamsの設定に工夫が必要 - OpenCVのバージョンによっては、

cv::flann::Indexの仕様変更に注意

パラメータ設定のコツ

cv::flann::KDTreeIndexParamsを用いて、木の数や探索の深さを調整- 例:

cv::FlannBasedMatcherの作成時にcv::KDTreeIndexParams(5)を指定

#include <opencv2/opencv.hpp>

int main() {

// 浮動小数点記述子の例

cv::Mat descriptors1, descriptors2;

// 事前に検出・計算済みと仮定

// FLANNマッチャーの作成

cv::Ptr<cv::DescriptorMatcher> matcher = cv::DescriptorMatcher::create(cv::DescriptorMatcher::FLANNBASED);

// マッチング

std::vector<cv::DMatch> matches;

matcher->match(descriptors1, descriptors2, matches);

// 結果の絞り込みはBFと同様

// 省略

return 0;

}- 重要:バイナリ記述子の場合、

cv::flann::IndexParamsの設定や、cv::Matの型に注意し、CV_32Fに変換してから使用することが推奨されます

// バイナリ記述子をfloatに変換

descriptors1.convertTo(descriptors1_float, CV_32F);

descriptors2.convertTo(descriptors2_float, CV_32F);これにより、FLANNの高速探索が正しく動作します。

可視化方法

画像処理や特徴点マッチングの結果を視覚的に確認するためには、OpenCVが提供する便利な関数を活用します。

これらの関数を使うことで、検出した特徴点やマッチング結果を画像上に描画し、直感的に理解しやすくなります。

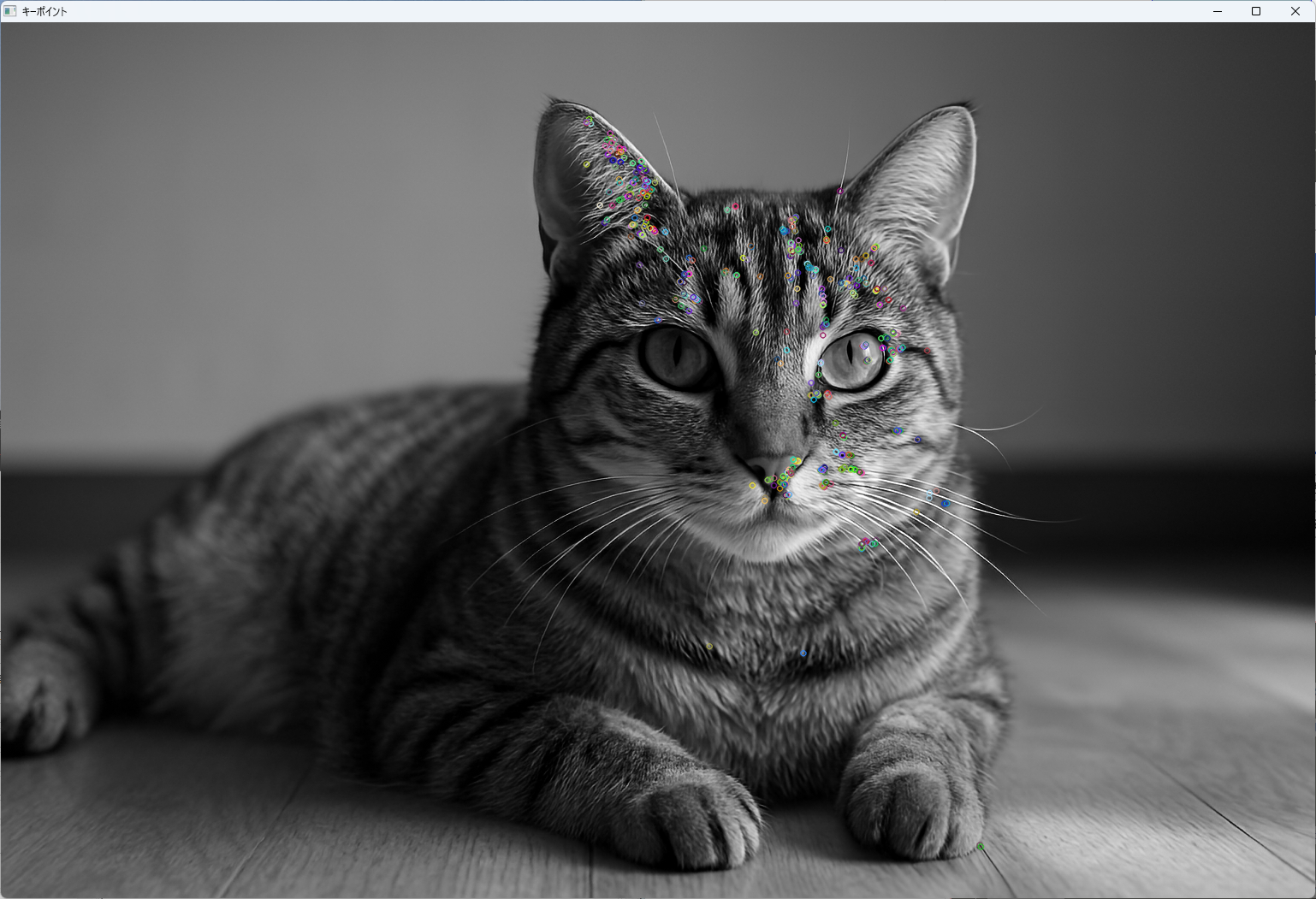

drawKeypointsでキーポイント描画

cv::drawKeypointsは、画像中の検出された特徴点をマーカーやサークルで描画します。

特徴点の位置や大きさ、方向などの情報を視覚的に確認できるため、検出結果の妥当性を評価するのに役立ちます。

使い方例

#include <iostream>

#include <opencv2/opencv.hpp>

int main() {

// グレースケールで画像を読み込み

cv::Mat img = cv::imread("sample.jpg", cv::IMREAD_GRAYSCALE);

if (img.empty()) {

std::cerr << "画像が見つかりません。" << std::endl;

return -1;

}

// ORB のインスタンス生成

cv::Ptr<cv::ORB> orb = cv::ORB::create();

// 特徴点検出用の変数

std::vector<cv::KeyPoint> keypoints;

// 記述子格納用の変数

cv::Mat descriptors;

// 特徴点の検出と記述子の計算

orb->detectAndCompute(img, cv::Mat(), keypoints, descriptors);

// キーポイントを描画

cv::Mat img_with_keypoints;

cv::drawKeypoints(img, keypoints, img_with_keypoints, cv::Scalar::all(-1),

cv::DrawMatchesFlags::DEFAULT);

// 結果を表示

cv::imshow("キーポイント", img_with_keypoints);

cv::waitKey(0);

return 0;

}

この例では、検出した特徴点を画像上に描画し、位置や大きさ、方向を確認できます。

drawMatchesでマッチ表示

cv::drawMatchesは、2つの画像間の特徴点マッチング結果を一つの画像に合成して描画します。

マッチングの良し悪しや対応点の分布を直感的に把握できるため、マッチングの精度評価やデバッグに非常に便利です。

使い方例

#include <opencv2/opencv.hpp>

int main() {

cv::Mat img1 = cv::imread("image1.jpg", cv::IMREAD_GRAYSCALE);

cv::Mat img2 = cv::imread("image2.jpg", cv::IMREAD_GRAYSCALE);

if (img1.empty() || img2.empty()) {

std::cerr << "画像が見つかりません。" << std::endl;

return -1;

}

// 特徴点と記述子の検出

cv::Ptr<cv::ORB> orb = cv::ORB::create();

std::vector<cv::KeyPoint> keypoints1, keypoints2;

cv::Mat descriptors1, descriptors2;

orb->detectAndCompute(img1, cv::Mat(), keypoints1, descriptors1);

orb->detectAndCompute(img2, cv::Mat(), keypoints2, descriptors2);

// マッチング

cv::BFMatcher matcher(cv::NORM_HAMMING);

std::vector<cv::DMatch> matches;

matcher.match(descriptors1, descriptors2, matches);

// 描画

cv::Mat img_matches;

cv::drawMatches(img1, keypoints1, img2, keypoints2, matches, img_matches);

// 表示

cv::imshow("マッチング結果", img_matches);

cv::waitKey(0);

return 0;

}この結果画像には、左右に並んだ2つの画像と、それらの間の対応点を結ぶ線が描かれます。

カスタマイズオプション

drawKeypointsやdrawMatchesには、多彩な描画オプションが用意されています。

これらを調整することで、見やすさや情報量をコントロールできます。

flagsパラメータ:描画スタイルの選択cv::DrawMatchesFlags::DEFAULT:標準的な描画cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS:キーポイントの大きさや方向も描画cv::DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS:単一のポイントを描画しない

colorパラメータ:描画色の指定(例:cv::Scalar(0, 255, 0)で緑色)thicknessやlineType:線の太さや種類の調整

例:drawKeypointsのカスタマイズ

cv::drawKeypoints(img, keypoints, img_with_keypoints, cv::Scalar(0, 255, 0), cv::DrawMatchesFlags::DRAW_RICH_KEYPOINTS);例:drawMatchesのカスタマイズ

cv::drawMatches(img1, keypoints1, img2, keypoints2, matches, img_matches,

cv::Scalar::all(-1), cv::Scalar(255, 0, 0), std::vector<char>(),

cv::DrawMatchesFlags::NOT_DRAW_SINGLE_POINTS);これにより、マッチ線の色や描画スタイルを細かく調整でき、結果の見やすさや情報伝達性を向上させることが可能です。

パフォーマンス最適化

画像処理や特徴点検出・マッチングの処理は計算負荷が高いため、効率的な実装と最適化が重要です。

ここでは、マルチスレッドの活用、ROI(Region of Interest)指定による処理範囲の限定、そしてメモリ使用量の抑制について詳しく解説します。

マルチスレッド活用

OpenCVは、内部的にマルチスレッド処理をサポートしており、多くの関数は自動的に並列化されています。

ただし、ユーザ側でも明示的にマルチスレッドを活用することで、処理速度を大幅に向上させることが可能です。

- OpenCVの並列化機能:

cv::parallel_for_を用いて、ループ処理を複数のスレッドに分散させることができます。例えば、複数の画像や複数のROIに対して並列処理を行う場合に有効です

#include <opencv2/opencv.hpp>

#include <vector>

void processROI(const cv::Mat& src, cv::Mat& dst, const cv::Rect& roi) {

// ROI内の画像処理例

cv::Mat region = src(roi);

// 例:特徴点検出やフィルタ処理

// ...

}

int main() {

cv::Mat image = cv::imread("large_image.jpg", cv::IMREAD_GRAYSCALE);

std::vector<cv::Rect> rois = { /* 複数のROI定義 */ };

cv::parallel_for_(cv::Range(0, rois.size()), [&](const cv::Range& range) {

for (int i = range.start; i < range.end; ++i) {

cv::Mat result;

processROI(image, result, rois[i]);

// 結果の保存や次の処理

}

});

return 0;

}- 注意点:スレッド間の競合やデータの同期に注意し、必要に応じてロックやミューテックスを使用します

ROI指定による高速化

画像の一部分だけに処理を限定することで、不要な計算を省き、処理時間を短縮できます。

- ROIの設定:

cv::Matのサブマトリクスを作成して、対象範囲だけを処理します

cv::Rect roi(50, 50, 200, 200); // x, y, width, height

cv::Mat img_roi = img(roi);- 特徴点検出や記述子計算:ROI内だけで行うことで、全体画像に比べて計算コストを削減します

- マッチングや描画:ROIを適用した結果を元画像に合成する場合は、ROIの位置を考慮して結果を貼り付けます

メモリ使用量の抑制

大量の画像や特徴点データを扱う場合、メモリの効率的な管理が不可欠です。

データ構造の選択

cv::Matの適切な型選択:必要な情報だけを格納し、不要なデータ型を避けます。例えば、記述子はCV_8UやCV_32Fなど、用途に応じて最適な型を選ぶstd::vectorの利用:動的配列として特徴点やマッチング結果を格納し、必要に応じて容量を調整- メモリプールや再利用:頻繁に使うバッファや一時変数は、使い回すことでメモリ確保と解放のオーバーヘッドを削減

// 例:特徴点格納用の事前確保

std::vector<cv::KeyPoint> keypoints;

keypoints.reserve(1000); // 予想される最大数に合わせて確保- 不要なデータの解放:使い終わった

cv::Matやstd::vectorは、clear()やrelease()を呼び出してメモリを解放します

descriptors.release();

keypoints.clear();- メモリの断片化防止:大きな連続メモリブロックを確保し、断片化を防ぐ工夫も有効です

これらの最適化手法を組み合わせることで、処理速度の向上とメモリ効率の改善を図ることができます。

応用例

ORBやその他の特徴点検出・マッチング技術は、多くの実世界のアプリケーションに応用されています。

ここでは、物体検出と追跡、拡張現実(AR)におけるマーカー認識、そしてSLAM(Simultaneous Localization and Mapping)への組み込み例について詳しく解説します。

物体検出と追跡

特徴点検出とマッチングは、動画像やビデオシーケンスにおいて、特定の物体を検出し、その位置を追跡するために広く利用されます。

- 物体検出:既知の物体の特徴点を事前に登録し、新しい画像内での対応点をマッチングさせることで、物体の位置や姿勢を推定します。例えば、工場のラインで特定の部品を検出する場合に有効です

- 追跡:動画フレーム間で特徴点の対応を追い続けることで、動いている物体の軌跡を追跡します。特徴点のマッチング結果を用いて、物体の動きや変形をリアルタイムで把握できます

- 実装例:OpenCVの

cv::calcOpticalFlowPyrLKと組み合わせて、特徴点の追跡を行うことも一般的です

// 例:特徴点の追跡

cv::calcOpticalFlowPyrLK(prev_img, curr_img, prev_points, curr_points, status, err);拡張現実(AR)でのマーカー認識

ARアプリケーションでは、現実世界のマーカーやパターンを認識し、その位置や姿勢を推定して仮想オブジェクトを重ね合わせます。

- マーカー認識:事前に登録したマーカー画像の特徴点と、カメラから取得した画像の特徴点をマッチングさせることで、マーカーの位置と向きを推定します

- 実装例:マーカーの特徴点を検出し、マッチング結果からホモグラフィ行列を推定し、仮想オブジェクトの投影変換を計算します

// ホモグラフィ推定例

cv::Mat H = cv::findHomography(obj_points, scene_points, cv::RANSAC);- 応用:スマートフォンのARアプリや、インタラクティブな展示、教育用ツールなどで広く使われています

SLAMへの組み込み

SLAMは、自己位置推定と地図作成を同時に行う技術で、ロボットや自動運転車、ドローンなどに応用されます。

ステレオカメラでの特徴マッチ

- ステレオビジョン:左右のカメラから得られる画像間で特徴点をマッチングさせ、対応点の3D座標を推定します

- 特徴点マッチングの役割:対応点の位置関係から、カメラの動き(自己位置)や環境の3D構造を推定します

// ステレオ画像の特徴点マッチング例

std::vector<cv::DMatch> stereo_matches;

matcher.match(descriptors_left, descriptors_right, stereo_matches);- 3D再構築:対応点の視差とカメラの内部パラメータを用いて、点群や地図を生成します

// 視差から深度計算

float depth = (focal_length * baseline) / disparity;- SLAMシステムの一部として:特徴点のマッチング結果を用いて、カメラの位置推定や地図の更新をリアルタイムで行います

これらの応用例は、特徴点検出・マッチングの技術が多様な分野で革新的な役割を果たしていることを示しています。

各分野での具体的な実装や最適化は、対象の環境や要求に応じて調整されますが、基本的な考え方は共通しています。

トラブルシューティング

特徴点検出とマッチングの過程では、さまざまな問題が発生することがあります。

これらの問題に対処し、システムの信頼性と精度を向上させるための対策について解説します。

過剰マッチングへの対策

過剰マッチングは、多くの誤った対応点が含まれる状態です。

これにより、位置推定や認識の精度が低下します。

- 距離閾値の調整:マッチング時に距離の閾値を厳しく設定し、類似度の低いマッチを除外します。例えば、

cv::NORM_HAMMING距離の値を小さく設定します - 比率テストの適用:knnマッチングと比率閾値(例:0.75)を用いて、最良と次点の距離の比率が一定以下のマッチだけを採用します

// 比率テスト例

if (knn_matches[i][0].distance < ratio_thresh * knn_matches[i][1].distance) {

good_matches.push_back(knn_matches[i][0]);

}- RANSACによるアウトライア除去:ホモグラフィ推定時にRANSACを用いて、誤ったマッチを除外します

cv::Mat mask;

cv::findHomography(obj_points, scene_points, cv::RANSAC, 3, mask);特徴点不足時の対応

特徴点が十分に検出できない場合、マッチングや認識の信頼性が低下します。

- パラメータの調整:

fastThresholdやnfeaturesを調整し、検出感度を高める。閾値を下げると、より多くの特徴点が検出されやすくなります - 画像前処理の改善:ノイズ除去やコントラスト調整を行い、特徴点検出の安定性を向上させます

- 複数の特徴点検出手法の併用:ORB以外の検出器(例:AKAZEやBRISK)も併用し、検出率を高める

- 画像の解像度を調整:高解像度の画像を使用することで、より多くの特徴点を検出できる場合があります

照明変化へのロバスト化

照明条件の変化は、特徴点の検出とマッチングに大きな影響を与えます。

- 回転・スケール不変性の活用:ORBは回転・スケールに対してロバストですが、照明変化には弱い場合があります。照明補正やコントラスト調整を行います

- 画像の正規化:ヒストグラム均一化やCLAHE(Contrast Limited Adaptive Histogram Equalization)を適用し、画像のコントラストを均一化します

cv::Ptr<cv::CLAHE> clahe = cv::createCLAHE();

cv::Mat img_clahe;

clahe->apply(img, img_clahe);- 特徴記述子の選択:照明変化に対してロバストな記述子(例:AKAZEやLATCH)を併用します

- 照明条件の多様なデータ収集:異なる照明条件下での画像を収集し、学習やパラメータ調整に活用します

これらの対策を適切に組み合わせることで、システムの堅牢性を高め、さまざまな環境下でも安定した動作を実現できます。

高度なカスタマイズ

OpenCVのORBや類似の特徴点検出・記述手法は、標準の設定だけでなく、用途に応じてさまざまなカスタマイズが可能です。

ここでは、記述子のフォーマット変更、独自のマッチング指標の導入、そしてGPUを活用した高速処理のためのCUDA版ORBについて詳しく解説します。

記述子のフォーマット変更

標準のORBは、バイナリ記述子(例:128ビット)を用いていますが、特定の用途やハードウェアに合わせてフォーマットを変更することが可能です。

- カスタム記述子の作成:既存の記述子を抽出した後、独自のビットパターンや数値表現に変換します。例えば、

cv::Matの型や次元を変更したり、特定の特徴量を追加したりします - 例:記述子のビット列を別の形式に変換

// 例:128ビットの記述子を16バイトの配列に変換

cv::Mat descriptors; // 既存の記述子

std::vector<uint8_t> custom_format(descriptors.rows * 16);

for (int i = 0; i < descriptors.rows; ++i) {

memcpy(&custom_format[i * 16], descriptors.ptr<uint8_t>(i), 16);

}- 注意点:フォーマット変更後も、マッチングや距離計算のアルゴリズムに適合させる必要があります

オリジナルマッチング指標導入

標準のマッチングは、ハミング距離やユークリッド距離を用いますが、特定のアプリケーションに合わせて独自の距離関数や類似度指標を導入できます。

- 例:加重距離や類似度関数の定義

float customDistance(const cv::Mat& desc1, const cv::Mat& desc2) {

// 例:ビットごとの重み付けを行った距離

int distance = 0;

for (int i = 0; i < desc1.cols; ++i) {

uint8_t byte1 = desc1.at<uint8_t>(0, i);

uint8_t byte2 = desc2.at<uint8_t>(0, i);

uint8_t diff = byte1 ^ byte2;

// 例:ビットごとの重み付け

distance += cv::popCount(diff);

}

return static_cast<float>(distance);

}- マッチングに適用:

cv::BFMatcherやcv::DescriptorMatcherのdistance関数をオーバーライドして利用します - メリット:アプリケーションに最適化されたマッチング精度向上や、特定のノイズに対する耐性強化が可能です

GPU版ORBの利用

大量の画像やリアルタイム処理が求められる場合、GPUを活用した高速化が効果的です。

OpenCVはCUDA対応のモジュールを提供しており、cv::cuda::ORBクラスを使うことで、GPU上で特徴点検出と記述子計算を行えます。

CUDAモジュールとの連携

- 必要な環境:CUDA対応GPUと、OpenCVのCUDAモジュールがビルドされた環境

- 基本的な流れ:画像データをGPUメモリに転送し、

cv::cuda::ORBを用いて処理を行います

#include <opencv2/cudaobjdetect.hpp>

#include <opencv2/cudafeatures2d.hpp>

int main() {

// GPUメモリに画像を転送

cv::cuda::GpuMat gpu_img;

cv::Mat img = cv::imread("sample.jpg", cv::IMREAD_GRAYSCALE);

gpu_img.upload(img);

// ORBの作成

cv::Ptr<cv::cuda::ORB> orb_gpu = cv::cuda::ORB::create();

// 特徴点と記述子の検出

cv::cuda::GpuMat keypoints_gpu, descriptors_gpu;

orb_gpu->detectAndCompute(gpu_img, cv::cuda::GpuMat(), keypoints_gpu, descriptors_gpu);

// 必要に応じて結果をダウンロード

std::vector<cv::KeyPoint> keypoints;

keypoints_gpu.download(keypoints);

cv::Mat descriptors;

descriptors_gpu.download(descriptors);

// 以降の処理

return 0;

}cv::cuda::ORBクラスの使い方

create()でインスタンスを生成detectAndCompute()で特徴点と記述子を検出download()でGPUメモリからホストメモリへ結果を取得

メモリ転送の注意点

- 頻繁なデータのアップロード・ダウンロードは遅延の原因:必要な処理をGPU上で完結させる設計にする

- バッファの再利用:

cv::cuda::GpuMatを使い回すことで、メモリ確保と解放のオーバーヘッドを削減 - データ型の一致:記述子や画像の型をGPU処理に適した形式に揃える(例:

CV_8UC1やCV_32F)

これらの高度なカスタマイズを駆使することで、特定の用途や環境に最適化された特徴点処理システムを構築できます。

まとめ

この記事では、OpenCVのORBを用いた特徴点検出・マッチングの基本から応用、最適化、カスタマイズ方法まで詳しく解説しました。

高速処理や環境変化への対応、GPU活用など、多彩な技術を駆使して、精度と効率を両立させる手法を理解できます。