【C#】JSONとCSVを相互変換する最速レシピ―Newtonsoft.Json×CsvHelperでネストデータもラクラク処理

C#でJSONとCSVを変換するなら、Newtonsoft.Jsonでパース・シリアライズし、CsvHelperで読み書きする組み合わせが最も手軽で柔軟です。

JSON→CSVはネストをフラット化してヘッダーを生成し、CSV→JSONはパスを解析して階層を復元します。

Streamやメモリ操作で高速化でき、クラスマップを使えば型安全な保守が可能です。

UTF-8や引用符エスケープを配慮すれば大規模データでも安定して扱えます。

使用ライブラリ概要

C#でJSONとCSVの相互変換を行う際に、特に便利なライブラリとしてNewtonsoft.JsonとCsvHelperがあります。

これらはそれぞれJSONとCSVの操作に特化しており、組み合わせることで複雑なネスト構造のデータも効率よく処理できます。

ここでは、それぞれの特徴と両者を組み合わせるメリットについて詳しく解説します。

Newtonsoft.Jsonの特徴

Newtonsoft.Jsonは、C#で最も広く使われているJSON操作用のライブラリです。

正式名称は「Json.NET」で、柔軟かつ高速なJSONのシリアライズ・デシリアライズ機能を提供しています。

主な特徴は以下の通りです。

- 柔軟なシリアライズ/デシリアライズ

クラスや構造体、辞書型、リストなど、さまざまなC#のデータ型をJSONに変換したり、JSONから復元したりできます。

特に、ネストしたオブジェクトや配列も自然に扱えます。

- JObjectやJArrayによる動的操作

JSONの構造が事前にわからない場合でも、JObjectやJArrayを使って動的にJSONを解析・編集できます。

これにより、階層構造の深いJSONも再帰的に処理しやすくなります。

- カスタムコンバーターのサポート

日付や列挙型、特殊なフォーマットのデータなど、標準の変換では対応しにくい型に対しても、独自の変換ロジックを実装できます。

- 高いパフォーマンス

大量のデータを扱う場合でも高速に処理できるよう最適化されています。

- 豊富な設定オプション

インデントの有無、Null値の扱い、プロパティ名の変換(キャメルケースやスネークケースなど)を細かく制御可能です。

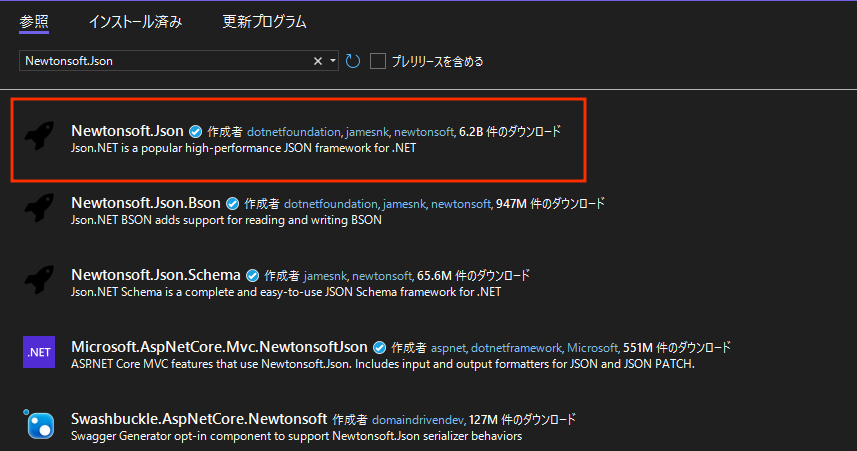

Newtonsoft.Jsonは、Nugetからインストールする必要があります。

「Newtonsoft.Json」と検索してインストールするようにしてください。

dotnet add package Newtonsoft.Json以下は、Newtonsoft.Jsonを使った簡単なJSONのシリアライズ例です。

using Newtonsoft.Json;

using System;

public class Person

{

public string Name { get; set; }

public int Age { get; set; }

}

class Program

{

static void Main()

{

var person = new Person { Name = "太郎", Age = 30 };

string json = JsonConvert.SerializeObject(person, Formatting.Indented);

Console.WriteLine(json);

}

}{

"Name": "太郎",

"Age": 30

}このように、オブジェクトを簡単にJSON文字列に変換できます。

CsvHelperの特徴

CsvHelperは、C#でCSVファイルの読み書きを簡単に行うためのオープンソースライブラリです。

CSVの仕様はシンプルながらも、改行やカンマのエスケープ、引用符の扱いなど細かいルールが多いため、手作業での実装は意外と複雑です。

CsvHelperはこれらの処理を自動化し、堅牢なCSV操作を実現します。

主な特徴は以下の通りです。

- 簡単な読み込み・書き込みAPI

ファイルやストリームからCSVを読み込み、クラスや動的オブジェクトにマッピングできます。

逆に、オブジェクトをCSV形式で書き出すことも容易です。

- カスタムマッピングのサポート

CSVの列とクラスのプロパティを柔軟にマッピング可能です。

列名が異なる場合や、特定の列を無視したい場合にも対応できます。

- 多様なCSV仕様への対応

区切り文字(カンマ以外も可)、引用符の有無、改行コードの違いなど、さまざまなCSVフォーマットに対応しています。

- パフォーマンスとメモリ効率

ストリームを使った逐次処理が可能で、大きなCSVファイルも効率よく扱えます。

- 例外処理と検証機能

不正なデータやフォーマットエラーを検出しやすく、堅牢なデータ処理が可能です。

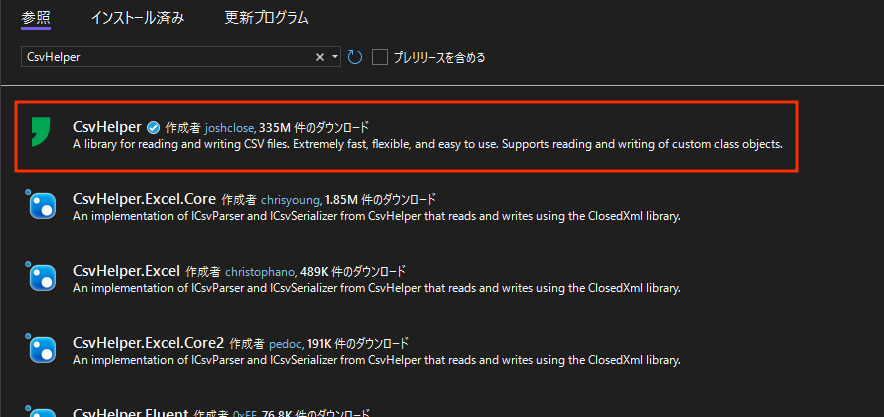

CsvHelperは、Nugetからインストールする必要があります。

「CsvHelper」と検索してインストールするようにしてください。

dotnet add package CsvHelper以下は、CsvHelperを使ってCSVファイルを読み込む例です。

using CsvHelper;

using CsvHelper.Configuration;

using System.Globalization;

using System.IO;

using System.Linq;

using System;

public class Person

{

public string Name { get; set; }

public int Age { get; set; }

}

class Program

{

static void Main()

{

var config = new CsvConfiguration(CultureInfo.InvariantCulture)

{

HasHeaderRecord = true,

Delimiter = ","

};

using var reader = new StringReader("Name,Age\n花子,25\n");

using var csv = new CsvReader(reader, config);

var records = csv.GetRecords<Person>().ToList();

foreach (var person in records)

{

Console.WriteLine($"名前: {person.Name}, 年齢: {person.Age}");

}

}

}名前: 花子, 年齢: 25このように、CSVの内容を簡単にクラスのリストに変換できます。

相互補完的なメリット

Newtonsoft.JsonとCsvHelperは、それぞれJSONとCSVの操作に特化していますが、両者を組み合わせることで、JSONとCSVの相互変換をスムーズに行えます。

特に、ネストしたJSONデータをフラットなCSVに変換したり、CSVの階層的な情報をJSONのネスト構造に復元したりする際に威力を発揮します。

主なメリットは以下の通りです。

- ネスト構造の柔軟な処理

Newtonsoft.JsonのJObjectやJArrayを使ってJSONの階層を再帰的に解析し、キーを連結してCSVのヘッダーに展開できます。

逆に、CSVのヘッダーを解析して階層構造を復元し、JObjectでJSONを組み立てられます。

- 型安全かつ動的なデータ操作

JSONの型情報を保持しつつ、CSVの文字列データと相互に変換可能です。

CsvHelperのマッピング機能を活用すれば、型変換やカスタムフォーマットも簡単に実装できます。

- 大規模データの効率的処理

CsvHelperのストリーム処理とNewtonsoft.Jsonの高速パースを組み合わせることで、大量のデータもメモリ効率よく処理できます。

- カスタマイズ性の高さ

両ライブラリとも拡張性が高く、独自の変換ルールやエスケープ処理、エラーハンドリングを柔軟に実装できます。

- コミュニティとドキュメントの充実

どちらも広く使われているため、情報が豊富でトラブルシューティングもしやすいです。

このように、Newtonsoft.JsonとCsvHelperを組み合わせることで、C#でのJSONとCSVの相互変換がより簡単かつ堅牢になります。

基本フロー

データ受け渡しの全体像

JSONとCSVの相互変換では、データの構造やフォーマットの違いを意識しながら、変換処理を段階的に進めることが重要です。

基本的な流れは以下のようになります。

- 入力データの読み込み

JSONファイルや文字列、CSVファイルや文字列を読み込みます。

ファイルの場合はストリームを使うことが多いです。

- データのパース(解析)

JSONの場合はNewtonsoft.JsonのJObjectやJArrayを使って階層構造を解析し、CSVの場合はCsvHelperでヘッダーとデータ行を読み込みます。

- 中間表現の生成

JSONのネスト構造をフラットなキーの集合に変換したり、CSVのヘッダーを解析して階層構造の辞書型に変換したりします。

ここで、キーの連結や分割を行い、データの対応関係を明確にします。

- データの変換処理

JSONからCSVへは、フラット化したキーをヘッダーにして、対応する値を行データとして並べます。

CSVからJSONへは、ヘッダーの階層情報をもとにネストしたオブジェクトを再構築し、値をセットします。

- 出力データの生成

変換後のデータを文字列やファイルに書き出します。

CSVの場合はCsvHelperの書き込み機能を使い、JSONの場合はNewtonsoft.Jsonのシリアライズ機能を使います。

この流れを踏むことで、ネストしたJSONデータをCSVのフラットな形式に変換し、またCSVの階層的な情報をJSONのネスト構造に復元できます。

特に、キーの連結(例:parent:child:grandchild)や分割が重要な役割を果たします。

ストリーム利用のメリット

データの読み書きにストリームを利用することは、特に大規模なファイルを扱う際に多くのメリットがあります。

- メモリ効率の向上

ファイル全体を一度にメモリに読み込むのではなく、ストリームを使うことで必要な部分だけを逐次的に処理できます。

これにより、メモリ使用量を抑えられ、大きなファイルでも安定して処理可能です。

- パフォーマンスの改善

ストリームはバッファリングを活用し、I/O操作を効率化します。

読み込みや書き込みの待ち時間を減らし、全体の処理速度を向上させます。

- リアルタイム処理への対応

ストリームはデータが到着するたびに処理できるため、ファイルだけでなくネットワーク経由のデータやパイプライン処理にも適しています。

- 柔軟な入出力先の指定

ストリームはファイル、メモリ、ネットワーク、圧縮ファイルなど多様な入出力先に対応可能です。

これにより、変換処理をさまざまな環境で活用できます。

たとえば、CsvHelperではStreamReaderやStreamWriterを使ってCSVの読み書きを行い、Newtonsoft.JsonでもStreamReaderからJSONを読み込んだり、StreamWriterに書き出したりできます。

以下は、ストリームを使ってCSVを読み込み、JSONに変換する簡単な例です。

using System;

using System.IO;

using CsvHelper;

using CsvHelper.Configuration;

using Newtonsoft.Json;

using System.Globalization;

using System.Collections.Generic;

public class Person

{

public string Name { get; set; }

public int Age { get; set; }

}

class Program

{

static void Main()

{

string csvContent = "Name,Age\n太郎,28\n花子,24\n";

using var reader = new StringReader(csvContent);

var config = new CsvConfiguration(CultureInfo.InvariantCulture)

{

HasHeaderRecord = true,

Delimiter = ","

};

using var csv = new CsvReader(reader, config);

var records = csv.GetRecords<Person>();

string json = JsonConvert.SerializeObject(records, Formatting.Indented);

Console.WriteLine(json);

}

}[

{

"Name": "太郎",

"Age": 28

},

{

"Name": "花子",

"Age": 24

}

]この例では、文字列をStringReaderでストリーム化し、CsvHelperで読み込んだ後、Newtonsoft.JsonでJSONに変換しています。

ファイルを使う場合も同様にFileStreamやStreamReaderを使うだけで、メモリ効率よく処理できます。

JSON→CSV変換の実装

変換シナリオの選択

JSONからCSVへの変換は、データの構造や用途によって最適なシナリオが異なります。

単純なフラットなJSONなら直接的に変換できますが、ネストしたオブジェクトや配列を含む場合は工夫が必要です。

主な変換シナリオは以下の3つです。

- フラットJSONの直接変換

キーと値が1階層で並んでいる場合、キーをCSVのヘッダーに、値を行データにそのままマッピングします。

最もシンプルで高速です。

- ネストJSONのフラット化変換

ネストしたオブジェクトのキーを連結して1行のCSVに展開します。

例えば、{ "a": { "b": 1 } }はa:bというヘッダーに変換します。

階層の深さに制限がない場合に有効です。

- 配列を含むJSONの展開

配列がある場合、配列の要素ごとに複数行に分割するか、配列の要素をカンマ区切りなどで1セルにまとめるかを選択します。

用途に応じて使い分けます。

変換の要件に応じて、どのシナリオを採用するか決めることが重要です。

ここでは、ネストしたオブジェクトをキー連結でフラット化し、配列は1セルにカンマ区切りでまとめる方法を中心に解説します。

フラット化アルゴリズム

再帰展開とキー連結

ネストしたJSONをCSVに変換する際は、再帰的にオブジェクトを展開し、キーを連結してフラットな構造に変換します。

キーの連結には区切り文字(例:コロン:やドット.)を使い、階層を表現します。

以下のポイントを押さえます。

- 再帰的に辞書型を展開

JObjectやDictionary<string, object>を再帰的に処理し、子オブジェクトのキーを親のキーに連結します。

- キーの連結ルール

親キーと子キーを:でつなぐ例:parent:child。

これにより、CSVのヘッダーで階層を表現できます。

- 値がプリミティブ型の場合はそのまま格納

文字列、数値、真偽値などは連結したキーに対応する値としてセットします。

- Nullや空オブジェクトの扱い

Nullは空文字列に変換し、空オブジェクトはキーを生成しないか空文字列をセットします。

以下は再帰展開のイメージです。

void FlattenJson(string parentKey, JObject obj, Dictionary<string, string> flatDict)

{

foreach (var prop in obj.Properties())

{

string newKey = string.IsNullOrEmpty(parentKey) ? prop.Name : $"{parentKey}:{prop.Name}";

if (prop.Value.Type == JTokenType.Object)

{

FlattenJson(newKey, (JObject)prop.Value, flatDict);

}

else if (prop.Value.Type == JTokenType.Array)

{

// 配列は別途処理

}

else

{

flatDict[newKey] = prop.Value.ToString();

}

}

}配列要素の取り扱い

配列はCSV変換で特に扱いが難しい部分です。

主に以下の2つの方法があります。

- 配列を1セルにまとめる

配列の要素をカンマやセミコロンで連結し、1つのセルに格納します。

単純で扱いやすいですが、配列内にカンマがある場合はエスケープが必要です。

- 配列の要素ごとに複数行を生成する

配列の各要素を別行として展開し、他のフィールドは繰り返す方法です。

データの正規化に近い形ですが、行数が増えます。

ここでは1セルにまとめる方法を例示します。

if (prop.Value.Type == JTokenType.Array)

{

var array = (JArray)prop.Value;

var elements = array.Select(e => e.ToString());

flatDict[newKey] = string.Join(";", elements);

}このように、配列の要素をセミコロン区切りで1セルに格納します。

必要に応じて区切り文字はカスタマイズ可能です。

ヘッダー生成ロジック

キー順序の保持

CSVのヘッダーはデータの意味を示す重要な要素です。

JSONのキーは辞書型で順序が保証されないことが多いため、ヘッダーの順序を明確に保持する工夫が必要です。

- 最初のデータ行からキーを抽出

最初にフラット化した辞書のキーをリストに保存し、ヘッダーとして使います。

- 全データのキーを集約して順序を決定

複数行のJSONを変換する場合は、全行のキーを集めて重複を除き、順序を決めます。

一般的には最初に出現した順を優先します。

- 順序を保持するコレクションを使う

List<string>やLinkedHashSetのような順序付きコレクションを使うと便利です。

以下はキー順序を保持しながらヘッダーを作る例です。

var headerKeys = new List<string>();

foreach (var record in jsonRecords)

{

var flatDict = new Dictionary<string, string>();

FlattenJson("", record, flatDict);

foreach (var key in flatDict.Keys)

{

if (!headerKeys.Contains(key))

headerKeys.Add(key);

}

}カスタム区切り記号対応

キーの連結に使う区切り記号は、用途やCSVの仕様に応じて変更可能です。

一般的にはコロン:やドット.が使われますが、以下の点に注意します。

- 区切り記号がデータに含まれないこと

データのキーや値に区切り記号が含まれると誤解釈の原因になるため、避けるかエスケープ処理を行います。

- CSVの区切り文字と混同しないこと

CSVの区切り文字(通常はカンマ,)と異なる文字を使うことで、パース時の混乱を防ぎます。

- ユーザーが設定可能にする

ライブラリやツールの設定で区切り記号を変更できるようにすると柔軟性が高まります。

例として、区切り記号をドット.に変更するコードは以下の通りです。

string newKey = string.IsNullOrEmpty(parentKey) ? prop.Name : $"{parentKey}.{prop.Name}";データ行のエンコード

CSVのデータ行では、値にカンマや改行、引用符が含まれる場合に適切なエスケープが必要です。

CsvHelperを使う場合は自動的に処理されますが、自前で実装する場合は以下のルールを守ります。

- 値にカンマ、改行、引用符が含まれる場合はダブルクォーテーションで囲む

例:"Tokyo, Japan"や"Line1\nLine2"。

- 値内のダブルクォーテーションは2つ連続にする

例:He said "Hello" → "He said ""Hello"""。

- Nullや空文字は空セルとして扱う

空文字列は""とするか空欄にします。

CsvHelperを使う場合は、これらの処理を意識せずに済みます。

生成ファイルの検証ポイント

JSONからCSVに変換したファイルは、以下のポイントを検証すると品質を保てます。

| 検証項目 | 内容 |

|---|---|

| ヘッダーの整合性 | すべてのキーがヘッダーに含まれているか、順序は適切か |

| データ行のカラム数 | 各行のカラム数がヘッダーのカラム数と一致しているか |

| エスケープの正確さ | カンマや改行、引用符が正しくエスケープされているか |

| ネスト情報の表現 | キー連結が正しく行われているか、階層が失われていないか |

| 配列の表現 | 配列要素が意図した区切り文字でまとめられているか |

| 文字コード | UTF-8など指定したエンコーディングで保存されているか |

| 空値・Nullの扱い | 空値やNullが適切に空セルや空文字列として表現されているか |

これらをチェックすることで、後続のCSV読み込みや他システムへの連携時のトラブルを防げます。

特にネスト構造のキー連結や配列の表現は、変換ルールに沿っているかを重点的に確認してください。

CSV→JSON変換の実装

パス解析アルゴリズム

CSVのヘッダーに連結されたキー(例:parent:child:grandchild)を元に、JSONのネスト構造を復元するためには、キーの分割と型推論を正確に行う必要があります。

これを実現するのがパス解析アルゴリズムです。

連結キーの分割復元

CSVのヘッダーは階層を表現するために区切り文字(一般的にはコロン:やドット.)でキーを連結しています。

これを分割して、JSONの階層構造に戻す処理が必要です。

具体的には、以下の手順で処理します。

- ヘッダー文字列の分割

例えば、"b:c:d"というヘッダーは["b", "c", "d"]に分割します。

- 階層的な辞書構造の構築

分割したキー配列を使い、親子関係を持つ辞書を再帰的に作成します。

{

"b": {

"c": {

"d": ""

}

}

}- 既存の辞書にキーを追加

複数のヘッダーを処理する際は、既に存在するキーは上書きせずに階層を拡張します。

以下は分割復元のイメージコードです。

void AddPathToDict(string[] keys, int index, Dictionary<string, object> dict)

{

if (index == keys.Length - 1)

{

dict[keys[index]] = ""; // 値は後でセット

return;

}

if (!dict.ContainsKey(keys[index]))

{

dict[keys[index]] = new Dictionary<string, object>();

}

AddPathToDict(keys, index + 1, (Dictionary<string, object>)dict[keys[index]]);

}このようにして、CSVのヘッダーからJSONのネスト構造の骨格を作ります。

数値判定と型推論

CSVのデータはすべて文字列として読み込まれますが、JSONでは数値や真偽値、Nullなどの型を正しく表現したい場合があります。

そこで、値の型推論を行い、適切な型に変換します。

主な判定ルールは以下の通りです。

- 整数判定

int.TryParseで整数に変換可能かチェックします。

- 浮動小数点判定

double.TryParseで浮動小数点数に変換可能かチェックします。

- 真偽値判定

"true"や"false"(大文字小文字問わず)をBoolean型に変換します。

- Null判定

空文字列や"null"(大文字小文字問わず)をnullとして扱います。

- 文字列として扱う

上記に該当しない場合は文字列型のまま扱います。

型推論の例コードは以下の通りです。

object InferType(string value)

{

if (string.IsNullOrEmpty(value) || value.Equals("null", StringComparison.OrdinalIgnoreCase))

return null;

if (int.TryParse(value, out int intVal))

return intVal;

if (double.TryParse(value, out double doubleVal))

return doubleVal;

if (bool.TryParse(value, out bool boolVal))

return boolVal;

return value;

}この関数を使って、CSVの各セルの値を適切な型に変換し、JSONの値としてセットします。

ネスト構築処理

JObjectとJArrayの動的生成

CSVのヘッダーから作成した階層構造の辞書と、型推論した値を使って、Newtonsoft.JsonのJObjectやJArrayを動的に生成します。

- JObjectの生成

辞書のキーがオブジェクトの場合はJObjectを作成し、子要素を再帰的に追加します。

- JArrayの生成

配列を表現する場合は、CSVのセル内に区切り文字で複数の値が入っていることが多いため、これを分割してJArrayに変換します。

- 値のセット

型推論した値をJValueとしてJObjectやJArrayにセットします。

以下は再帰的にJObjectを構築するイメージコードです。

JToken BuildJToken(Dictionary<string, object> dict, string[] values, ref int index)

{

var obj = new JObject();

foreach (var key in dict.Keys)

{

if (dict[key] is Dictionary<string, object> childDict)

{

obj[key] = BuildJToken(childDict, values, ref index);

}

else

{

var val = InferType(values[index]);

obj[key] = val == null ? JValue.CreateNull() : new JValue(val);

index++;

}

}

return obj;

}配列のセルをJArrayに変換する場合は、区切り文字で分割し、各要素をInferTypeで型変換して追加します。

出力整形オプション

インデントとNull値制御

JSONの出力は用途に応じて整形を変えられます。

Newtonsoft.JsonのJsonConvert.SerializeObjectでは、以下のオプションがよく使われます。

- インデントの有無

Formatting.Indentedを指定すると、改行やスペースを入れて見やすく整形します。

ログやデバッグ用に便利です。

Formatting.Noneはコンパクトな1行出力になります。

- Null値の制御

JsonSerializerSettingsのNullValueHandlingで、Null値を出力するか省略するかを指定できます。

例:NullValueHandling.Ignoreにすると、NullのプロパティはJSONに含まれません。

- その他の設定

プロパティ名の変換(キャメルケース化など)、日付フォーマットの指定なども可能です。

以下は整形オプションを指定した例です。

var settings = new JsonSerializerSettings

{

Formatting = Formatting.Indented,

NullValueHandling = NullValueHandling.Ignore

};

string json = JsonConvert.SerializeObject(jObject, settings);

Console.WriteLine(json);このように、用途に応じて見やすさやファイルサイズを調整できます。

ネスト構造への対応

深い階層のパフォーマンス課題

JSONのネスト構造が深くなると、再帰的な処理が増え、パフォーマンスに影響が出やすくなります。

特に、深い階層を持つデータをフラット化してCSVに変換する際や、CSVからネストしたJSONを再構築する際に注意が必要です。

主な課題は以下の通りです。

- 再帰呼び出しのコスト増大

再帰的にオブジェクトを展開・構築する処理は、呼び出し回数が増えるほどスタックの使用量が増え、処理時間も長くなります。

深い階層ではスタックオーバーフローのリスクもあります。

- メモリ使用量の増加

階層ごとに中間データを保持するため、メモリ消費が増加します。

特に大量のデータを一括処理する場合は注意が必要です。

- キー連結文字列の長大化

階層が深いと、CSVのヘッダーに使う連結キーが長くなり、可読性や管理性が低下します。

対策としては以下が有効です。

- 再帰の代わりにスタックやキューを使ったループ処理

明示的なデータ構造で階層を管理し、再帰を避けることでスタックオーバーフローを防ぎます。

- 処理の分割・バッチ化

大きなデータは分割して処理し、メモリ負荷を分散します。

- キーの省略やマッピング

長いキーは短縮形やマッピングテーブルを使って管理しやすくします。

- 必要な階層だけを展開

すべての階層を展開せず、必要な部分だけを処理することで効率化します。

配列とオブジェクト混在ケース

JSONでは、配列の中にオブジェクトがあり、そのオブジェクトの中にさらに配列があるなど、配列とオブジェクトが複雑に混在するケースがよくあります。

これをCSVに変換する際は特に工夫が必要です。

主なポイントは以下の通りです。

- 配列の展開方法の選択

配列を1セルにまとめるか、複数行に分割するかを決めます。

複数行に分割する場合は、親の情報を繰り返し出力する必要があります。

- ネストした配列の扱い

配列の中にさらに配列がある場合、CSVの1セルにまとめるか、複数の列や行に分割するか、変換ルールを明確にします。

- オブジェクトのキー連結との整合性

配列内のオブジェクトのキーは親のキーと連結し、階層を表現します。

例えば、items:0:nameのようにインデックスを含める方法もあります。

- インデックスの扱い

配列の要素番号をキーに含めるかどうかで、CSVのヘッダーや行数が変わります。

以下は配列とオブジェクトが混在する例のイメージです。

{

"order": {

"id": 123,

"items": [

{ "name": "りんご", "qty": 2 },

{ "name": "みかん", "qty": 3 }

]

}

}これをCSVに変換する場合、

- 1セルにまとめる場合:

order:id,order:items

123,"name:りんご;qty:2|name:みかん;qty:3"

- 複数行に分割する場合:

order:id,order:items:name,order:items:qty

123,りんご,2

123,みかん,3用途に応じて適切な方法を選びます。

空オブジェクト・Nullの扱い

JSONのネスト構造には、空のオブジェクトやNull値が含まれることがあります。

これらをCSVに変換・復元する際は、以下の点に注意します。

- 空オブジェクトの表現

空オブジェクトはキーは存在するが値がない状態です。

CSVでは空文字列や特定のマーカー(例:{})で表現することが多いですが、明確なルールを決めておく必要があります。

- Null値の扱い

NullはCSVの空セルとして表現されることが多いですが、空文字とNullを区別したい場合は特別な文字列(例:NULL)を使うこともあります。

- 復元時の判別

CSVからJSONに戻す際、空文字列をNullに変換するか空オブジェクトにするかは変換ルールに依存します。

明示的に区別したい場合は、ヘッダーやメタ情報で管理します。

- 影響範囲の考慮

空オブジェクトやNullが多いと、CSVの行や列が空欄だらけになることがあり、可読性や処理効率に影響します。

以下は空オブジェクトとNullの例です。

{

"user": {

"name": "太郎",

"address": {}, // 空オブジェクト

"phone": null // Null値

}

}CSVに変換すると、

| user:name | user:address | user:phone |

|---|---|---|

| 太郎 |

空セルが空オブジェクトとNullの両方を表しているため、復元時に区別が難しい場合があります。

用途に応じて、空オブジェクトは{}、NullはNULLなどの文字列で区別する方法も検討してください。

型安全を保つマッピング

JSONとCSVの相互変換において、型安全を保つことはデータの整合性を維持し、バグを防ぐうえで非常に重要です。

ここでは、C#のクラスマップを使った型安全なマッピング方法、動的型と静的型の併用、さらにEnumやDateTimeのカスタム変換について詳しく解説します。

クラスマップ定義例

CsvHelperでは、CSVの列とC#のクラスのプロパティを明示的にマッピングするために「クラスマップ」を定義できます。

これにより、CSVの列名が異なっていても正確にデータを読み書きでき、型安全な処理が可能になります。

以下は、PersonクラスとCSVの列をマッピングするクラスマップの例です。

using CsvHelper.Configuration;

public class Person

{

public string Name { get; set; }

public int Age { get; set; }

public bool IsMember { get; set; }

}

public sealed class PersonMap : ClassMap<Person>

{

public PersonMap()

{

Map(m => m.Name).Name("名前");

Map(m => m.Age).Name("年齢");

Map(m => m.IsMember).Name("会員フラグ");

}

}このクラスマップを使うことで、CSVの「名前」「年齢」「会員フラグ」という列が、それぞれPersonクラスのName、Age、IsMemberプロパティに対応します。

読み込み時の使用例は以下の通りです。

using var reader = new StreamReader("people.csv");

using var csv = new CsvReader(reader, CultureInfo.InvariantCulture);

csv.Context.RegisterClassMap<PersonMap>();

var records = csv.GetRecords<Person>().ToList();

foreach (var person in records)

{

Console.WriteLine($"名前: {person.Name}, 年齢: {person.Age}, 会員: {person.IsMember}");

}このように、クラスマップを使うことでCSVの列名とクラスのプロパティを明確に結びつけ、型安全にデータを扱えます。

動的型と静的型の併用

JSONやCSVのデータ構造が固定されていない場合、すべてを静的型で表現するのは難しいことがあります。

そこで、静的型と動的型dynamicやJObjectを併用する方法が有効です。

- 静的型の利点

コンパイル時に型チェックが行われ、IDEの補完やリファクタリングが効きやすい。

バグの早期発見に役立ちます。

- 動的型の利点

事前に構造がわからないJSONや可変的なデータに柔軟に対応可能です。

ネスト構造の深いJSONを扱う際に便利です。

たとえば、基本的な情報は静的型のクラスで表現し、拡張情報や不定形のデータはJObjectで保持する設計が考えられます。

using Newtonsoft.Json.Linq;

public class User

{

public string Id { get; set; }

public string Name { get; set; }

public JObject AdditionalData { get; set; } // 動的な拡張情報

}このようにすることで、基本的な部分は型安全に扱いながら、柔軟なデータ構造も保持できます。

EnumやDateTimeのカスタム変換

CSVやJSONのデータには、列挙型(Enum)や日時(DateTime)など、標準の文字列変換だけでは扱いにくい型が含まれることがあります。

これらはカスタムコンバーターを使って変換処理を制御すると、より安全で正確なマッピングが可能です。

Enumのカスタム変換

CsvHelperでは、TypeConverterを実装してEnumの文字列と値の変換をカスタマイズできます。

using CsvHelper;

using CsvHelper.Configuration;

using CsvHelper.TypeConversion;

public enum Status

{

Active,

Inactive,

Pending

}

public class StatusConverter : DefaultTypeConverter

{

public override object ConvertFromString(string text, IReaderRow row, MemberMapData memberMapData)

{

return text.ToLower() switch

{

"active" => Status.Active,

"inactive" => Status.Inactive,

"pending" => Status.Pending,

_ => base.ConvertFromString(text, row, memberMapData)

};

}

public override string ConvertToString(object value, IWriterRow row, MemberMapData memberMapData)

{

return value switch

{

Status.Active => "active",

Status.Inactive => "inactive",

Status.Pending => "pending",

_ => base.ConvertToString(value, row, memberMapData)

};

}

}

public sealed class UserMap : ClassMap<User>

{

public UserMap()

{

Map(m => m.Status).TypeConverter<StatusConverter>();

}

}このように、CSVの文字列とEnum値の間で自由に変換ルールを定義できます。

DateTimeのカスタム変換

日時のフォーマットは多様で、標準のISO形式以外の文字列を扱う場合はカスタム変換が必要です。

public class CustomDateTimeConverter : DefaultTypeConverter

{

private readonly string _format = "yyyy/MM/dd";

public override object ConvertFromString(string text, IReaderRow row, MemberMapData memberMapData)

{

if (DateTime.TryParseExact(text, _format, CultureInfo.InvariantCulture, DateTimeStyles.None, out var date))

{

return date;

}

return base.ConvertFromString(text, row, memberMapData);

}

public override string ConvertToString(object value, IWriterRow row, MemberMapData memberMapData)

{

if (value is DateTime date)

{

return date.ToString(_format);

}

return base.ConvertToString(value, row, memberMapData);

}

}クラスマップで指定して使います。

Map(m => m.BirthDate).TypeConverter<CustomDateTimeConverter>();このようにカスタムコンバーターを活用することで、EnumやDateTimeの変換を正確かつ柔軟に制御できます。

型安全を保ちながら、実際のデータフォーマットに合わせた変換が可能になるため、変換ミスや例外の発生を減らせます。

パフォーマンス最適化

大量のJSONやCSVデータを相互変換する際は、パフォーマンスの最適化が重要です。

ここでは、バッファリング戦略、並列処理の導入ポイント、そして計測とプロファイル手法について詳しく解説します。

バッファリング戦略

ファイルやストリームの読み書きにおいて、バッファリングはI/O性能を大幅に向上させる基本的な手法です。

バッファリングを適切に設定することで、ディスクやネットワークへのアクセス回数を減らし、処理速度を改善できます。

- バッファサイズの調整

デフォルトのバッファサイズは一般的に4KB〜8KB程度ですが、処理するデータ量や環境に応じて最適なサイズを検討します。

大きすぎるとメモリ消費が増え、小さすぎるとI/O回数が増加します。

- ストリームのバッファリング

StreamReaderやStreamWriterのコンストラクタでバッファサイズを指定可能です。

例えば、以下のように設定します。

using var fileStream = new FileStream("data.csv", FileMode.Open, FileAccess.Read, FileShare.Read, bufferSize: 65536);

using var reader = new StreamReader(fileStream, Encoding.UTF8, detectEncodingFromByteOrderMarks: true, bufferSize: 65536);- メモリバッファの活用

一時的にメモリ上でデータをバッファリングし、まとめて書き込むことでディスクアクセスを減らせます。

MemoryStreamやBufferedStreamを活用するケースもあります。

- CsvHelperのバッファリング

CsvHelperは内部でストリームを使うため、上記のバッファリング設定がそのまま効果を発揮します。

特に大規模ファイルの読み書き時はバッファサイズを大きめに設定すると良いでしょう。

バッファリングはI/O性能のボトルネックを緩和するための基本ですが、過剰なバッファサイズはメモリ不足を招くため、環境に合わせて調整してください。

並列処理の導入ポイント

CPUリソースを有効活用するために、並列処理を導入することもパフォーマンス向上に効果的です。

ただし、I/Oバウンドな処理が多い場合は効果が限定的なこともあるため、適切なポイントで並列化を行う必要があります。

- データ分割による並列処理

大きなJSON配列やCSVファイルを複数のチャンクに分割し、それぞれを別スレッドやタスクで処理します。

処理後に結果を統合する形です。

- 非同期I/Oとの組み合わせ

ファイル読み書きやネットワーク通信は非同期APIを使い、CPUの待機時間を減らします。

async/awaitと組み合わせると効率的です。

- スレッドセーフなデータ構造の利用

並列処理中に共有データへアクセスする場合は、ConcurrentDictionaryやConcurrentQueueなどスレッドセーフなコレクションを使います。

- 並列処理の粒度調整

あまり細かく分割しすぎるとスレッド管理コストが増え逆効果になるため、適切な粒度で分割します。

- 例:Parallel.ForEachを使ったJSON配列の並列処理

using Newtonsoft.Json.Linq;

using System.Collections.Concurrent;

using System.Threading.Tasks;

JArray jsonArray = JArray.Parse(largeJsonString);

var results = new ConcurrentBag<Dictionary<string, string>>();

Parallel.ForEach(jsonArray, item =>

{

var flatDict = new Dictionary<string, string>();

FlattenJson("", (JObject)item, flatDict);

results.Add(flatDict);

});このように、複数のJSONオブジェクトを並列にフラット化し、処理時間を短縮できます。

計測とプロファイル手法

パフォーマンス最適化の効果を正確に把握するためには、計測とプロファイリングが欠かせません。

適切なツールと手法を使い、ボトルネックを特定しましょう。

- ストップウォッチによる簡易計測

System.Diagnostics.Stopwatchを使い、処理時間を計測します。

コードの特定部分の実行時間を測るのに便利です。

var sw = Stopwatch.StartNew();

// 処理

sw.Stop();

Console.WriteLine($"処理時間: {sw.ElapsedMilliseconds} ms");- Visual Studioのプロファイラー

CPU使用率、メモリ消費、呼び出し回数など詳細な情報を取得可能です。

パフォーマンスのボトルネックを視覚的に把握できます。

- dotnet-traceやdotnet-counters

.NET Core/.NET 5以降の環境で使えるコマンドラインツール。

リアルタイムのパフォーマンスデータを収集できます。

- メモリプロファイラー

メモリリークや過剰なメモリ消費を検出するために、JetBrains dotMemoryやVisual Studioの診断ツールを活用します。

- ログ出力による詳細分析

処理の各段階でログを出力し、どの処理に時間がかかっているかを分析します。

ログレベルを調整して詳細度を制御可能です。

- ベンチマークライブラリの活用

BenchmarkDotNetなどのライブラリを使い、細かい処理単位の性能比較や最適化効果の検証ができます。

これらの計測・プロファイル手法を組み合わせて使うことで、効率的にパフォーマンス改善のポイントを見つけ、効果的な最適化を実施できます。

文字エンコーディングとエスケープ

JSONとCSVの相互変換において、文字エンコーディングや特殊文字のエスケープ処理はデータの正確な読み書きに欠かせません。

ここでは、UTF-8のBOMの有無問題、改行やカンマの引用符処理、非ASCII文字の正規化について詳しく解説します。

UTF-8 BOM有無問題

UTF-8エンコーディングには、ファイルの先頭に「BOM(Byte Order Mark)」と呼ばれる特別なバイト列を付加する場合があります。

BOMはエンディアンの判別に使われることが多いですが、UTF-8では必須ではありません。

- BOMありの特徴

ファイルの先頭に3バイト0xEF 0xBB 0xBFが付加されます。

Windowsの一部アプリケーションやエディタはBOMありのUTF-8を標準とすることがあります。

- BOMなしの特徴

BOMがないUTF-8ファイルは多くのツールで標準的に扱われます。

BOMがないほうが互換性が高い場合もあります。

- 問題点

CSVやJSONのパーサーがBOMを正しく認識しないと、先頭の文字列にBOMが混入し、データの読み込みエラーや不正な文字列になることがあります。

- 対策

C#のStreamReaderやStreamWriterは、BOMの有無を自動的に判別・付加できます。

明示的にBOMを付けたい場合はnew UTF8Encoding(true)、付けたくない場合はnew UTF8Encoding(false)を使います。

// BOMありで書き込み

using var writer = new StreamWriter("file.csv", false, new UTF8Encoding(true));

// BOMなしで書き込み

using var writerNoBom = new StreamWriter("file.csv", false, new UTF8Encoding(false));- 実務上のポイント

受け渡し先のシステムやツールの仕様に合わせてBOMの有無を調整することが重要です。

特にWindows環境とLinux環境での互換性に注意してください。

改行・カンマの引用符処理

CSVはカンマ区切りのテキスト形式ですが、データの中にカンマや改行、引用符が含まれる場合は適切なエスケープ処理が必要です。

これを怠ると、CSVのパース時に列の分割が誤ったり、データが破損したりします。

- カンマや改行を含む値の囲み

値にカンマ,や改行\nや\r\nが含まれる場合、その値はダブルクォーテーション"で囲みます。

- ダブルクォーテーションのエスケープ

値の中にダブルクォーテーションが含まれる場合は、"を2つ連続""にしてエスケープします。

- 例

| 値の例 | CSV表現 |

|---|---|

| Tokyo, Japan | “Tokyo, Japan” |

| He said “Hello” | “He said “”Hello””” |

| 複数行のテキスト\n改行あり | “複数行のテキスト\n改行あり” |

- CsvHelperの対応

CsvHelperはこれらのエスケープ処理を自動で行うため、ユーザーが意識する必要はほとんどありません。

ただし、自前でCSVを生成する場合は必ずこれらのルールを守る必要があります。

- JSONのエスケープ

JSONでは改行や引用符はバックスラッシュでエスケープします。

Newtonsoft.Jsonは自動的に適切なエスケープを行います。

非ASCII文字と正規化

日本語などの非ASCII文字を含むデータを扱う場合、文字コードの扱いだけでなく、Unicodeの正規化も重要です。

- Unicode正規化とは

同じ見た目の文字でも、複数のUnicodeコードポイントの組み合わせで表現されることがあります。

例えば、「é」は単一コードポイント(U+00E9)でも、e(U+0065)とアクセント記号(U+0301)の組み合わせでも表現可能です。

- 正規化の種類

- NFC(Normalization Form C): 合成済み文字に変換

- NFD(Normalization Form D): 分解済み文字に変換

- なぜ正規化が必要か

データの比較や検索、ハッシュ化の際に、正規化されていないと同じ文字列でも異なる扱いになることがあります。

- C#での正規化例

using System.Text;

string original = "e\u0301"; // e + アクセント

string normalized = original.Normalize(NormalizationForm.FormC);

Console.WriteLine(normalized); // é (単一コードポイント)- ファイル入出力時の注意

入力データが正規化されていない場合は、読み込み後に正規化を行うと安全です。

出力時も統一した正規化形式に変換しておくと、後続処理でのトラブルを防げます。

- Json.NETとCsvHelperの対応

これらのライブラリは文字列の正規化を自動では行わないため、必要に応じてユーザー側で正規化処理を挟むことが推奨されます。

これらの文字エンコーディングとエスケープのポイントを押さえることで、JSONとCSVの相互変換における文字化けやデータ破損を防ぎ、安定したデータ処理が可能になります。

エラーハンドリング

JSONとCSVの相互変換処理では、データの不整合やフォーマットの誤りによる例外が発生しやすいため、適切なエラーハンドリングが不可欠です。

ここでは、パース例外の分類、ログ出力とリトライ設計、そしてフォールトトレランスの実装について詳しく解説します。

パース例外の分類

パース処理中に発生する例外は、原因や対応方法によって分類すると管理しやすくなります。

主に以下のような分類が考えられます。

- 構文エラー(Syntax Error)

JSONやCSVのフォーマット自体が不正な場合に発生します。

例えば、JSONの括弧の閉じ忘れやCSVのカンマ不足などです。

例外例:JsonReaderException(Newtonsoft.Json)、CsvHelperException(CsvHelper)

- 型変換エラー(Type Conversion Error)

期待する型に変換できない場合に発生します。

例えば、数値型に変換すべき文字列が不正な場合などです。

例外例:FormatException、InvalidCastException

- データ不整合エラー(Data Inconsistency)

データの論理的な矛盾や必須項目の欠落など、フォーマットは正しいが内容に問題がある場合です。

例:必須フィールドが空、配列の要素数が不一致など。

- I/Oエラー(Input/Output Error)

ファイルの読み書き時に発生するエラー。

ファイルが存在しない、アクセス権限がない、ディスク容量不足などが該当します。

例外例:IOException、UnauthorizedAccessException

これらの例外を適切にキャッチし、原因に応じた処理を行うことが重要です。

ログ出力とリトライ設計

エラー発生時には、原因の特定や再発防止のために詳細なログ出力が欠かせません。

また、一時的な障害に対してはリトライ処理を設計することで、処理の安定性を高められます。

- ログ出力のポイント

- 発生した例外の種類とメッセージ

- 発生箇所(メソッド名や行番号)

- 入力データの一部(機密情報に注意)

- 発生日時と処理状況

ログはファイルやデータベース、クラウドのログ管理サービスに出力し、検索や分析がしやすい形式で保存します。

- リトライ設計

- 対象処理の選定

ネットワーク通信やファイルアクセスなど、一時的に失敗する可能性がある処理に限定します。

- リトライ回数と間隔の設定

過剰なリトライはリソース浪費になるため、最大回数や指数バックオフ(リトライ間隔を徐々に延ばす)を設定します。

- 例外の種類による分岐

永続的なエラー(フォーマットエラーなど)にはリトライせず、即時エラー処理に移行します。

- C#でのリトライ例

int maxRetries = 3;

int delayMs = 1000;

for (int attempt = 1; attempt <= maxRetries; attempt++)

{

try

{

// 処理実行

ProcessData();

break; // 成功したらループを抜ける

}

catch (IOException ex) when (attempt < maxRetries)

{

Console.WriteLine($"I/Oエラー発生。リトライ {attempt} 回目: {ex.Message}");

Thread.Sleep(delayMs);

delayMs *= 2; // バックオフ

}

catch (Exception ex)

{

Console.WriteLine($"致命的エラー: {ex.Message}");

throw;

}

}フォールトトレランスの実装

フォールトトレランス(障害耐性)とは、エラーが発生してもシステム全体の停止を防ぎ、可能な限り正常な処理を継続する設計思想です。

JSONとCSVの変換処理でも、部分的なエラーを許容しつつ処理を続行することが求められます。

- 部分的なデータ無視・スキップ

不正なレコードや行だけをスキップし、他の正常なデータは処理を続けます。

エラー内容はログに記録します。

- エラーレポートの生成

処理後にエラーが発生したレコードの一覧や原因をまとめたレポートを作成し、後続の対応を容易にします。

- トランザクション管理

複数の処理が連携する場合は、途中でエラーが起きても整合性を保つためにトランザクションやロールバック機能を活用します。

- 監視とアラート

エラー発生頻度や重大度に応じて監視システムに通知し、早期対応を促します。

- 例:不正行をスキップしつつ処理を続けるサンプル

using var reader = new StreamReader("data.csv");

using var csv = new CsvReader(reader, CultureInfo.InvariantCulture);

var records = new List<Person>();

while (csv.Read())

{

try

{

var record = csv.GetRecord<Person>();

records.Add(record);

}

catch (Exception ex)

{

Console.WriteLine($"行 {csv.Context.Row} の読み込みに失敗: {ex.Message}");

// スキップして次の行へ

}

}このように、エラーハンドリングを適切に設計することで、変換処理の信頼性と安定性を高められます。

大規模データ処理

大量のJSONやCSVデータを扱う場合、メモリ使用量や処理時間が大きくなりがちです。

ここでは、メモリフットプリントの削減策、分割ファイルのストリーミング処理、そして圧縮とネットワーク転送に関するポイントを詳しく解説します。

メモリフットプリント削減策

大規模データを処理する際は、メモリ消費を抑えることが重要です。

以下の方法でメモリフットプリントを削減できます。

- 逐次処理(ストリーム処理)

ファイル全体を一度に読み込むのではなく、1行ずつまたはチャンク単位で読み込み・処理します。

CsvHelperのGetRecords<T>()は遅延読み込みをサポートしており、メモリ使用量を抑えられます。

- 不要なデータの除外

必要なカラムだけを読み込む、または処理対象外のデータをフィルタリングしてメモリに保持しないようにします。

- オブジェクトの再利用

可能な限りオブジェクトの再利用やプールを行い、GC(ガベージコレクション)の負荷を軽減します。

- 軽量なデータ構造の利用

辞書やリストの初期容量を適切に設定し、過剰なリサイズを防ぎます。

また、必要に応じて構造体structを使うことでヒープ割り当てを減らせます。

- メモリプロファイリングの活用

dotnet-countersやVisual Studioの診断ツールでメモリ使用状況を監視し、ボトルネックを特定します。

分割ファイルのストリーミング

大きなファイルを一括処理するのが難しい場合は、分割ファイルを使ったストリーミング処理が有効です。

- ファイル分割の方法

- 事前にファイルを複数の小さなファイルに分割する

- 処理中にチャンク単位で読み込み、分割して保存する

- 分割ファイルの命名規則

連番やタイムスタンプを使い、順序がわかりやすい名前を付けます。

- ストリーミング処理の実装例

分割ファイルを順番に読み込み、1ファイルずつ変換処理を行い、結果を連結または別ファイルに保存します。

foreach (var filePath in Directory.GetFiles("split_files", "*.csv").OrderBy(f => f))

{

using var reader = new StreamReader(filePath);

using var csv = new CsvReader(reader, CultureInfo.InvariantCulture);

foreach (var record in csv.GetRecords<MyData>())

{

// 逐次処理

}

}- 分割ファイルの利点

- メモリ使用量を一定に保てる

- 並列処理や分散処理がしやすい

- 障害発生時のリカバリが容易

圧縮とネットワーク転送

大規模データの保存や転送時には、圧縮を活用して通信コストやストレージ容量を削減することが一般的です。

- 圧縮フォーマットの選択

gzipやzipは広く使われており、C#ではSystem.IO.Compression名前空間で対応可能7zやlz4など高速圧縮・解凍が可能なフォーマットも検討

- ストリーム圧縮の活用

圧縮・解凍をストリーム上で行うことで、ファイル全体を展開せずに処理可能です。

using var fileStream = new FileStream("data.csv.gz", FileMode.Open);

using var gzipStream = new GZipStream(fileStream, CompressionMode.Decompress);

using var reader = new StreamReader(gzipStream);

using var csv = new CsvReader(reader, CultureInfo.InvariantCulture);- ネットワーク転送時の圧縮

HTTP通信ではContent-Encoding: gzipを使い、サーバーとクライアント間で圧縮データをやり取りできます。

これにより帯域幅を節約し、転送速度を向上させます。

- 圧縮のトレードオフ

圧縮・解凍にはCPUリソースが必要なため、処理速度と圧縮率のバランスを考慮します。

リアルタイム性が求められる場合は高速圧縮アルゴリズムを選択します。

- 圧縮ファイルの分割

圧縮ファイルも分割可能ですが、分割後は個別に解凍が必要になるため運用ルールを明確にします。

これらの対策を組み合わせることで、大規模データのJSONとCSVの相互変換を効率的かつ安定して行えます。

コマンドライン連携

C#でJSONとCSVの相互変換を行うプログラムは、コマンドラインから実行可能にすることで自動化や他のツールとの連携が容易になります。

ここでは、dotnet CLIを使った自動化方法と、パイプライン処理への組み込み例を詳しく解説します。

dotnet CLIでの自動化

dotnet CLIは.NETアプリケーションのビルドや実行をコマンドラインから操作できるツールです。

JSONとCSVの変換プログラムをコマンドラインツールとして作成し、dotnet runやビルド後の実行ファイルを使って自動化できます。

実行ファイルの作成

- コンソールアプリケーションの作成

dotnet new console -n JsonCsvConverterApp

cd JsonCsvConverterApp- 変換ロジックを実装

Program.csにJSON→CSVやCSV→JSONの変換処理を実装します。

引数で入力ファイルや出力ファイル、変換方向を受け取る設計にします。

- ビルド

dotnet build -c Release- 実行

dotnet run -- input.json output.csv --mode json2csvまたはビルド後の実行ファイルを直接使います。

./bin/Release/net6.0/JsonCsvConverterApp input.json output.csv --mode json2csv引数解析の例

System.CommandLineやMicrosoft.Extensions.Configurationを使うと、引数解析が簡単にできます。

using System;

class Program

{

static void Main(string[] args)

{

if (args.Length < 3)

{

Console.WriteLine("Usage: JsonCsvConverterApp <input> <output> --mode <json2csv|csv2json>");

return;

}

string inputFile = args[0];

string outputFile = args[1];

string mode = args[3];

if (mode == "json2csv")

{

// JSON→CSV変換処理を呼び出す

}

else if (mode == "csv2json")

{

// CSV→JSON変換処理を呼び出す

}

else

{

Console.WriteLine("Invalid mode specified.");

}

}

}バッチ処理やスケジューラとの連携

作成したCLIツールはWindowsのタスクスケジューラやLinuxのcronに登録して定期実行できます。

これにより、定期的なデータ変換やETL処理の自動化が可能です。

パイプライン組み込み例

コマンドラインツールは他のツールやスクリプトとパイプラインで連携させることができます。

標準入力(stdin)と標準出力(stdout)を活用すると、ファイルを介さずにデータを受け渡せるため効率的です。

標準入出力を使った設計

- 標準入力から読み込み

入力ファイルの代わりに標準入力からJSONやCSVデータを受け取るようにします。

- 標準出力へ書き込み

変換結果を標準出力に書き出し、次の処理にパイプで渡せるようにします。

using System;

using System.IO;

class Program

{

static void Main(string[] args)

{

string mode = args.Length > 0 ? args[0] : "json2csv";

using var reader = new StreamReader(Console.OpenStandardInput());

using var writer = new StreamWriter(Console.OpenStandardOutput());

string inputData = reader.ReadToEnd();

if (mode == "json2csv")

{

string csv = ConvertJsonToCsv(inputData);

writer.Write(csv);

}

else if (mode == "csv2json")

{

string json = ConvertCsvToJson(inputData);

writer.Write(json);

}

}

static string ConvertJsonToCsv(string json)

{

// 変換ロジックを実装

return "変換後のCSVデータ";

}

static string ConvertCsvToJson(string csv)

{

// 変換ロジックを実装

return "変換後のJSONデータ";

}

}パイプライン例(Linux/macOS)

cat data.json | dotnet run json2csv > data.csv

cat data.csv | dotnet run csv2json > data.jsonWindows PowerShell例

Get-Content data.json | dotnet run json2csv | Set-Content data.csv

Get-Content data.csv | dotnet run csv2json | Set-Content data.json他ツールとの連携

- ETLツール

Apache NiFiやAzure Data FactoryなどのETLツールの中で、コマンドラインツールを呼び出して変換処理を組み込めます。

- CI/CDパイプライン

JenkinsやGitHub Actionsのジョブ内でデータ変換を自動化し、テストやデプロイの一環として活用可能です。

このように、dotnet CLIを活用した自動化と標準入出力を使ったパイプライン連携により、JSONとCSVの変換処理を柔軟かつ効率的に組み込めます。

バージョン互換と未来の拡張

JSONとCSVの相互変換をC#で実装する際、使用する.NETのバージョンやライブラリの選択は重要なポイントです。

ここでは、.NET Standardと.NET 6の違いを中心に、将来的な拡張性を考慮した選択肢について解説します。

また、主要な代替ライブラリの比較も行います。

.NET Standardと.NET 6の差異

.NET Standardの概要

.NET Standardは、複数の.NETプラットフォーム(.NET Framework、.NET Core、Xamarinなど)で共通して利用できるAPIセットを定義した仕様です。

ライブラリを.NET Standardでターゲットすると、幅広い環境で再利用可能になります。

- メリット

- クロスプラットフォーム対応が容易

- 複数の.NET実装で同じライブラリを使える

- 既存の.NET Frameworkアプリケーションとの互換性が高い

- デメリット

- APIの範囲が限定的で、新しい機能が使えない場合がある

- パフォーマンス最適化や最新の言語機能が制限されることがある

.NET 6の概要

.NET 6は、.NET Coreの後継として統合された最新のクロスプラットフォームフレームワークです。

高速化や新機能の追加が積極的に行われており、今後の.NET開発の主流となっています。

- メリット

- 最新のC#言語機能やAPIが利用可能

- 高速なランタイムと最適化

- 長期サポート(LTS)で安定性が高い

- マルチプラットフォーム対応(Windows、Linux、macOS)

- デメリット

- 古い.NET Frameworkとの互換性は限定的

- 一部のレガシーライブラリが未対応の場合がある

JSON・CSV変換における影響

- ライブラリの対応状況

Newtonsoft.JsonやCsvHelperは.NET Standard対応版があり、.NET 6でも問題なく動作します。

ただし、.NET 6ではSystem.Text.Jsonという標準JSONライブラリが強化されており、パフォーマンスや機能面で優位です。

- パフォーマンスと機能

.NET 6の新機能を活用すると、より高速で効率的な変換処理が可能です。

例えば、System.Text.JsonのJsonSerializerは低メモリで高速なシリアライズを実現しています。

- 将来性

新規開発や長期運用を考える場合は、.NET 6をターゲットにすることが推奨されます。

既存の.NET Frameworkや.NET Standardライブラリとの互換性が必要な場合は、.NET Standardを選択するケースもあります。

代替ライブラリの比較

JSONとCSVの変換に使われる代表的なライブラリを比較し、用途に応じた選択の参考にしてください。

| ライブラリ名 | 対応フォーマット | 特徴 | 対応プラットフォーム | 備考 |

|---|---|---|---|---|

| Newtonsoft.Json | JSON | 高機能で柔軟、動的操作やカスタム変換が豊富 | .NET Framework/.NET Core/.NET 6 | 最も広く使われているJSONライブラリ |

| System.Text.Json | JSON | 高速・低メモリ、標準ライブラリ | .NET Core 3.0以降/.NET 5/6 | .NET 6で推奨される標準JSONライブラリ |

| CsvHelper | CSV | 柔軟なマッピング、カスタム変換対応 | .NET Framework/.NET Core/.NET 6 | CSV操作の定番ライブラリ |

| FlatFiles | CSV、固定長ファイル | シンプルで高速、固定長ファイルも対応 | .NET Core/.NET 5/6 | 固定長ファイルの処理が必要な場合に有効 |

| ServiceStack.Text | JSON、CSV | 高速シリアライズ、軽量 | .NET Framework/.NET Core/.NET 6 | 商用利用はライセンスに注意 |

| CsvHelper.Extensions | CSV | CsvHelperの拡張機能、より簡単なマッピング | .NET Core/.NET 5/6 | CsvHelperのラッパー的存在 |

選択のポイント

- パフォーマンス重視

System.Text.Jsonは高速かつ低メモリで、.NET 6環境でのJSON処理に最適です。

CSVはCsvHelperが安定しており、パフォーマンスも良好です。

- 機能の豊富さ

複雑なネスト構造やカスタム変換が必要な場合は、Newtonsoft.JsonとCsvHelperの組み合わせが柔軟です。

- 互換性とサポート

既存の.NET Framework環境ではNewtonsoft.JsonとCsvHelperが無難です。

新規開発なら.NET 6とSystem.Text.Jsonの組み合わせを検討してください。

- ライセンス

商用利用やオープンソースのライセンス条件も確認し、プロジェクトに適したものを選びましょう。

これらの情報を踏まえ、プロジェクトの要件や環境に合わせて.NETのバージョンやライブラリを選択し、将来的な拡張や保守性を考慮した設計を行うことが重要です。

よくある落とし穴

JSONとCSVの相互変換を行う際には、思わぬトラブルやエラーが発生しやすいポイントがあります。

ここでは、特に注意したい「浮動小数点精度の揺れ」「型未一致エラー」「CSV仕様差異による読み込み失敗」について詳しく解説します。

浮動小数点精度の揺れ

浮動小数点数floatやdoubleは、内部的に2進数で近似値として表現されるため、計算や変換の過程で微小な誤差が生じることがあります。

JSONとCSVの相互変換時にもこの問題が顕著に現れやすいです。

- 原因

- JSONシリアライズ時に小数点以下の桁数が丸められたり、指数表記に変換されたりします

- CSVに書き出す際に文字列化される過程で、精度が変わることがあります

- 逆にCSVから読み込む際に、文字列を浮動小数点に変換する際の丸め誤差

- 影響例

例えば、0.1 + 0.2の計算結果が0.30000000000000004となるように、期待した値と微妙に異なる数値が出力されることがあります。

- 対策

- シリアライズ時に小数点以下の桁数を明示的に指定します。

Newtonsoft.JsonのJsonSerializerSettingsでFloatFormatHandlingやFloatParseHandlingを調整可能です - CSV出力時に

ToString("F4")などフォーマット指定子を使い、桁数を固定します - 金額や精度が重要な値は

decimal型を使い、浮動小数点の誤差を避けます - 変換前後で値の差異を許容範囲内に収めるための検証を行います

- シリアライズ時に小数点以下の桁数を明示的に指定します。

double value = 0.1 + 0.2;

Console.WriteLine(value.ToString("F4")); // 0.3000 と表示型未一致エラー

JSONやCSVのデータをC#のクラスにマッピングする際、期待する型と実際のデータ型が一致しないとエラーが発生します。

特に動的なデータや外部からの入力ではよく起こる問題です。

- よくあるケース

- 数値型のプロパティに文字列が入っています

- 真偽値(bool)に

"true"や"false"以外の文字列が入っています - Null値が許容されていない型に入っています

- Enum型に存在しない文字列が入っています

- エラー例

FormatExceptionやInvalidCastException、JsonSerializationExceptionなどが発生します。

- 対策

- カスタムコンバーターを実装し、柔軟に型変換を行います

- Nullable型

int?やbool?を使い、Null許容にします - 入力データのバリデーションを事前に行い、不正な値を除外または修正します

- Enumの変換時は、存在しない値をデフォルトに置き換えるロジックを入れる

public enum Status { Active, Inactive }

public class User

{

public Status Status { get; set; }

}

// カスタムコンバーター例で不正値をデフォルトにCSV仕様差異による読み込み失敗

CSVは単純なテキスト形式ですが、仕様の違いや実装の差異により読み込み時に失敗することがあります。

- 主な仕様差異

- 区切り文字(カンマ

,以外にタブやセミコロンを使う場合) - 改行コード

\n、\r\n、\rの違い - 引用符の扱い(ダブルクォーテーションの有無やエスケープ方法)

- ヘッダー行の有無や列数の不一致

- 空行やコメント行の扱い

- 区切り文字(カンマ

- 読み込み失敗の例

- 区切り文字が異なり、列が正しく分割されない

- 改行コードの違いで1行が複数行に分割されてしまう

- 引用符の不正な使い方でパースエラーが発生

- ヘッダーがないのにヘッダーあり設定で読み込もうとして例外

- 対策

CsvHelperのCsvConfigurationで区切り文字や改行コード、引用符の設定を明示的に指定します- 入力ファイルの仕様を事前に確認し、設定を合わせます

- 不正な行や空行をスキップする設定を活用します

- 可能なら入力CSVのフォーマットを統一する運用ルールを設けます

var config = new CsvConfiguration(CultureInfo.InvariantCulture)

{

Delimiter = ";",

NewLine = "\r\n",

HasHeaderRecord = true,

IgnoreBlankLines = true,

Quote = '"'

};これらの落とし穴を理解し、適切な対策を講じることで、JSONとCSVの変換処理の信頼性と安定性を大幅に向上させられます。

まとめ

この記事では、C#でJSONとCSVを相互変換する際に役立つNewtonsoft.JsonとCsvHelperの特徴や基本的な変換フロー、ネスト構造の扱い方、型安全なマッピング方法、パフォーマンス最適化、文字エンコーディングの注意点、エラーハンドリング、大規模データ処理、コマンドライン連携、バージョン互換性、そしてよくある落とし穴まで幅広く解説しました。

これらを理解し実践することで、複雑なネストデータも効率的かつ安全に変換できるようになります。

![[C#] ListのデータをJSONに変換する方法を解説](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50490.png)

![[C#] DictionaryをJSON文字列に変換する方法](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50489.png)

![[C#] JSON文字列をクラスオブジェクトに変換する方法](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50488.png)

![[C#] クラスやリストからJSONファイルを作成する方法](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50487.png)

![[C#] JSON文字列をデシリアライズする方法を解説](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50486.png)

![[C#] クラスをJSON文字列にシリアライズする方法を解説](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50485.png)

![[C#] JSON文字列をDictionary(辞書)に変換する方法](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50484.png)

![[C#] 拡張子を大文字または小文字に変換する方法](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50580.png)

![[C#] ファイルパスに拡張子が含まれているか判定する方法を解説](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50582.png)

![[C#] ファイル名から拡張子を削除する方法を解説](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50576.png)

![[C#] ファイルの拡張子をチェックする方法を解説](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50573.png)

![[C#] ファイル名に拡張子を追加する方法を解説](https://af-e.net/wp-content/uploads/2024/10/thumbnail-50581.png)