【C++】OpenCVで始めるリアルタイム顔認識入門:HaarカスケードとDNNを活用した実装手順

C++とOpenCVを使えば既存のカスケード分類器やDNNモデルを読み込むだけでリアルタイム顔認識が可能です。

Webカメラ画像をcv::VideoCaptureで取得し、detectMultiScaleやnet.forwardで顔位置を抽出し、矩形を描くだけで動くため導入が容易です。

速度はパラメータ調整とGPU活用で向上し、精度は学習済みモデルの選択で決まります。

顔認識の基本

顔認識は、画像や映像の中から人の顔を検出し、識別する技術です。

リアルタイムで顔を認識するには、まず画像処理によって顔の特徴を抽出し、その特徴をもとに顔かどうかを判定する必要があります。

ここでは、顔認識の基礎となる画像処理から特徴抽出の方法、そしてOpenCVが提供する顔検出APIについて解説します。

画像処理から特徴抽出まで

顔認識の第一歩は、画像から顔の特徴を抽出することです。

特徴抽出の方法は大きく分けてIntensity(輝度)ベースの手法と機械学習ベースの手法があります。

Intensityベース手法

Intensityベース手法は、画像の輝度情報を利用して顔の特徴を捉えます。

具体的には、顔の輪郭や目、鼻、口などのパターンを輝度の変化として検出します。

代表的な方法には以下があります。

- Haar-like特徴

Haar特徴は、白黒の矩形領域の輝度差を計算し、顔の特徴を表現します。

例えば、目の部分は周囲より暗いことが多いため、特定の矩形領域の輝度差を特徴量として利用します。

Haar特徴は計算が高速で、リアルタイム処理に適しています。

- LBP(Local Binary Patterns)

LBPは、ある画素の周囲の輝度と比較して2値化し、パターンを符号化します。

顔のテクスチャを捉えるのに有効で、照明変化に強い特徴量です。

Intensityベース手法は、画像の輝度情報だけで特徴を抽出するため、計算コストが低く、リアルタイム処理に向いています。

ただし、照明条件や顔の向きに弱い場合があります。

機械学習ベース手法

機械学習ベース手法は、顔の特徴を学習データから自動的に抽出し、分類器を作成します。

近年はディープラーニングを用いた手法が主流ですが、従来の機械学習も重要です。

- AdaBoostとカスケード分類器

AdaBoostは弱い分類器を組み合わせて強力な分類器を作る手法です。

Haar特徴を用いて顔かどうかを判定する分類器を学習し、複数の分類器を段階的に適用するカスケード構造で高速化しています。

OpenCVのCascadeClassifierはこの手法を実装しています。

- サポートベクターマシン(SVM)

顔の特徴量を抽出した後、SVMで顔と非顔を分類する方法もあります。

特徴量としてHOG(Histogram of Oriented Gradients)などが使われます。

- ディープラーニング

CNN(畳み込みニューラルネットワーク)を用いて顔検出や顔認識を行います。

特徴抽出と分類を同時に行い、高い精度を実現しています。

OpenCVのdnnモジュールで利用可能です。

機械学習ベース手法は、学習に時間がかかるものの、照明や角度の変化に強く、精度が高いのが特徴です。

OpenCVが備える顔検出API

OpenCVは顔検出のための便利なAPIを提供しており、主にCascadeClassifierとdnn::Netの2つの方法があります。

これらを使うことで、複雑なアルゴリズムを自分で実装せずに顔検出が可能です。

CascadeClassifier の概要

CascadeClassifierは、Haar特徴とAdaBoost学習を用いたカスケード分類器を実装したクラスです。

OpenCVに標準で付属している学習済みのXMLファイルを読み込むことで、顔検出が簡単に行えます。

主な特徴は以下の通りです。

- 高速処理

カスケード構造により、顔でない領域を早期に除外し、処理速度を向上させています。

- 使いやすさ

detectMultiScale関数に画像を渡すだけで、顔の位置を矩形で返してくれます。

- パラメータ調整可能

スケールファクターや最小隣接矩形数など、検出精度と速度のバランスを調整できます。

- 学習済みモデルの利用

OpenCVのdata/haarcascadesフォルダに複数の顔検出用XMLファイルが用意されています。

カスケード分類器の利用にはカスケードファイルが必要です。

OpenCVをインストールすると、多くの環境ではhaarcascade_frontalface_default.xmlファイルが自動的に含まれています。以下のようなパスに存在することが多いです。

/usr/share/opencv4/haarcascades/haarcascade_frontalface_default.xmlopencv\sources\data\haarcascades\haarcascade_frontalface_default.xmlカスケードファイルをコピーしてカレントディレクトリに配置するなどをして、使える状態にしておきましょう。

以下はCascadeClassifierの基本的な使い方の例です。

#include <opencv2/opencv.hpp>

#include <iostream>

int main() {

cv::CascadeClassifier face_cascade;

if (!face_cascade.load("haarcascade_frontalface_default.xml")) {

std::cerr << "顔分類器の読み込みに失敗しました\n";

return -1;

}

cv::Mat image = cv::imread("face.jpg");

if (image.empty()) {

std::cerr << "画像の読み込みに失敗しました\n";

return -1;

}

cv::Mat gray;

cv::cvtColor(image, gray, cv::COLOR_BGR2GRAY);

std::vector<cv::Rect> faces;

face_cascade.detectMultiScale(gray, faces, 1.1, 3, 0, cv::Size(30, 30));

for (const auto& face : faces) {

cv::rectangle(image, face, cv::Scalar(255, 0, 0), 2);

}

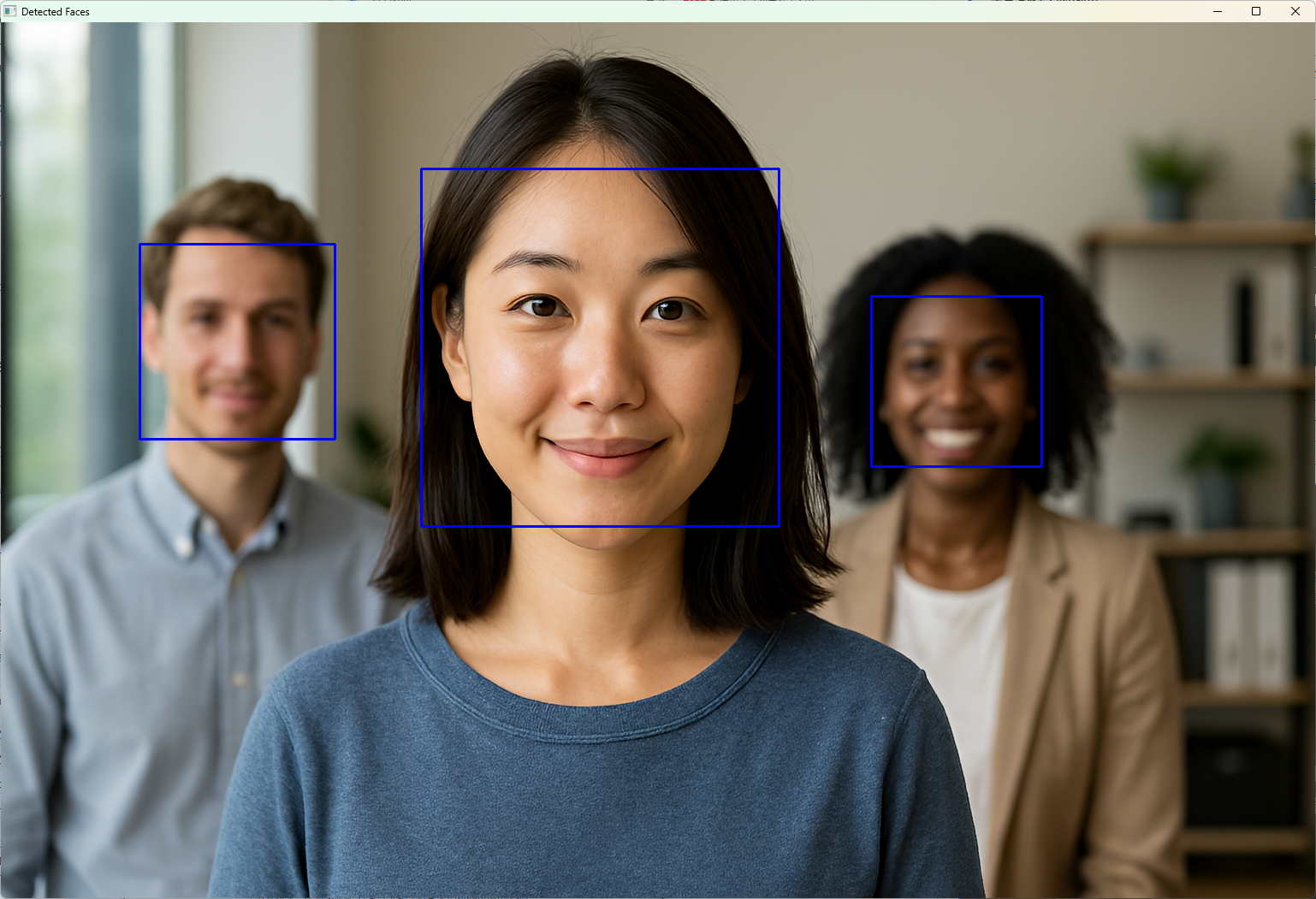

cv::imshow("Detected Faces", image);

cv::waitKey(0);

return 0;

}

このコードは、画像から顔を検出し、検出した顔に青い矩形を描画します。

dnn::Net の概要

OpenCVのdnnモジュールは、ディープラーニングモデルを読み込み推論を行うためのAPIです。

顔検出に使う場合は、学習済みの深層学習モデル(Caffe、TensorFlow、ONNXなど)を読み込み、画像から顔を検出します。

主な特徴は以下の通りです。

- 高精度な検出

CNNベースのモデルを使うため、複雑な顔のパターンや角度変化に強いです。

- 多様なモデル対応

Caffe、TensorFlow、Darknet、ONNXなど様々なフレームワークのモデルを読み込めます。

- 柔軟な推論設定

入力サイズやスケール、前処理を細かく設定可能です。

- GPU対応

CUDAやOpenCLを利用して高速化できます。

以下は、Caffeモデルを使った顔検出の簡単な例です。

#include <opencv2/opencv.hpp>

#include <opencv2/dnn.hpp>

#include <iostream>

int main() {

// モデルとプロトテキストのパス

std::string modelFile = "res10_300x300_ssd_iter_140000_fp16.caffemodel";

std::string configFile = "deploy.prototxt";

// ネットワークの読み込み

cv::dnn::Net net = cv::dnn::readNetFromCaffe(configFile, modelFile);

if (net.empty()) {

std::cerr << "モデルの読み込みに失敗しました\n";

return -1;

}

cv::Mat image = cv::imread("face.jpg");

if (image.empty()) {

std::cerr << "画像の読み込みに失敗しました\n";

return -1;

}

// 入力画像の前処理

cv::Mat blob = cv::dnn::blobFromImage(image, 1.0, cv::Size(300, 300),

cv::Scalar(104.0, 177.0, 123.0), false, false);

net.setInput(blob);

cv::Mat detection = net.forward();

// 検出結果の解析

cv::Mat detectionMat(detection.size[2], detection.size[3], CV_32F, detection.ptr<float>());

float confidenceThreshold = 0.5;

for (int i = 0; i < detectionMat.rows; i++) {

float confidence = detectionMat.at<float>(i, 2);

if (confidence > confidenceThreshold) {

int x1 = static_cast<int>(detectionMat.at<float>(i, 3) * image.cols);

int y1 = static_cast<int>(detectionMat.at<float>(i, 4) * image.rows);

int x2 = static_cast<int>(detectionMat.at<float>(i, 5) * image.cols);

int y2 = static_cast<int>(detectionMat.at<float>(i, 6) * image.rows);

cv::rectangle(image, cv::Point(x1, y1), cv::Point(x2, y2),

cv::Scalar(0, 255, 0), 2);

cv::putText(image, cv::format("Confidence: %.2f", confidence),

cv::Point(x1, y1 - 5), cv::FONT_HERSHEY_SIMPLEX, 0.5,

cv::Scalar(0, 255, 0), 1);

}

}

cv::imshow("DNN Face Detection", image);

cv::waitKey(0);

return 0;

}このコードは、CaffeのSSDモデルを使って画像中の顔を検出し、信頼度とともに緑色の矩形を描画します。

dnn::Netを使うことで、より高精度な顔検出が可能になります。

Haarカスケード分類器の仕組み

Haar特徴の算出

積分画像 (Integral Image)

Haar特徴の計算を高速化するために積分画像が使われます。

積分画像とは、ある画素位置までの輝度値の総和を格納した画像のことです。

これにより、任意の矩形領域の輝度和を定数時間で計算できます。

具体的には、積分画像 \( II(x, y) \) は元画像 \( I(x, y) \) に対して以下のように定義されます。

\[II(x, y) = \sum_{x’ \leq x, y’ \leq y} I(x’, y’)\]

この定義により、矩形領域 \( R \) の輝度和は4つの積分画像の値の差分で求められます。

\[\text{Sum}(R) = II(x_2, y_2) – II(x_1, y_2) – II(x_2, y_1) + II(x_1, y_1)\]

ここで、\( (x_1, y_1) \) と \( (x_2, y_2) \) は矩形領域の左上と右下の座標です。

この仕組みにより、Haar特徴の計算が非常に高速になり、リアルタイム処理が可能になります。

特徴テンプレートの種類

Haar特徴は、白黒の矩形領域の輝度差を利用して顔の特徴を表現します。

主に以下の5種類のテンプレートが使われています。

| 特徴タイプ | 説明 |

|---|---|

| 2矩形特徴 (Two-rectangle feature) | 隣接する2つの矩形領域の輝度差を計算。例えば、目の周囲の明暗差を捉えます。 |

| 3矩形特徴 (Three-rectangle feature) | 3つの矩形領域を使い、中央の矩形と両端の矩形の輝度差を計算。鼻梁の特徴などに有効。 |

| 4矩形特徴 (Four-rectangle feature) | 4つの矩形領域の輝度差を組み合わせて、より複雑なパターンを表現。 |

| エッジ特徴 | 2矩形特徴の一種で、エッジの検出に使われます。 |

| ライン特徴 | 3矩形特徴の一種で、線状のパターンを検出。 |

これらの特徴は、顔の目、鼻、口などのパーツの明暗パターンを効率的に捉えられます。

AdaBoostによる学習プロセス

AdaBoostは、多数の弱い分類器を組み合わせて強力な分類器を作る機械学習アルゴリズムです。

Haar特徴を用いた顔検出では、各特徴を使った単純な分類器(弱分類器)を多数作成し、AdaBoostで重み付けして最終的な強分類器を構築します。

学習の流れは以下の通りです。

- 初期重みの設定

正例(顔画像)と負例(非顔画像)に均等に重みを割り当てます。

- 弱分類器の学習

各Haar特徴に対して単純なしきい値分類器を作成し、誤分類率を計算します。

- 最良の弱分類器選択

最も誤分類率が低い弱分類器を選び、その重みを計算します。

- 重みの更新

誤分類されたサンプルの重みを増やし、次の弱分類器が誤分類しやすいサンプルに注目するようにします。

- 繰り返し

2~4のステップを繰り返し、多数の弱分類器を組み合わせます。

この過程で、顔検出に有効な特徴が自動的に選ばれ、強力な分類器が完成します。

カスケード構造の多段判定

カスケード分類器は、複数の段階(ステージ)からなる分類器を順に適用し、顔でない領域を早期に除外する仕組みです。

これにより、計算コストを大幅に削減しつつ高い検出率を維持します。

- 初期段階

簡単な特徴で顔でない領域を素早く除外します。

多くの領域がここで弾かれます。

- 中間段階

より複雑な特徴を使い、顔の可能性が高い領域をさらに絞り込みます。

- 最終段階

最も精度の高い分類器で最終判定を行います。

この多段判定により、全ての領域に高コストな処理を行う必要がなくなり、リアルタイム処理が可能になります。

OpenCV標準カスケードのバリエーション

OpenCVには、用途に応じた複数の学習済みカスケード分類器が用意されています。

代表的なものを紹介します。

haarcascade_frontalface_default.xml

正面顔検出用の標準的なカスケード分類器です。

多くのシナリオで使われており、顔の正面を検出するのに適しています。

検出精度と速度のバランスが良く、初心者にも扱いやすいモデルです。

haarcascade_profileface.xml

横顔(プロファイル)検出用の分類器です。

顔が横を向いている場合に有効で、正面顔検出器と組み合わせて使うことが多いです。

横顔の特徴を捉えるために特化した特徴セットが学習されています。

その他のプリセット

| ファイル名 | 用途 |

|---|---|

haarcascade_eye.xml | 目の検出 |

haarcascade_smile.xml | 笑顔の検出 |

haarcascade_upperbody.xml | 上半身の検出 |

haarcascade_frontalface_alt.xml | 正面顔の別バージョン |

haarcascade_frontalface_alt2.xml | 正面顔の別バージョン |

これらのプリセットは、顔検出以外にも顔のパーツ検出や人体検出に利用でき、用途に応じて使い分けることが可能です。

Deep Neural Network による顔検出

SSD + Caffeモデル

SSD(Single Shot MultiBox Detector)は、物体検出に広く使われる高速かつ高精度なディープラーニングモデルです。

顔検出にも応用されており、OpenCVのdnnモジュールでCaffe形式の学習済みモデルを利用できます。

SSDは画像を一度だけ畳み込み処理し、複数のスケールで物体の位置とクラスを同時に予測します。

これにより、リアルタイム処理が可能な速度を実現しています。

OpenCVで使われる代表的な顔検出用SSDモデルは、res10_300x300_ssd_iter_140000_fp16.caffemodelです。

これは300×300ピクセルの入力画像を前提とし、顔の位置を矩形で検出します。

SSD + Caffeモデルの特徴は以下の通りです。

- 高速推論:単一のネットワークパスで検出を完了するため、リアルタイム処理に適しています

- 高精度:顔の位置を正確に検出し、誤検出が少ないです

- 簡単な前処理:画像を300×300にリサイズし、平均値を引くだけで利用可能です

以下はSSD + Caffeモデルを使った顔検出の基本的な流れです。

- 画像を300×300にリサイズし、平均値(104, 177, 123)を引いてBlobを作成。

readNetFromCaffeでモデルと構成ファイルを読み込みです。- Blobをネットワークに入力し、推論を実行。

- 出力から検出結果を取得し、信頼度が閾値以上の顔を矩形で描画。

このモデルは、顔検出の精度と速度のバランスが良く、多くのリアルタイムアプリケーションで利用されています。

ResNetバックボーン

ResNet(Residual Network)は、深いニューラルネットワークの学習を容易にするために残差学習を導入したモデルです。

顔検出のバックボーンとして使われることで、より深い層で複雑な特徴を抽出し、高精度な検出を実現します。

ResNetバックボーンを持つ顔検出モデルは、SSDやFaster R-CNNなどの検出フレームワークに組み込まれています。

ResNetの特徴は以下の通りです。

- 深いネットワーク構造:50層以上の深さを持つモデルが一般的で、複雑な顔のパターンを捉えやすい

- 残差接続:層の出力に入力を足し合わせることで勾配消失問題を軽減し、学習を安定化

- 高い検出精度:特に難しい角度や部分的な顔でも検出性能が向上

OpenCVのdnnモジュールでは、ResNetをバックボーンに持つCaffeやONNXモデルを読み込んで利用可能です。

ただし、ResNetベースのモデルは計算量が多いため、SSD + Caffeモデルより推論速度は遅くなる傾向があります。

軽量モデル MobileNet

MobileNetは、モバイルや組み込み機器向けに設計された軽量なCNNモデルです。

顔検出においても、MobileNetをバックボーンにしたSSDモデルがよく使われています。

MobileNetの特徴は以下の通りです。

- 深さ方向の畳み込み(Depthwise Separable Convolution)を採用し、パラメータ数と計算量を大幅に削減

- 高速推論が可能で、リソースが限られた環境でも動作しやすい

- 精度と速度のバランスが良く、リアルタイム顔検出に適しています

OpenCVでは、MobileNet-SSDモデルのCaffeやTensorFlow版を読み込んで利用できます。

特に、deploy.prototxtとmobilenet_iter_73000.caffemodelの組み合わせが有名です。

MobileNetベースの顔検出は、スマートフォンやIoTデバイスなど、計算リソースが限られる環境での利用に向いています。

ONNX形式モデルの導入

ONNX(Open Neural Network Exchange)は、異なるディープラーニングフレームワーク間でモデルを共有するためのオープンフォーマットです。

OpenCVのdnnモジュールはONNX形式のモデルを直接読み込んで推論できます。

ONNX形式モデルの利点は以下の通りです。

- フレームワーク非依存:PyTorch、TensorFlow、Caffeなど様々なフレームワークで学習したモデルをONNXに変換し、OpenCVで利用可能です

- 最新モデルの活用:最新の顔検出モデルやカスタムモデルをONNX形式で取り込みやすい

- 柔軟な前処理・後処理:OpenCVのAPIで前処理や後処理を自由に組み合わせられます

ONNXモデルを使う場合は、モデルの入力サイズや前処理(リサイズ、正規化、色空間変換など)を正確に合わせる必要があります。

また、推論結果のフォーマットもモデルによって異なるため、出力の解釈に注意が必要です。

ONNXモデルの読み込み例は以下の通りです。

cv::dnn::Net net = cv::dnn::readNetFromONNX("face_detection.onnx");ONNX形式の顔検出モデルは、最新の研究成果を取り入れやすく、カスタムモデルの導入や環境に応じた最適化がしやすい点が魅力です。

フレーム入力と前処理

cv::VideoCapture でのカメラ接続

OpenCVでリアルタイムの顔認識を行う際、まずはカメラから映像を取得する必要があります。

cv::VideoCaptureクラスを使うと、PCに接続されたカメラや動画ファイルからフレームを簡単に読み込めます。

カメラ接続の基本的な使い方は以下の通りです。

#include <opencv2/opencv.hpp>

#include <iostream>

int main() {

// デフォルトカメラ(通常は0番)を開く

cv::VideoCapture cap(0);

if (!cap.isOpened()) {

std::cerr << "カメラを開けませんでした\n";

return -1;

}

cv::Mat frame;

while (true) {

// フレームを取得

cap >> frame;

if (frame.empty()) {

std::cerr << "フレームの取得に失敗しました\n";

break;

}

// 取得したフレームを表示

cv::imshow("Camera Frame", frame);

// 'q'キーで終了

if (cv::waitKey(1) == 'q') {

break;

}

}

return 0;

}このコードでは、VideoCaptureオブジェクトcapを作成し、cap.isOpened()でカメラが正常に開けたかを確認しています。

cap >> frameで1フレームずつ取得し、imshowで表示しています。

waitKey(1)は1ミリ秒待機し、キー入力を受け付けます。

カメラ番号は複数台接続されている場合に変わるため、環境に応じて調整してください。

カラースペース変換

顔検出アルゴリズムは、入力画像のカラースペースに依存することが多いです。

特にHaarカスケード分類器はグレースケール画像を前提としているため、カラー画像(OpenCVのデフォルトはBGR)から適切に変換する必要があります。

BGR → GRAY

OpenCVの画像はデフォルトでBGR形式ですが、顔検出の多くは輝度情報のみを使うため、グレースケール画像に変換します。

cv::cvtColor関数を使い、以下のように変換します。

cv::Mat gray;

cv::cvtColor(frame, gray, cv::COLOR_BGR2GRAY);グレースケール変換により、計算量が減り、顔検出の速度が向上します。

また、照明の影響を受けにくくなるメリットもあります。

BGR → RGB

一方、DNNモデルの多くはRGB形式の画像を入力とするため、BGRからRGBへの変換が必要です。

これもcv::cvtColorで簡単に行えます。

cv::Mat rgb;

cv::cvtColor(frame, rgb, cv::COLOR_BGR2RGB);DNNの前処理でblobFromImageを使う際に、swapRBパラメータをtrueに設定することで自動的にBGR→RGB変換を行うことも可能です。

リサイズとアスペクト比保持

顔検出モデルは入力画像のサイズに制約がある場合が多く、特にDNNモデルは固定サイズの入力を要求します。

そのため、フレームをリサイズする必要がありますが、アスペクト比を保持しないと顔の形状が歪み、検出精度が落ちることがあります。

アスペクト比を保持しつつリサイズする方法は以下の通りです。

cv::Mat resized;

int targetWidth = 300;

int targetHeight = 300;

double aspectRatio = static_cast<double>(frame.cols) / frame.rows;

int newWidth, newHeight;

if (aspectRatio > 1.0) {

newWidth = targetWidth;

newHeight = static_cast<int>(targetWidth / aspectRatio);

} else {

newHeight = targetHeight;

newWidth = static_cast<int>(targetHeight * aspectRatio);

}

cv::resize(frame, resized, cv::Size(newWidth, newHeight));

// 必要に応じてパディングを追加し、targetWidth x targetHeightに合わせることも可能この方法でリサイズすると、元画像の縦横比を保ったまま指定サイズに近づけられます。

DNNモデルの入力に合わせてパディング(黒い余白)を加えることもあります。

ヒストグラム平坦化

ヒストグラム平坦化(ヒストグラム均一化)は、画像のコントラストを強調し、照明条件の違いによる影響を軽減する前処理です。

特にグレースケール画像に対して効果的で、Haarカスケード分類器の検出精度向上に寄与します。

OpenCVではcv::equalizeHist関数で簡単に実装できます。

cv::Mat gray, equalized;

cv::cvtColor(frame, gray, cv::COLOR_BGR2GRAY);

cv::equalizeHist(gray, equalized);ヒストグラム平坦化を行うことで、暗い部分や明るい部分のコントラストが均一化され、顔の特徴がより明瞭になります。

ただし、過度に適用するとノイズが強調される場合もあるため、適用の有無は検証が必要です。

顔検出コードの実装ポイント

Haarカスケード呼び出し

OpenCVのCascadeClassifierを使った顔検出では、detectMultiScale関数が中心的な役割を果たします。

この関数は画像中の顔候補領域を矩形で返しますが、パラメータの設定によって検出精度や速度が大きく変わります。

ここでは主要なパラメータについて詳しく解説します。

detectMultiScale パラメータ

detectMultiScaleの主な引数は以下の通りです。

image:入力画像(通常はグレースケール画像)objects:検出結果の矩形を格納するstd::vector<cv::Rect>の参照scaleFactor:画像サイズを縮小する倍率(詳細は後述)minNeighbors:矩形の近接数の閾値(詳細は後述)flags:検出の動作を制御するフラグ(詳細は後述)minSize:検出する最小物体サイズmaxSize:検出する最大物体サイズ

これらのパラメータを適切に調整することで、誤検出の減少や検出速度の向上が期待できます。

scaleFactor

scaleFactorは、画像を何倍ずつ縮小しながら顔検出を行うかを指定します。

例えば、1.1を指定すると、画像サイズを10%ずつ縮小しながら検出を繰り返します。

このパラメータの役割は、異なるサイズの顔を検出するために画像をピラミッド状に縮小し、スケールの異なる顔を検出することです。

- 小さい値(例:1.05)にすると、スケールの刻みが細かくなり検出精度が上がりますが、処理時間が長くなります

- 大きい値(例:1.4)にすると、処理は速くなりますが、小さな顔を見逃す可能性があります

適切な値は検出対象の顔サイズや処理速度の要件に依存します。

minNeighbors

minNeighborsは、検出された矩形の近接数の閾値です。

顔検出は複数の矩形が重なって検出されることが多いため、近接する矩形の数がこの値以上であれば顔と判定します。

- 値を大きくすると、誤検出が減り精度が上がりますが、検出漏れが増える可能性があります

- 値を小さくすると、検出数が増えますが誤検出も増えやすくなります

一般的には3~6の範囲で調整します。

flags

flagsは検出の動作を制御するためのフラグですが、OpenCVの最新バージョンではほとんど使われず、通常は0を指定します。

過去のバージョンではCASCADE_SCALE_IMAGEなどが使われていましたが、現在はデフォルト動作で問題ありません。

minSize と maxSize

minSizeとmaxSizeは、検出対象の最小・最大サイズを指定します。

これにより、極端に小さいまたは大きい顔の検出を制限できます。

minSizeを設定することで、小さなノイズや遠景の顔を除外し、誤検出を減らせますmaxSizeは大きな物体を除外したい場合に設定しますが、通常は指定しないことが多いです

例えば、30×30ピクセル以上の顔のみ検出したい場合はcv::Size(30, 30)を指定します。

DNN推論フロー

OpenCVのdnnモジュールを使った顔検出は、ディープラーニングモデルの読み込みから推論、後処理までの一連の流れを理解することが重要です。

ここでは代表的な処理手順を解説します。

入力Blob生成

DNNモデルは固定サイズの入力を要求することが多く、画像を適切に前処理してBlob(4次元テンソル)に変換します。

OpenCVのblobFromImage関数を使うと簡単に生成できます。

主なパラメータは以下の通りです。

scalefactor:画像のスケール係数(例:1/255で正規化)size:入力サイズ(例:300×300)mean:平均値の差し引き(例:cv::Scalar(104.0, 177.0, 123.0))swapRB:BGRとRGBのチャンネル入れ替え(モデルにより必要)crop:リサイズ時のクロップ有無

cv::Mat blob = cv::dnn::blobFromImage(image, 1.0, cv::Size(300, 300),

cv::Scalar(104.0, 177.0, 123.0), false, false);このBlobをネットワークに入力します。

ネットワーク読み込み

モデルの読み込みは、フレームワークに応じて以下の関数を使います。

- Caffeモデル:

cv::dnn::readNetFromCaffe(prototxt, caffemodel) - TensorFlowモデル:

cv::dnn::readNetFromTensorflow(pb, pbtxt) - ONNXモデル:

cv::dnn::readNetFromONNX(onnxfile)

読み込み後、net.setInput(blob)で入力をセットします。

推論と後処理 (NMS)

net.forward()で推論を実行し、出力を取得します。

出力は検出された顔の位置や信頼度を含む多次元配列です。

推論結果から顔の矩形を抽出し、信頼度が閾値以上のものを選びます。

複数の重複検出を減らすために、Non-Maximum Suppression(NMS)を適用することが一般的です。

NMSは、重なりの大きい検出結果のうち、信頼度が最も高いものだけを残す処理です。

OpenCVにはcv::dnn::NMSBoxes関数が用意されています。

NMSの例:

std::vector<cv::Rect> boxes; // 検出矩形

std::vector<float> confidences; // 信頼度

float confThreshold = 0.5f;

float nmsThreshold = 0.4f;

std::vector<int> indices;

cv::dnn::NMSBoxes(boxes, confidences, confThreshold, nmsThreshold, indices);

for (int idx : indices) {

cv::rectangle(image, boxes[idx], cv::Scalar(0, 255, 0), 2);

}このようにして、重複を抑えつつ信頼度の高い顔検出結果を得られます。

複数顔のハンドリング

最大検出数の制御

リアルタイムの顔検出では、画像や映像内に複数の顔が映り込むことが多くあります。

検出結果が多数になると、処理負荷が増大したり、表示が煩雑になったりするため、最大検出数を制御することが重要です。

OpenCVのdetectMultiScaleやDNN推論の結果から得られる顔矩形は、検出数が多い場合に上位の信頼度順でソートし、必要に応じて上限を設けて制限します。

例えば、DNN推論後に信頼度の高い顔を最大5つまで表示したい場合は、以下のように実装します。

int maxFaces = 5;

std::vector<int> indices; // NMS後のインデックス

// indicesは信頼度順にソートされていると仮定

if (indices.size() > maxFaces) {

indices.resize(maxFaces);

}

for (int idx : indices) {

cv::rectangle(image, boxes[idx], cv::Scalar(0, 255, 0), 2);

}このように最大検出数を制御することで、処理負荷の安定化やUIの見やすさを保てます。

オーバーラップ閾値設定

複数の顔検出結果が重複して検出されることがあります。

これを抑制するためにNon-Maximum Suppression(NMS)が使われますが、NMSの動作はオーバーラップの閾値(IoU: Intersection over Union)によって制御されます。

IoUは2つの矩形の重なり度合いを示し、以下の式で計算されます。

\[IoU = \frac{Area(B_1 \cap B_2)}{Area(B_1 \cup B_2)}\]

NMSでは、IoUが設定した閾値以上の矩形のうち、信頼度が低いものを除外します。

- 閾値を低く設定すると、重複検出が厳しく排除され、検出数が減りますが、近接した複数の顔が誤って統合される可能性があります

- 閾値を高く設定すると、重複検出が許容されやすくなり、誤検出が増えることがあります

OpenCVのcv::dnn::NMSBoxes関数では、以下のようにIoU閾値を指定します。

float nmsThreshold = 0.4f; // IoUの閾値

cv::dnn::NMSBoxes(boxes, confidences, confThreshold, nmsThreshold, indices);適切な閾値はシーンや検出モデルによって異なるため、実際の使用環境で調整が必要です。

部分顔の扱い方

部分顔とは、顔の一部が隠れていたり、フレームの端にかかっていたりする状態の顔を指します。

部分顔は検出が難しく、誤検出や検出漏れの原因となります。

部分顔の扱い方には以下のポイントがあります。

- 検出モデルの選択

Haarカスケード分類器は部分顔に弱い傾向がありますが、DNNベースのモデルは部分顔の検出性能が高い場合があります。

用途に応じてモデルを使い分けることが重要です。

- 検出矩形のサイズ制限

minSizeパラメータを設定し、小さすぎる顔(部分顔を含む)を除外することで誤検出を減らせます。

ただし、部分顔を検出したい場合はこの制限を緩める必要があります。

- 後処理でのフィルタリング

部分顔は矩形のアスペクト比や信頼度が低いことが多いため、これらの条件でフィルタリングする方法があります。

- 複数モデルの併用

正面顔検出器と横顔検出器を組み合わせることで、部分的に見える顔も検出しやすくなります。

- トラッキングとの組み合わせ

動画の場合、顔検出とトラッキングを組み合わせることで、一度検出した顔の部分的な遮蔽やフレーム外への一時的な移動を補完できます。

部分顔の検出は難易度が高いため、誤検出を許容するか、検出漏れを防ぐかのトレードオフを考慮しながら調整することが求められます。

パフォーマンス最適化

GPUバックエンド選択

OpenCVのdnnモジュールはCPUだけでなく、GPUを活用して推論速度を大幅に向上させることが可能です。

GPUを使うには、CUDAやOpenCLといったバックエンドを選択します。

これにより、特にリアルタイム処理でのパフォーマンス改善が期待できます。

CUDA

CUDAはNVIDIA製GPU向けの並列計算プラットフォームで、OpenCVはCUDA対応のdnnバックエンドを提供しています。

CUDAを利用するには、対応するNVIDIA GPUとCUDA Toolkitのインストールが必要です。

CUDAバックエンドの有効化は以下のように行います。

cv::dnn::Net net = cv::dnn::readNetFromCaffe(prototxt, caffemodel);

net.setPreferableBackend(cv::dnn::DNN_BACKEND_CUDA);

net.setPreferableTarget(cv::dnn::DNN_TARGET_CUDA);この設定により、推論処理がGPU上で実行され、CPUのみの場合と比べて数倍から十数倍の高速化が見込めます。

注意点として、CUDA対応はOpenCVをCUDAサポート付きでビルドしている必要があり、環境構築がやや複雑です。

また、GPUメモリの制約やドライバの互換性にも注意が必要です。

OpenCL

OpenCLは異なるベンダーのGPUやCPUで動作する汎用並列計算フレームワークです。

OpenCVはOpenCLを利用したoclモジュールを持ち、dnnモジュールでもOpenCLをバックエンドとして利用可能です。

OpenCLバックエンドの設定例は以下の通りです。

cv::dnn::Net net = cv::dnn::readNetFromCaffe(prototxt, caffemodel);

net.setPreferableBackend(cv::dnn::DNN_BACKEND_DEFAULT);

net.setPreferableTarget(cv::dnn::DNN_TARGET_OPENCL);OpenCLはNVIDIA以外のGPU(AMDやIntel)でも利用できるため、環境に応じて選択肢となります。

ただし、CUDAに比べて最適化度合いが低い場合があり、性能は環境依存です。

並列化とスレッド設定

OpenCVは内部でマルチスレッド処理をサポートしており、CPUの複数コアを活用して処理を高速化できます。

特に画像処理や顔検出の前処理・後処理で並列化を活用すると効果的です。

TBBによる parallel_for

IntelのThreading Building Blocks(TBB)は、OpenCVが対応している並列化ライブラリの一つです。

parallel_forを使うことで、ループ処理を複数スレッドで分割して実行できます。

例えば、複数の顔検出結果に対して矩形描画を並列化する例を示します。

#include <opencv2/opencv.hpp>

#include <tbb/parallel_for.h>

void drawRectangles(cv::Mat& image, const std::vector<cv::Rect>& faces) {

tbb::parallel_for(size_t(0), faces.size(), [&](size_t i) {

cv::rectangle(image, faces[i], cv::Scalar(255, 0, 0), 2);

});

}このように、顔検出後の描画処理や画像の前処理を並列化することで、CPUリソースを最大限に活用し、処理時間を短縮できます。

OpenCV自体もTBBやOpenMPを内部で利用しているため、環境によっては自動的に並列化されますが、明示的にparallel_forを使うことで細かい制御が可能です。

バッチ推論による高速化

DNNモデルの推論は通常1枚の画像(フレーム)に対して行いますが、複数の画像をまとめてバッチ処理することでGPUの並列計算能力を最大限に活用し、スループットを向上させることができます。

OpenCVのdnnモジュールでは、複数画像を1つの4次元Blobにまとめて入力し、一括で推論を行うことが可能です。

バッチ推論の例:

std::vector<cv::Mat> images; // 複数の画像を格納

std::vector<cv::Mat> blobs;

for (const auto& img : images) {

blobs.push_back(cv::dnn::blobFromImage(img, 1.0, cv::Size(300, 300),

cv::Scalar(104.0, 177.0, 123.0), false, false));

}

// 複数のBlobを縦に連結して1つのバッチBlobを作成

cv::Mat batchBlob;

cv::dnn::blobFromImages(images, batchBlob, 1.0, cv::Size(300, 300),

cv::Scalar(104.0, 177.0, 123.0), false, false);

net.setInput(batchBlob);

cv::Mat output = net.forward();バッチ推論のメリットは、GPUの計算資源を効率的に使い、1枚あたりの推論時間を短縮できる点です。

ただし、リアルタイム処理では遅延が増える可能性があるため、用途に応じてバッチサイズを調整してください。

また、バッチ推論を行う場合は、後処理で各画像ごとの検出結果を分割して扱う必要があります。

これらのパフォーマンス最適化手法を組み合わせることで、リアルタイム顔認識の処理速度を大幅に向上させることが可能です。

精度向上テクニック

前処理のデノイズ

顔検出の精度を高めるためには、入力画像の品質を向上させることが重要です。

特にノイズが多い画像は誤検出や検出漏れの原因となるため、前処理でデノイズを行うことが効果的です。

OpenCVでは様々なデノイズ手法が利用可能ですが、代表的なものを紹介します。

- GaussianBlur(ガウシアンぼかし)

ガウシアンカーネルを使って画像を平滑化し、高周波ノイズを除去します。

顔の輪郭や特徴を大きく損なわずにノイズを抑えられます。

cv::Mat denoised;

cv::GaussianBlur(grayImage, denoised, cv::Size(5, 5), 1.5);- MedianBlur(メディアンフィルタ)

各画素を周囲の中央値に置き換えることで、塩胡椒ノイズに強い効果を発揮します。

顔検出前のノイズ除去に適しています。

cv::Mat denoised;

cv::medianBlur(grayImage, denoised, 3);- Non-local Means Denoising(非局所的平均法)

より高度なノイズ除去手法で、画像の類似パッチを利用してノイズを抑えます。

cv::fastNlMeansDenoising関数で利用可能です。

cv::Mat denoised;

cv::fastNlMeansDenoising(grayImage, denoised, 30, 7, 21);これらのデノイズ処理を顔検出前に適用することで、ノイズによる誤検出を減らし、検出精度の向上が期待できます。

ただし、過度な平滑化は顔の特徴をぼかしてしまうため、パラメータ調整が重要です。

データ拡張による汎化性能向上

顔検出モデルの学習時にデータ拡張を行うことで、様々な環境や条件に対応できる汎化性能を高められます。

データ拡張は、元の学習データに対して人工的に変換を加え、多様なサンプルを生成する手法です。

代表的なデータ拡張手法は以下の通りです。

- 回転・反転

顔の向きを変えることで、斜めや横向きの顔にも対応しやすくなります。

- スケーリング・トリミング

顔の大きさや位置を変化させ、様々な距離やフレーム内の位置に対応します。

- 明るさ・コントラスト変化

照明条件の違いを模擬し、暗い環境や逆光でも検出できるようにします。

- ノイズ付加

実際の撮影環境で発生するノイズを模倣し、ロバスト性を向上させます。

- 色空間変換

色の変化を加え、カメラや環境による色味の違いに対応します。

これらの拡張は、学習データの多様性を増やし、過学習を防ぐ効果もあります。

深層学習フレームワークでは、リアルタイムにデータ拡張を行うライブラリや関数が用意されていることが多いです。

ハードネガティブマイニング

ハードネガティブマイニング(Hard Negative Mining)は、顔検出モデルの学習において誤検出しやすい難しい負例(ネガティブサンプル)を重点的に学習させる手法です。

これにより、誤検出率を大幅に低減し、モデルの精度を向上させます。

具体的な流れは以下の通りです。

- 初期モデルの学習

通常の正例(顔)と負例(非顔)でモデルを学習します。

- 誤検出の収集

学習済みモデルを使って大量の負例画像を推論し、誤って顔と判定された領域(ハードネガティブ)を抽出します。

- ハードネガティブの追加学習

抽出したハードネガティブを負例データセットに加え、モデルを再学習します。

- 繰り返し

2~3のステップを繰り返し、誤検出を減らしていきます。

この手法は、特に背景や物体の一部が顔に似ている場合の誤検出を減らすのに効果的です。

Haarカスケード分類器の学習でも広く使われており、ディープラーニングモデルの学習でも応用されています。

ハードネガティブマイニングを実装する際は、誤検出の収集と再学習のサイクルを自動化すると効率的です。

これにより、モデルの精度を段階的に改善できます。

表示とUI実装

cv::rectangle でのバウンディングボックス描画

顔検出の結果をユーザーにわかりやすく伝えるためには、検出した顔の位置にバウンディングボックス(矩形)を描画するのが一般的です。

OpenCVではcv::rectangle関数を使って簡単に矩形を描画できます。

cv::rectangleの基本的な使い方は以下の通りです。

#include <opencv2/opencv.hpp>

int main() {

cv::Mat image = cv::imread("face.jpg");

if (image.empty()) return -1;

// 顔の検出結果(例として固定の矩形)

cv::Rect faceRect(100, 100, 150, 150);

// 矩形を描画(青色、線の太さ2)

cv::rectangle(image, faceRect, cv::Scalar(255, 0, 0), 2);

cv::imshow("Face Detection", image);

cv::waitKey(0);

return 0;

}- 第1引数:描画対象の画像

- 第2引数:矩形の位置とサイズを表す

cv::Rect - 第3引数:色(BGR形式、ここでは青色)

- 第4引数:線の太さ(ピクセル単位)

複数の顔を検出した場合は、検出結果の矩形をループで回して順に描画します。

for (const auto& face : faces) {

cv::rectangle(image, face, cv::Scalar(255, 0, 0), 2);

}このようにして、リアルタイム映像や静止画に顔の位置を視覚的に示せます。

ラベルと信頼度スコア表示

顔検出の結果に加えて、検出した顔のラベルや信頼度スコアを表示すると、ユーザーに検出の確かさを伝えられます。

OpenCVのcv::putText関数を使ってテキストを描画します。

以下は信頼度スコアを矩形の上に表示する例です。

for (size_t i = 0; i < faces.size(); ++i) {

cv::rectangle(image, faces[i], cv::Scalar(255, 0, 0), 2);

// 信頼度(例として0.85を表示)

float confidence = 0.85f;

std::string label = cv::format("Conf: %.2f", confidence);

int baseLine = 0;

cv::Size labelSize = cv::getTextSize(label, cv::FONT_HERSHEY_SIMPLEX, 0.5, 1, &baseLine);

// ラベルの背景矩形

cv::rectangle(image,

cv::Point(faces[i].x, faces[i].y - labelSize.height - baseLine),

cv::Point(faces[i].x + labelSize.width, faces[i].y),

cv::Scalar(255, 0, 0), cv::FILLED);

// ラベルテキスト描画(白色)

cv::putText(image, label,

cv::Point(faces[i].x, faces[i].y - baseLine),

cv::FONT_HERSHEY_SIMPLEX, 0.5, cv::Scalar(255, 255, 255), 1);

}ポイントは以下の通りです。

cv::getTextSizeでテキストのサイズを取得し、背景矩形のサイズを決定- 背景矩形を描画してテキストの視認性を高める

- テキストは矩形の上部に配置し、顔の矩形と重ならないようにします

この方法で、検出結果の信頼度やラベルをわかりやすく表示できます。

FPSメーターの作成

リアルタイム顔認識では、処理速度の指標としてFPS(Frames Per Second)を表示することが多いです。

FPSは1秒間に処理できるフレーム数を示し、ユーザーに処理の快適さを伝えます。

FPSメーターの実装例を示します。

#include <opencv2/opencv.hpp>

#include <chrono>

#include <string>

int main() {

cv::VideoCapture cap(0);

if (!cap.isOpened()) return -1;

cv::Mat frame;

auto start = std::chrono::steady_clock::now();

int frameCount = 0;

double fps = 0.0;

while (true) {

cap >> frame;

if (frame.empty()) break;

frameCount++;

// 1秒ごとにFPSを計算

auto now = std::chrono::steady_clock::now();

double elapsed = std::chrono::duration_cast<std::chrono::milliseconds>(now - start).count();

if (elapsed >= 1000) {

fps = frameCount * 1000.0 / elapsed;

start = now;

frameCount = 0;

}

// FPS表示

std::string fpsLabel = cv::format("FPS: %.2f", fps);

cv::putText(frame, fpsLabel, cv::Point(10, 30), cv::FONT_HERSHEY_SIMPLEX,

1.0, cv::Scalar(0, 255, 0), 2);

cv::imshow("Camera with FPS", frame);

if (cv::waitKey(1) == 'q') break;

}

return 0;

}このコードのポイントは以下の通りです。

std::chronoで時間を計測し、1秒ごとにフレーム数からFPSを計算cv::putTextで画面左上にFPSを表示- FPSの更新は1秒単位で行い、安定した値を表示

FPSメーターを表示することで、処理速度の変化をリアルタイムに把握でき、パフォーマンスチューニングの指標として役立ちます。

エラー処理とデバッグ

カメラが開かない場合の確認項目

リアルタイム顔認識でカメラが開かない場合、まずは以下のポイントを順に確認してください。

- カメラデバイス番号の確認

cv::VideoCapture cap(0); の 0 は通常デフォルトカメラを指しますが、複数台接続されている場合は番号が変わることがあります。

1や2など他の番号を試してみてください。

- カメラの使用中確認

他のアプリケーションがカメラを占有しているとOpenCVで開けません。

カメラを使っているアプリを終了してください。

- ドライバの状態確認

OSのデバイスマネージャーや設定画面でカメラが正常に認識されているか確認します。

ドライバの再インストールや更新も検討してください。

- アクセス権限の確認

特にWindowsやmacOS、Linuxの一部環境では、アプリケーションにカメラアクセス権限が必要です。

権限設定を見直してください。

- OpenCVのビルド設定

OpenCVがカメラデバイスをサポートするようにビルドされているか確認します。

特にLinuxではV4L2サポートが必要です。

- エラーメッセージの確認

cap.isOpened()がfalseの場合は、エラーメッセージを標準出力に表示し、原因を特定します。

これらを確認しても解決しない場合は、別のカメラやPCで動作確認を行い、ハードウェアの問題かソフトウェアの問題か切り分けることが重要です。

XMLロード失敗時の対処法

Haarカスケード分類器のXMLファイルが読み込めない場合、以下の点をチェックしてください。

- ファイルパスの指定ミス

XMLファイルのパスが正しいか、絶対パスまたは実行ファイルからの相対パスを確認します。

パスが間違っているとload()は失敗します。

- ファイルの存在確認

指定したパスにXMLファイルが存在するか、ファイル名のスペルミスがないかを確認します。

- ファイルの破損

XMLファイルが破損している場合も読み込みに失敗します。

公式のOpenCV配布物から再取得してください。

- 権限の問題

ファイルに読み取り権限があるか確認します。

特にLinuxやmacOSで権限不足が原因になることがあります。

- OpenCVのバージョン互換性

古いXMLファイルが新しいOpenCVで動作しない場合があります。

OpenCVのバージョンに合ったXMLファイルを使いましょう。

- エラーハンドリングの実装

load()の戻り値を必ずチェックし、失敗時にエラーメッセージを表示するコードを入れておくと原因特定が容易です。

if (!face_cascade.load("haarcascade_frontalface_default.xml")) {

std::cerr << "顔分類器のXMLファイルの読み込みに失敗しました\n";

return -1;

}これらの対策で多くのXMLロード失敗問題は解決します。

推論速度低下の原因チェック

DNNを使った顔検出で推論速度が遅い場合、以下のポイントを確認してください。

- バックエンド・ターゲット設定

CPUのみで推論している場合は、GPU(CUDAやOpenCL)を使う設定に切り替えると高速化します。

setPreferableBackendとsetPreferableTargetの設定を見直しましょう。

- 入力画像サイズ

大きな画像をそのまま推論すると処理が重くなります。

モデルの推奨入力サイズにリサイズしているか確認してください。

- バッチサイズ

バッチ推論を行っている場合、バッチサイズが大きすぎるとメモリ不足や遅延が発生します。

適切なサイズに調整しましょう。

- CPUのスレッド数

OpenCVのスレッド数設定が低いとCPUリソースを十分に活用できません。

cv::setNumThreads()でスレッド数を増やすことが可能です。

- 他プロセスの負荷

他の重いプロセスがCPUやGPUを占有していると推論速度が落ちます。

タスクマネージャーやシステムモニターで負荷状況を確認してください。

- モデルの最適化

モデルが大きすぎる場合は、軽量モデル(MobileNetなど)への切り替えや量子化、プルーニングなどの最適化を検討します。

- メモリ不足

GPUメモリやシステムメモリが不足しているとスワップが発生し、速度低下します。

メモリ使用状況を監視しましょう。

- OpenCVのバージョン

古いバージョンのOpenCVは最適化が不十分な場合があります。

最新版へのアップデートも検討してください。

これらのチェックを行い、ボトルネックを特定して対策を講じることで推論速度の改善が期待できます。

カスタムモデルの作成

アノテーションツール選定

カスタム顔検出モデルを作成する際、まずは学習用データセットの準備が必要です。

特に、画像内の顔の位置を正確に示すアノテーション(ラベル付け)が重要です。

アノテーションツールは、効率的かつ正確に矩形やポリゴンで対象物を指定できるものを選びます。

代表的なアノテーションツールは以下の通りです。

- LabelImg

シンプルで使いやすいGUIツール。

矩形バウンディングボックスのアノテーションに特化しており、Pascal VOC形式(XML)やYOLO形式(テキスト)で保存可能です。

Windows、Linux、macOSで動作します。

- LabelMe

Webベースのアノテーションツールで、矩形だけでなく多角形やセグメンテーションも対応。

JSON形式で保存され、柔軟なラベル付けが可能です。

- VoTT (Visual Object Tagging Tool)

Microsoftが提供するクロスプラットフォームのツール。

Azure Blob Storageなどクラウド連携も可能で、大規模データセットの管理に適しています。

- RectLabel (macOS専用)

macOSユーザー向けの有料ツールで、使いやすいUIと多様なフォーマット対応が特徴です。

- MakeSense.ai

ブラウザ上で動作する無料のアノテーションツール。

インストール不要で手軽に利用可能です。

顔検出用のアノテーションでは、矩形バウンディングボックスが一般的です。

ツール選定時は、出力フォーマットが学習フレームワークや変換ツールと互換性があるかを確認してください。

学習スクリプトの概観

アノテーション済みデータを用いて顔検出モデルを学習するには、学習スクリプトを用意します。

一般的にはTensorFlow、PyTorch、Darknetなどのフレームワークを使い、以下の流れで進めます。

- データセットの読み込みと前処理

アノテーションファイルと画像を読み込み、必要に応じてリサイズや正規化、データ拡張を行います。

- モデルの定義

SSD、YOLO、Faster R-CNNなどの物体検出モデルを選択し、顔検出用にカスタマイズします。

バックボーンネットワーク(MobileNet、ResNetなど)も指定します。

- 損失関数と最適化手法の設定

バウンディングボックスの回帰損失やクラス分類損失を組み合わせた損失関数を定義し、AdamやSGDなどの最適化アルゴリズムを設定します。

- 学習ループの実装

ミニバッチ単位でデータをモデルに入力し、損失を計算してパラメータを更新します。

エポックごとに検証データで性能を評価します。

- チェックポイント保存とログ出力

学習途中のモデルを定期的に保存し、TensorBoardなどで学習曲線を可視化します。

- 学習終了後のモデル保存

最終的な学習済みモデルを保存し、推論用に変換します。

学習スクリプトはフレームワークの公式リポジトリやコミュニティで公開されているサンプルをベースにカスタマイズすることが多いです。

例えば、TensorFlow Object Detection APIやPyTorchのDetectron2などが代表例です。

OpenCV互換モデルへの変換

学習済みの顔検出モデルをOpenCVのdnnモジュールで利用するには、対応フォーマットに変換する必要があります。

OpenCVはCaffe、TensorFlow、ONNX、Darknetなど複数のモデル形式をサポートしています。

変換のポイントは以下の通りです。

- TensorFlowモデル

学習後の.ckptファイルやSavedModel形式から、frozen_inference_graph.pbのような推論用のグラフをエクスポートします。

例:TensorFlowのexport_inference_graph.pyスクリプトを使います。

- PyTorchモデル

PyTorchで学習したモデルは、torch.onnx.export関数でONNX形式に変換します。

ONNXはOpenCVでの互換性が高く推奨されます。

- Darknetモデル

YOLO系モデルは.weightsと.cfgファイルのままOpenCVで読み込めます。

- Caffeモデル

.prototxtと.caffemodelファイルをそのまま利用可能です。

- ONNX形式

ONNXは多くのフレームワークからエクスポート可能で、OpenCVのdnnモジュールでの推論に最適です。

変換後は、OpenCVのcv::dnn::readNetFromXXX関数でモデルを読み込み、推論に利用します。

cv::dnn::Net net = cv::dnn::readNetFromONNX("custom_face_detector.onnx");変換時には、モデルの入力サイズや前処理(リサイズ、正規化、色空間変換)をOpenCV側で合わせる必要があります。

また、出力のフォーマットもモデルによって異なるため、推論結果の後処理を適切に実装してください。

これらの手順を踏むことで、独自に学習した高精度な顔検出モデルをOpenCV環境で活用できます。

プライバシーとセキュリティへの配慮

画像保存ポリシー策定

顔認識システムを運用する際、取得した画像や映像データの保存はプライバシー保護の観点から慎重に扱う必要があります。

画像保存ポリシーを明確に策定し、関係者に周知することが重要です。

主なポイントは以下の通りです。

- 保存目的の明確化

画像を保存する目的(例:セキュリティ監視、アクセス管理、研究開発など)を明確にし、必要最低限の範囲に限定します。

- 保存期間の設定

画像データの保存期間を定め、不要になったデータは速やかに削除するルールを設けます。

例えば、法令や社内規定に基づき「最大30日間保存」など具体的に決めます。

- アクセス制限の実施

保存データへのアクセス権限を限定し、関係者以外の閲覧を防止します。

ログ管理や認証システムの導入も推奨されます。

- 暗号化と安全管理

保存時や通信時にデータを暗号化し、不正アクセスや漏洩リスクを低減します。

物理的な保管場所のセキュリティも考慮します。

- 利用者への通知と同意取得

顔認識システムの設置場所では、画像取得・保存の事実を利用者に通知し、必要に応じて同意を得ることが望ましいです。

- 法令遵守

個人情報保護法やGDPRなど、地域の法令に準拠したポリシーを策定します。

これらの方針を文書化し、運用ルールとして徹底することで、プライバシーリスクを最小限に抑えられます。

マスク検出との併用例

新型コロナウイルス感染症の影響で、マスク着用が一般的になったことから、顔認識システムにマスク検出機能を組み合わせるケースが増えています。

マスク検出と顔認識を併用することで、以下のような利点があります。

- マスク着用者の識別補助

マスクで顔の一部が隠れている場合、通常の顔認識精度が低下します。

マスク検出を行い、マスク着用状態を判別することで、認識アルゴリズムの切り替えや補正が可能です。

- 感染症対策のモニタリング

マスク未着用者を検知し、施設内の感染リスク管理に役立てられます。

- プライバシー保護

マスク着用者の顔画像を匿名化するなど、プライバシー保護の一環として活用できます。

実装例としては、OpenCVのdnnモジュールでマスク検出用の軽量CNNモデルを読み込み、顔検出後にマスクの有無を判定します。

マスク検出結果に応じて、顔認識の閾値調整や処理フローを分岐させることが一般的です。

個人情報保護規制対応のポイント

顔認識技術は個人情報を扱うため、各国・地域の個人情報保護規制に対応することが必須です。

主な対応ポイントは以下の通りです。

- データ最小化の原則

必要な情報のみを収集・保存し、過剰なデータ取得を避けること。

- 利用目的の限定と通知

収集した顔画像や認識データの利用目的を明確にし、利用者に通知または同意を得ること。

- 安全管理措置の実施

技術的・組織的な安全管理措置(アクセス制御、暗号化、監査ログなど)を講じること。

- 第三者提供の制限

個人情報を第三者に提供する場合は、法令に基づく適切な手続きを行うこと。

- 個人の権利尊重

利用者が自身の情報の開示、訂正、削除を求める権利を尊重し、対応体制を整備すること。

- プライバシー影響評価(PIA)

システム導入前にプライバシーリスクを評価し、リスク低減策を検討・実施すること。

- 継続的な監査と改善

運用状況を定期的に監査し、法令改正や技術進展に応じてポリシーを更新すること。

これらのポイントを踏まえ、法令遵守と利用者の信頼確保を両立させる運用が求められます。

専門家の助言を得ながら、適切なプライバシー保護体制を構築してください。

コードの保守と拡張

クラス設計例

顔認識システムのコードを保守しやすく、拡張しやすい形で構築するには、適切なクラス設計が重要です。

以下は、OpenCVを用いたリアルタイム顔検出を想定したシンプルなクラス設計例です。

#include <opencv2/opencv.hpp>

#include <vector>

#include <string>

class FaceDetector {

public:

// コンストラクタでモデルファイルのパスを受け取る

FaceDetector(const std::string& cascadePath);

// 顔検出を行い、検出結果の矩形を返す

std::vector<cv::Rect> detect(const cv::Mat& frame);

private:

cv::CascadeClassifier faceCascade_;

};

FaceDetector::FaceDetector(const std::string& cascadePath) {

if (!faceCascade_.load(cascadePath)) {

throw std::runtime_error("カスケード分類器の読み込みに失敗しました");

}

}

std::vector<cv::Rect> FaceDetector::detect(const cv::Mat& frame) {

std::vector<cv::Rect> faces;

cv::Mat gray;

cv::cvtColor(frame, gray, cv::COLOR_BGR2GRAY);

cv::equalizeHist(gray, gray);

faceCascade_.detectMultiScale(gray, faces, 1.1, 3, 0, cv::Size(30, 30));

return faces;

}この設計のポイントは以下の通りです。

- 責務の分離

FaceDetectorクラスは顔検出に特化し、他の処理(カメラ制御やUI表示)は別クラスや関数で扱います。

- 例外処理

モデル読み込み失敗時に例外を投げることで、呼び出し元で適切にエラー処理できます。

- 再利用性

検出処理をメソッド化し、任意の画像に対して呼び出せます。

拡張例として、DNNベースの顔検出クラスを派生クラスとして実装したり、検出パラメータを設定可能にしたりすることも可能です。

テスト自動化戦略

顔認識システムの品質を維持するためには、テスト自動化が欠かせません。

以下の戦略を参考にしてください。

- ユニットテスト

個々の関数やクラスの動作を検証します。

例えば、FaceDetector::detectが正しく矩形を返すか、異常入力時に例外を投げるかをテストします。

Google Testなどのフレームワークを利用すると便利です。

- 統合テスト

カメラ入力から顔検出、描画までの一連の処理が正しく連携して動作するかを確認します。

実際の映像やテスト用動画を使い、期待される検出結果が得られるか検証します。

- 回帰テスト

バグ修正や機能追加後に既存機能が壊れていないかをチェックします。

テストケースを継続的に実行し、品質を保ちます。

- CI/CDパイプラインへの組み込み

GitHub ActionsやJenkinsなどのCIツールにテストを組み込み、コードの変更時に自動でテストが走るようにします。

- テストデータ管理

多様な顔画像や環境条件を含むテストデータセットを用意し、実際の使用シナリオに近いテストを行います。

テスト自動化により、開発スピードを落とさずに品質を向上させられます。

リファクタリングの観点

保守性と拡張性を高めるために、定期的なリファクタリングが重要です。

顔認識コードにおける主なリファクタリングポイントは以下の通りです。

- コードの重複排除

顔検出や前処理、描画処理で似たコードが複数箇所にある場合は関数化やクラス化して共通化します。

- パラメータの外部化

検出パラメータ(scaleFactorやminNeighborsなど)をコード内にハードコーディングせず、設定ファイルや引数で変更可能にします。

- 責務の分割

顔検出、画像取得、UI表示、ログ管理など機能ごとにクラスやモジュールを分け、単一責任の原則を守ります。

- 例外処理の強化

エラー発生時に適切に例外を投げて捕捉し、プログラムの異常終了を防ぐ。

- コメントとドキュメント整備

処理の意図やパラメータの意味を明確にコメントし、新規開発者が理解しやすいコードにします。

- パフォーマンス改善

ボトルネックとなる処理を特定し、アルゴリズムの見直しや並列化を検討します。

これらのリファクタリングを継続的に行うことで、コードの品質を保ちつつ新機能の追加やバグ修正が容易になります。

トラブルシューティング集

detectMultiScale がゼロを返す

OpenCVのCascadeClassifier::detectMultiScale関数が顔を検出せず、空のベクターを返す場合は以下の点を確認してください。

- 入力画像の前処理

顔検出は通常グレースケール画像で行います。

カラー画像のままだと検出できません。

必ずcv::cvtColorでBGRからGRAYに変換し、必要に応じてcv::equalizeHistでヒストグラム平坦化を行いましょう。

- 画像の解像度とサイズ

画像が極端に小さい、または大きすぎると検出に失敗します。

minSizeやmaxSizeパラメータを適切に設定し、入力画像のサイズも適切にリサイズしてください。

- パラメータの調整

scaleFactorやminNeighborsの値が厳しすぎると検出されません。

例えば、scaleFactorは1.1〜1.3、minNeighborsは3〜6の範囲で調整してみてください。

- カスケードXMLファイルの読み込み

正しいXMLファイルを読み込んでいるか、パスが間違っていないか確認します。

読み込みに失敗していると検出は常にゼロになります。

- 顔の向きや表情

Haarカスケードは正面顔に強いですが、横顔や大きく傾いた顔は検出できないことがあります。

必要に応じてプロファイル用のカスケードも併用してください。

- 照明条件

暗すぎたり逆光だったりすると検出が難しくなります。

前処理で明るさ調整やデノイズを試みましょう。

これらを順に確認し、パラメータや前処理を調整することで検出率が改善します。

readNetFromCaffe エラー解決法

cv::dnn::readNetFromCaffe関数でモデル読み込み時にエラーが発生する場合、以下の原因と対策を確認してください。

- ファイルパスの誤り

.prototxtや.caffemodelファイルのパスが間違っていると読み込みに失敗します。

絶対パスや実行ファイルからの相対パスを正確に指定してください。

- ファイルの破損や不完全なダウンロード

モデルファイルが破損しているとエラーになります。

公式サイトや信頼できるソースから再ダウンロードしてください。

- OpenCVのバージョン非対応

モデルのフォーマットがOpenCVのバージョンでサポートされていない場合があります。

OpenCVを最新版にアップデートするか、モデルのバージョンを合わせてください。

- 依存ライブラリの不足

Caffeモデルの読み込みにはprotobufなどの依存ライブラリが必要です。

OpenCVをビルドした環境に不足がないか確認します。

- メモリ不足

大きなモデルを読み込む際にメモリ不足で失敗することがあります。

システムの空きメモリを確認し、不要なプロセスを停止してください。

- エラーメッセージの詳細確認

OpenCVの例外メッセージや標準出力に詳細なエラー内容が出ることがあります。

ログをよく読み、原因を特定しましょう。

これらの対策を行うことで、readNetFromCaffeのエラーを解消できます。

FPS低下の代表的原因

リアルタイム顔認識でFPS(フレームレート)が低下する主な原因は以下の通りです。

- 高解像度の入力画像

大きな画像は処理負荷が高く、推論時間が増加します。

適切な解像度にリサイズして処理しましょう。

- 非最適なモデル選択

重いモデル(ResNetベースなど)をCPUで推論すると遅くなります。

軽量モデル(MobileNetなど)やGPU推論を検討してください。

- GPU未使用または設定ミス

GPU対応環境でもバックエンドやターゲットがCPUになっていると速度が出ません。

setPreferableBackendとsetPreferableTargetの設定を確認しましょう。

- 前処理・後処理のボトルネック

画像の変換や描画処理が重い場合があります。

並列化や効率的なアルゴリズムに改善してください。

- 複数スレッドの競合

スレッド数が多すぎたり、他のプロセスがCPUを占有しているとパフォーマンスが落ちます。

スレッド数の調整やシステム負荷の監視が必要です。

- メモリ不足やスワップ発生

メモリが不足するとディスクスワップが発生し、極端に遅くなります。

メモリ使用状況を監視し、不要なアプリを停止してください。

- I/O遅延

カメラやディスクからの読み込みが遅い場合もFPS低下の原因になります。

高速なカメラやSSDの利用を検討しましょう。

これらの原因を一つずつ検証し、適切な対策を講じることでFPSの改善が期待できます。

まとめ

本記事では、C++とOpenCVを用いたリアルタイム顔認識の基本から応用まで幅広く解説しました。

HaarカスケードやDNNを活用した顔検出の仕組みや実装ポイント、パフォーマンス最適化、精度向上のテクニック、さらにはプライバシー配慮や将来的な応用例まで網羅しています。

これにより、顔認識システムの開発・運用に必要な知識と実践的なノウハウを効率よく習得できます。