【C++】OpenCVで実装するエピポーラルジオメトリの基本と活用方法

C++とOpenCVを利用してエピポーラルジオメトリを扱うと、ステレオ画像間の対応点から基礎行列を求め、各画像にエピポーラ線を導出する手法が実現できます。

これにより、対応点の探索が円滑になり、画像処理アルゴリズムが実用的かつ効率的に動作する点が魅力です。

エピポーラルジオメトリの基本

カメラ間の投影関係

エピポーラ平面の定義

エピポーラ平面は、3次元空間上の1点と2つのカメラ中心を含む平面のことです。

画像上の点とカメラ中心を結んだ直線が、もう片方の画像においてエピポーラ線として投影される関係を示してくれます。

この関係は、画像間で対応点を求める際の指針となるため、大変重要な概念となります。

たとえば、2枚の画像で同じ対象を撮影する場合、対象点に対応するエピポーラ線が、もう一方の画像上で対応位置の候補を示してくれます。

カメラ配置と視点の関係

カメラの配置や視点の違いが、エピポーラ平面の形状に影響を与えます。

左右に配置されたカメラの場合、エピポーラ線はほぼ水平に現れることが多く、深度情報を抽出する際の計算に利用することができます。

カメラ同士の距離や向き、さらには内部パラメータが、最終的なエピポーラ関係に繊細な影響を及ぼすため、各カメラのキャリブレーションが重要となります。

実際のアプリケーションでは、これらの情報を基にして、適切なエピポーラ制約を与えることで、より安定した対応付けを実現できます。

基礎行列算出プロセス

エピポーラルジオメトリの計算において、基礎行列(Fundamental Matrix)の算出は核となる部分です。

これは、対応点の関係を数式的に整理する役割を担っており、計算によりエピポーラ線が求められる仕組みになっています。

基礎行列の推定にあたっては複数の工程が含まれ、各工程で工夫が必要になります。

対応点抽出の手法

対応点は、両方の画像上で同じ対象となる特徴的な点を指し、これを抽出するために特徴点検出・記述手法が用いられます。

一般的には、以下のようなアプローチが採用されます。

- 画像の前処理によるノイズ除去

- コーナー検出やエッジ検出による特徴点抽出

- 特徴量の記述と比較による対応点の設定

各手法は、シーンや画像の特性に応じて使い分けられるため、柔軟な実装が求められます。

特徴点検出の比較

画像内の特徴点の検出には、ORB、SIFT、SURFなどの手法が利用されることが多くなっています。

ORBの場合、軽量で高速な計算が可能なため、リアルタイム処理が必要なアプリケーションに向いています。

| 特徴点検出手法 | 処理速度 | 特許の問題 | 特徴量記述の精度 |

|---|---|---|---|

| ORB | 高速 | なし | 十分 |

| SIFT | やや遅い | あり | 非常に高い |

| SURF | 中程度 | あり | 高い |

これらの手法を目的に合わせて適切に選択することが、システム全体の精度向上に繋がります。

マッチング戦略の工夫

対応点のマッチングにあたっては、基本的なBrute-Forceマッチング以外にも、以下のような工夫が求められる場合があります。

- 距離比テストによる誤マッチの排除

- ニューラルネットワークを用いた特徴量の最適化

- マルチスケール特徴量の統合

これらの戦略を取り入れることで、対応点の信頼性を高められるため、精度が向上します。

外れ値除去の工夫(RANSACなど)

対応点抽出やマッチングの段階で得られるデータには、必ず外れ値が存在することが想定されます。

そのため、RANSAC(ランダムサンプリングコンセンサス)を用いて頑健に基礎行列を推定することが一般的です。

この方法は、誤った対応点を自動的に排除し、多数のインライア点に基づいた計算を行うため、結果の精度が安定します。

また、閾値を適切に調整することで、より厳しい外れ値除去が可能になるため、シーンに合わせたパラメータ設定が重要となります。

C++とOpenCVによる実装詳細

画像処理と特徴点検出

エピポーラルジオメトリの実装では、画像の前処理から特徴点の抽出までが大切です。

画像のコントラスト調整やノイズ除去を行うことで、特徴点検出の精度が向上し、後続のプロセスにも良い影響を与えます。

画像前処理の流れ

画像前処理では、基本的に以下のような手順が取られます。

- グレースケール変換:RGB画像を取り扱いやすい形式に変換する

- ガウシアンフィルタや平滑化処理:ノイズを削減して特徴点を安定化

- ヒストグラム均一化:明るさやコントラストの調整を行い、特徴点検出のしやすさを向上させる

これらの工程により、画像全体の品質が向上し、後続の特徴点検出工程での誤認識を抑えることが可能となります。

ORBによる特徴量抽出

ORBは、OpenCVで手軽に使える特徴点検出アルゴリズムとして人気があります。

計算速度と精度がバランス良く、実用的なシーンで多く採用されている手法です。

以下に、ORBを用いた基本的なコードサンプルを示します。

#include <iostream>

#include <opencv2/core.hpp>

#include <opencv2/highgui.hpp>

#include <opencv2/imgproc.hpp>

#include <opencv2/features2d.hpp>

int main() {

// 画像の読み込み(サンプル画像のパスを指定)

cv::Mat image = cv::imread("sample.jpg", cv::IMREAD_GRAYSCALE);

if (image.empty()) {

std::cout << "画像が読み込めませんでした" << std::endl;

return -1;

}

// ORB特徴量検出器の生成

cv::Ptr<cv::ORB> orbDetector = cv::ORB::create();

// 特徴点と記述子の格納先

std::vector<cv::KeyPoint> keypoints;

cv::Mat descriptors;

// 特徴点検出と記述子抽出

orbDetector->detectAndCompute(image, cv::Mat(), keypoints, descriptors);

// 検出された特徴点の数を出力

std::cout << "検出された特徴点の数 : " << keypoints.size() << std::endl;

// 特徴点を画像に描画

cv::Mat outputImage;

cv::drawKeypoints(image, keypoints, outputImage, cv::Scalar::all(-1));

// 結果を表示

cv::imshow("ORB Feature Points", outputImage);

cv::waitKey(0);

return 0;

}検出された特徴点の数 : [特徴点数は画像内容に依存]上記のコードでは、sample.jpgという画像ファイルからグレースケール画像を読み込み、ORBを用いて特徴点を抽出しています。

検出された特徴点の数が標準出力に表示され、描画結果がウィンドウに表示されます。

このコードは、実際の画像処理のベースとして使えるため、柔軟に応用することが可能です。

対応点マッチングと基礎行列推定

画像上で抽出した特徴点同士の対応付けを行い、その結果をもとに基礎行列を推定する処理が、本技術の肝となります。

ここでは、対応点マッチングの方法と基礎行列推定のアルゴリズムについて説明します。

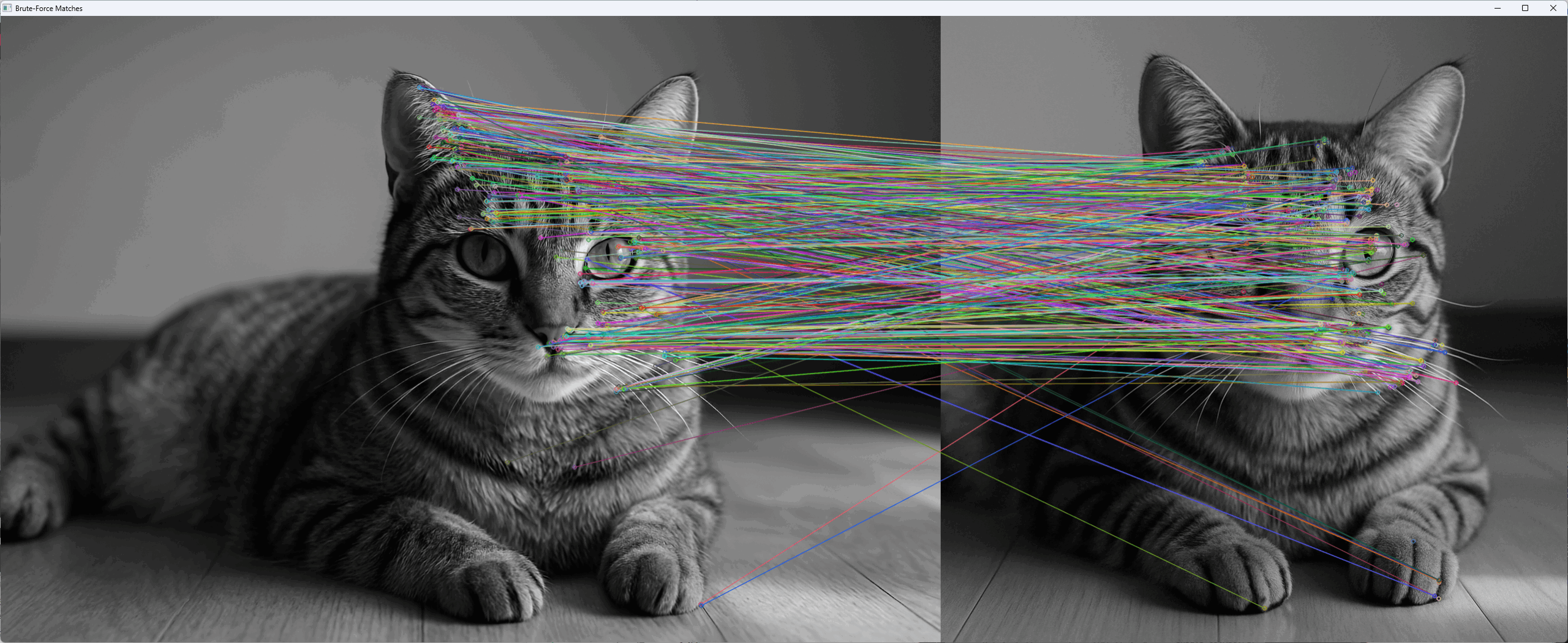

Brute-Forceマッチングの適用

Brute-Forceマッチングは、特徴量の距離を計算して、最も類似する組み合わせを対応点として採用するシンプルな方法です。

OpenCVでは、cv::BFMatcherクラスを活用することで簡単に実装できます。

以下は、その基本的なサンプルコードです。

#include <iostream>

#include <opencv2/core.hpp>

#include <opencv2/highgui.hpp>

#include <opencv2/imgproc.hpp>

#include <opencv2/features2d.hpp>

int main() {

// 画像読み込み(左右の画像を用意)

cv::Mat imgLeft = cv::imread("left.jpg", cv::IMREAD_GRAYSCALE);

cv::Mat imgRight = cv::imread("right.jpg", cv::IMREAD_GRAYSCALE);

if (imgLeft.empty() || imgRight.empty()) {

std::cout << "画像の読み込みに失敗しました" << std::endl;

return -1;

}

// ORB特徴量検出器の生成

cv::Ptr<cv::ORB> orb = cv::ORB::create();

// 特徴点と記述子検出

std::vector<cv::KeyPoint> keypointsLeft, keypointsRight;

cv::Mat descriptorsLeft, descriptorsRight;

orb->detectAndCompute(imgLeft, cv::Mat(), keypointsLeft, descriptorsLeft);

orb->detectAndCompute(imgRight, cv::Mat(), keypointsRight, descriptorsRight);

// Brute-Forceマッチャーの生成(Hamming距離を使用)

cv::BFMatcher matcher(cv::NORM_HAMMING);

std::vector<cv::DMatch> matches;

matcher.match(descriptorsLeft, descriptorsRight, matches);

// マッチング結果の描画

cv::Mat imgMatches;

cv::drawMatches(imgLeft, keypointsLeft, imgRight, keypointsRight, matches, imgMatches);

cv::imshow("Brute-Force Matches", imgMatches);

cv::waitKey(0);

return 0;

}[左右の画像間で対応点が線で結ばれたウィンドウが表示されます]

このコードでは、左右の画像からORBを用いて特徴点と記述子を抽出し、Brute-Forceマッチングにより対応点のペアを求めています。

描画結果として、対応点間を結ぶ線が表示され、マッチングの精度を視覚的に確認できるようになっています。

基礎行列推定アルゴリズム

対応点が得られた後、cv::findFundamentalMat関数を用いて基礎行列を推定する処理を行います。

基礎行列 \(F\) は、エピポーラ線の計算に利用され、以下の数式で表すことができます。

\[\mathbf{x’}^T F \mathbf{x} = 0\]

ここで、\(\mathbf{x}\) と \(\mathbf{x’}\) はそれぞれ左右の画像上の対応点を表します。

RANSAC法などの外れ値除去手法を組み合わせることで、推定精度が向上し、より正確なエピポーラ線が求められます。

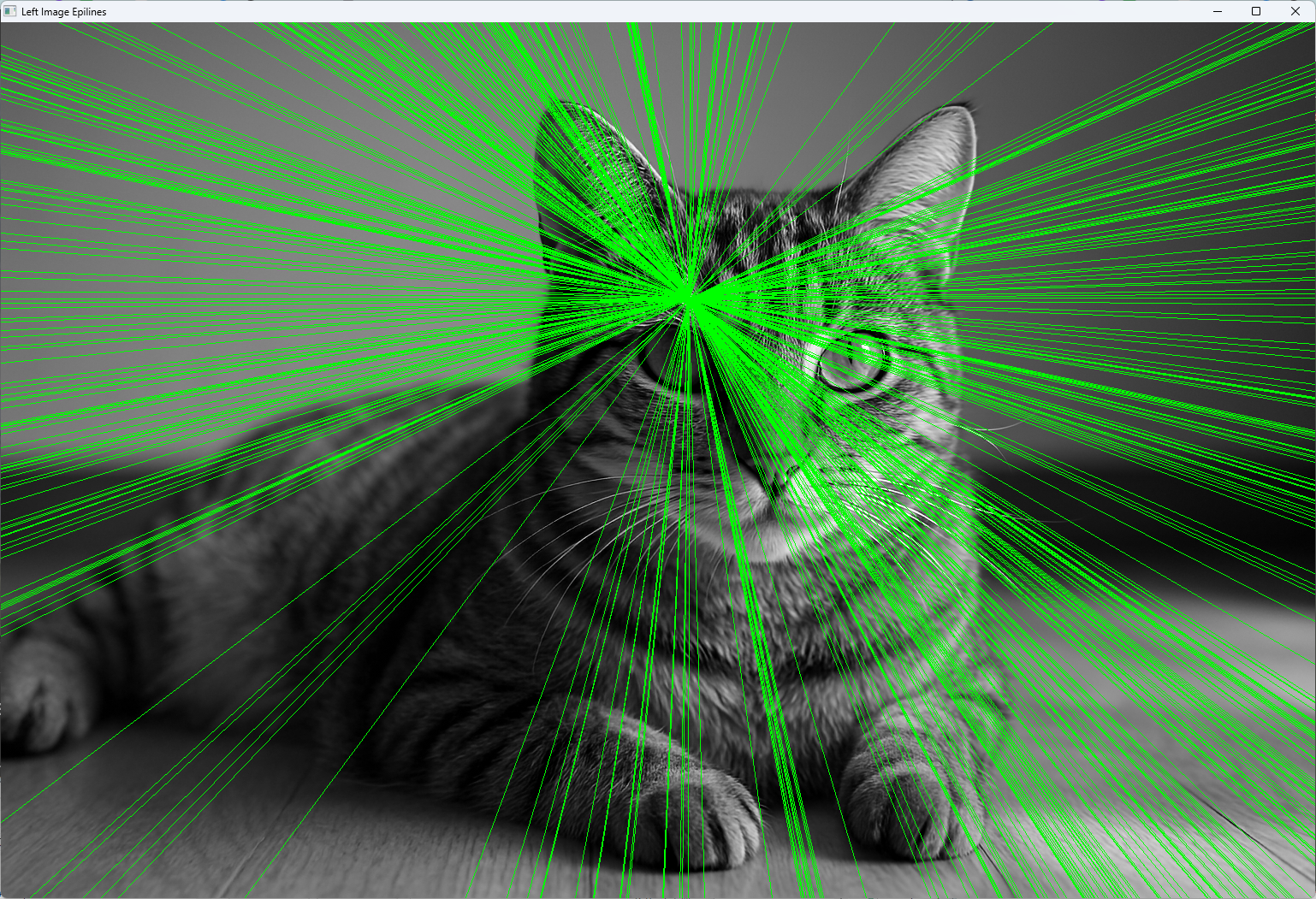

エピポーラ線生成と可視化

エピポーラ線の生成は、対応関係を視覚的に表現するための大切なプロセスです。

計算した基礎行列を利用して、各対応点に関連するエピポーラ線を算出し、画像上に描画します。

エピポーラ線計算の手法

OpenCVのcv::computeCorrespondEpilines関数を使用することで、指定した画像の対応点からエピポーラ線を求めることができます。

この計算結果は、各エピポーラ線を表す係数\((a, b, c)\)として得られ、線の方程式は次のように記述されます。

\[ax + by + c = 0\]

各ラインの係数をもとに、画像上の2点を計算して線分として描画する方法が、一般的に採用されています。

描画処理の工夫

エピポーラ線の描画にあたっては、以下の点に注意すると良いです。

- 複数の線が重ならないように、色や太さを調整する

- 対応点の位置とエピポーラ線が一致することを確認するためのデバッグ表示を行う

- 画像サイズに合わせた描画範囲を自動計算することで、どの解像度でも適正に表示する

以下に、エピポーラ線の描画の一例を示します。

#include <iostream>

#include <opencv2/calib3d.hpp>

#include <opencv2/core.hpp>

#include <opencv2/highgui.hpp>

#include <opencv2/imgproc.hpp>

#include <opencv2/features2d.hpp>

int main() {

// 画像と対応点の初期化(サンプルの左右の画像を使用)

cv::Mat imgLeft = cv::imread("left.jpg", cv::IMREAD_GRAYSCALE);

cv::Mat imgRight = cv::imread("right.jpg", cv::IMREAD_GRAYSCALE);

if (imgLeft.empty() || imgRight.empty()) {

std::cout << "画像が読み込めませんでした" << std::endl;

return -1;

}

// ORBを用いて特徴点と記述子を抽出する(前処理省略)

cv::Ptr<cv::ORB> orb = cv::ORB::create();

std::vector<cv::KeyPoint> keypointsLeft, keypointsRight;

cv::Mat descriptorsLeft, descriptorsRight;

orb->detectAndCompute(imgLeft, cv::Mat(), keypointsLeft, descriptorsLeft);

orb->detectAndCompute(imgRight, cv::Mat(), keypointsRight, descriptorsRight);

// Brute-Forceマッチングによる対応点の取得

cv::BFMatcher matcher(cv::NORM_HAMMING);

std::vector<cv::DMatch> matches;

matcher.match(descriptorsLeft, descriptorsRight, matches);

// 対応点の座標集合を用意

std::vector<cv::Point2f> ptsLeft, ptsRight;

for (const auto &match : matches) {

ptsLeft.push_back(keypointsLeft[match.queryIdx].pt);

ptsRight.push_back(keypointsRight[match.trainIdx].pt);

}

// 基礎行列の推定(RANSACを使用)

cv::Mat F = cv::findFundamentalMat(ptsLeft, ptsRight, cv::FM_RANSAC);

// 右画像の対応点に対するエピポーラ線を左画像に計算

std::vector<cv::Vec3f> linesLeft;

cv::computeCorrespondEpilines(ptsRight, 2, F, linesLeft);

// エピポーラ線描画(左画像)

cv::Mat imgLeftColor;

cv::cvtColor(imgLeft, imgLeftColor, cv::COLOR_GRAY2BGR);

for (const auto &line : linesLeft) {

// 画像左端(x=0)と右端(x=imgLeft.cols)におけるy座標を計算

int y0 = static_cast<int>(-line[2] / line[1]);

int y1 = static_cast<int>(-(line[2] + line[0] * imgLeft.cols) / line[1]);

cv::line(imgLeftColor, cv::Point(0, y0), cv::Point(imgLeft.cols, y1), cv::Scalar(0, 255, 0), 1);

}

cv::imshow("Left Image Epilines", imgLeftColor);

cv::waitKey(0);

return 0;

}左画像上に緑色のエピポーラ線が複数本描画され、対応点の関係が視覚的に確認できる

このサンプルでは、左右の画像から対応点を用いて基礎行列を推定し、右画像の対応点から左画像上のエピポーラ線を計算して描画しています。

描画されたエピポーラ線により、対応関係が直感的に把握できるよう工夫されています。

エピポーラルジオメトリの応用事例

ステレオビジョンへの実用例

エピポーラルジオメトリの知識は、ステレオビジョンシステムにも広く応用できます。

画像間の対応関係を利用することで、対象物までの距離情報を取得することも可能となっています。

深度推定への導入

複数のカメラから取得した左右画像のエピポーラ線を利用して、対象物の深度を推定する技術があります。

深度推定では、各対応点における視差(disparity)から距離を計算するため、エピポーラ制約が大きな役割を果たします。

視差とカメラパラメータを考慮し、以下の式で深度 \(Z\) を求めることができます。

\[Z = \frac{f \cdot B}{d}\]

ここで、\(f\) は焦点距離、\(B\) はカメラ間の距離、\(d\) は視差です。

この関係式により、対象物までの距離が具体的に算出され、車両の自動運転やロボットのナビゲーションといった応用が現実のものとなっています。

両眼画像の連動解析

左右の画像の対応点を正確に求めることで、両眼画像間の連動性を解析することができます。

対応点情報は、対象物の動きや変化を解析する際の基盤としても使えるため、動体追跡や変化検知といった分野に応用することが可能です。

連動解析により、カメラ間の時間差や小さなズレも補正できるため、よりスムーズな画像解析が実現します。

3次元再構成と解析

エピポーラルジオメトリは、複数画像から3次元形状を再構成する技術にも活用されます。

対象点の位置情報を三角測量法などを用いて、3次元座標に変換することで、空間内の形状や構造を解析できるようになります。

三角測量法の活用

3次元再構成は、2次元画像上の対応点情報を活用して、各点の位置を三角測量法により算出する方法が代表的です。

以下の流れで進めることが一般的です。

- 各画像から抽出された対応点のペアを用意

- カメラ内部・外部パラメータを適用して、各対応点の視線を計算

- 視線同士の交点を求めて、3次元座標を推定

対象物全体の3次元形状を復元する際に、ノイズ除去や最適化技術を併用することで、リアルな再構成が実現します。

3D復元の注意点

3D復元においては、以下の点に気を付けるとよいです。

- キャリブレーションの精度が復元結果に直結する

- 対応点の精度や数が不足すると、再構成が不安定になる

- 外れ値の影響を最小限にするための前処理(例えばRANSAC)が有用

これらの注意点を踏まえることで、実際の応用シーンにおいても、より信頼性の高い3D再構成が実現できます。

マルチカメラシステムへの拡張

複数のカメラが設置されるマルチカメラシステムでは、エピポーラルジオメトリの応用がさらに広がります。

異なる視点から得られる情報を統合することで、広範な領域の情報取得や、複雑な環境下での認識が可能になります。

システム設計の考慮点

マルチカメラシステムの設計にあたっては、以下の点が考慮されます。

- 各カメラの配置と向きの最適化

- 異なるカメラ間の時刻合わせ(同期)

- キャリブレーション作業の自動化や補正技術

これらの項目に工夫を加えると、システム全体の連動性が向上し、より緻密な解析に繋がります。

拡張アルゴリズムの応用

マルチカメラシステムでは、標準的なエピポーラ計算に加えて、拡張アルゴリズムが必要になる場合があります。

たとえば、以下のような応用が考えられます。

- 複数視点からの3D復元アルゴリズムの統合

- カメラ間の重複領域での情報融合

- 時系列データを利用した動作解析

これらの拡張アルゴリズムは、各カメラからのデータを柔軟に統合するためのキーとなり、実際のシステムに応じたカスタマイズが行われています。

まとめ

今回の記事では、エピポーラルジオメトリの基本から、C++とOpenCVを活用した実装の詳細、さらにその応用事例に至るまでを紹介しました。

エピポーラ平面や基礎行列の理解を深めることで、画像間の対応点抽出やエピポーラ線の描画がスムーズになり、ステレオビジョンや3次元再構成、マルチカメラシステムなどさまざまな分野での応用が期待できます。

各工程での工夫やアルゴリズムの選択、パラメータ調整を大切にしながら開発を進めると、より精度が高く、柔軟なシステムが構築できるでしょう。